NVIDIA Turing新品双发,AGX阵容与Tesla T4亮相GTC日本站

▲点击上方 雷锋网 关注

文 | 任然

来自雷锋网(leiphone-sz)的报道

雷锋网消息,2018年9月13日,NVIDIA在GTC 2018日本站上介绍了该公司在AI方面的最新进展,CEO黄仁勋公布了NVIDIA TensorRT超大规模平台、NVIDIA Drive AGX Xavier开发套件以及Jetson AGX Xavier开发套件等新品,并补充了Quadro RTX和Geforce RTX的新消息。

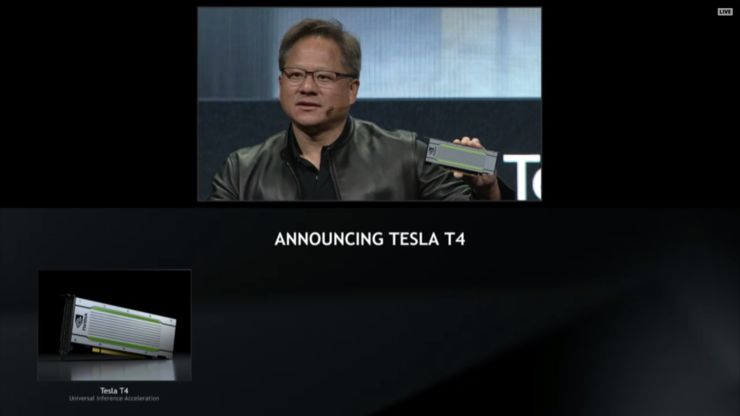

TensorRT超大规模平台是一整套硬件和软件产品,这些产品针对强大、高效的推理进行了优化,整套系统的关键要素包括基于Turing架构的Tesla T4专业计算卡、TensorRT 5和TensorRT推理服务器。

Tesla T4是一款独特的GPU产品,专为AI推理工作负载而设计,如处理视频,语音,搜索引擎和图像的神经网络。Tesla T4配备16GB GDDR6,GPU中集成320个Turing Tensor Core和2560个Turing CUDA Core,这款全新GPU具有突破性的性能,以及FP32/FP16/INT8/INT4等多种精度的运算能力,FP16的峰值性能为65T,INT8为130T,INT4为260T。

作为上一代Tesla P4的继任者,Tesla T4采用高能效的75瓦小型PCIe封装,可轻松适用于大多数服务器。NVIDIA称其可在相同的功率范围内提供高达12倍的性能提升,可能为推理工作负载的功效设定了新的标准。

Tesla T4还具有针对AI视频应用的优化功能,此功能由硬件转码引擎提供动力,提供两倍于Tesla P4的性能。NVIDIA表示Tesla T4可以同时解码多达38个全高清视频流。

围绕Tesla T4的一系列技术,NVIDIA公布了TensorRT Hyperscale平台。该平台支持PyTorch、TensorFlow、MXNet和Caffee2等所有主要的深度学习框架,NVIDIA还为其配套提供了推理优化器和运行时引擎TensorRT 5,这是Nvidia深度学习推理优化器和运行时引擎的新版本,支持Turing Tensor Core,并对适用于多精度工作负载的神经网络优化集进行了扩展。此外还公布了为Turing优化的CUDA 10,其中包括优化的库、编程模型和图形API互操作性。

而TensorRT推理服务器这一容器化的微服务软件使应用能够在数据中心生产中采用AI模型,其在NVIDIA GPU Cloud容器注册中免费提供,可实现数据中心吞吐量和GPU利用率的最大化,支持所有常用AI模型和框架,并集成了Kubernetes和Docker。

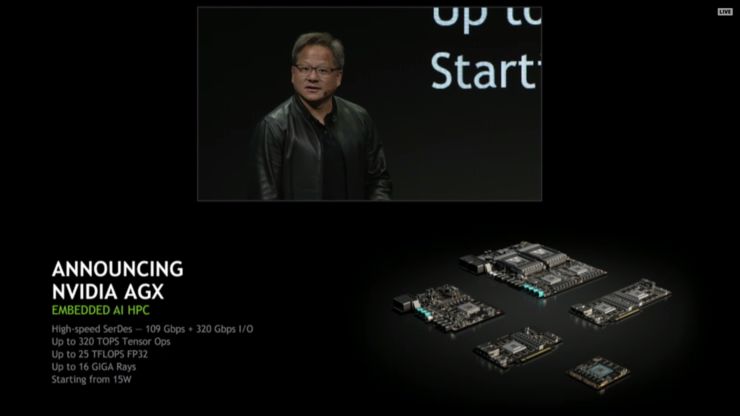

会上,NVIDIA还公布了其AGX阵容,这是其基于Xavier的产品系列的新名称,产品阵容包括Drive Xavier和新推出的Drive Pegasus,此次主要介绍的是Drive AGX Xavier开发套件,这是一个用于构建自动驾驶系统的平台。这种开放、可扩展的软件和硬件解决方案使公司能够无缝地开发和测试定制的自动驾驶技术,简化生产。NVIDIA还提供类似的Clara平台,专为医疗应用而设计,作为疾病早期检测、诊断和治疗的新工具。

而作为AGX阵容的另外一部分,NVIDIA还推出了Jetson AGX Xavier开发套件,部分日本的工业和制造商率先开始使用该新系统。

作为世界上第一台为人工智能、机器人和边缘计算而创建的计算机,Jetson AGX Xavier的大规模计算性能可以处理对下一代机器人至关重要的测距、定位、测绘、视觉和感知以及路径规划。同时黄仁勋在今天GTC大会上介绍到,雅马哈汽车公司将选择NVIDIA Jetson AGX Xavier作为开发系统,为其即将推出的自动机器系列提供动力。

据雷锋网了解,NVIDIA预计未来五年内人工智能推理的总体有效市场将增长至200亿美元,将成为NVIDIA、Intel和AMD之间激烈争夺的战场,因此专注于提升人工智能推理性能可以看做是一项战略举措。

Intel凭借其服务器处理器市场在这一争夺中具有初始优势,然而像Tesla T4这样低成本和低功耗的推理加速器,正在凭借其优异的每瓦特性能对传统CPU计算市场构成巨大威胁。

雷锋网大招募开始了!如果你对人工智能、大数据、云计算、自动驾驶等前沿科技感兴趣,对采编、运营、品牌等职位感兴趣,请猛戳 招聘启事

◆ ◆ ◆

推荐阅读

iPhone XS Max评测:来自一万二的碾压!?

美团上市了!市值超越小米京东,王兴感谢乔布斯

详解腾讯AI布局,2B业务或将崛起

为什么 AI 芯片时代必然到来——从TPU开始的几十倍性能之旅

关于峰会购票信息,点击“阅读原文”了解详情~