【Nature论文】深度网络中的梯度下降复杂度控制

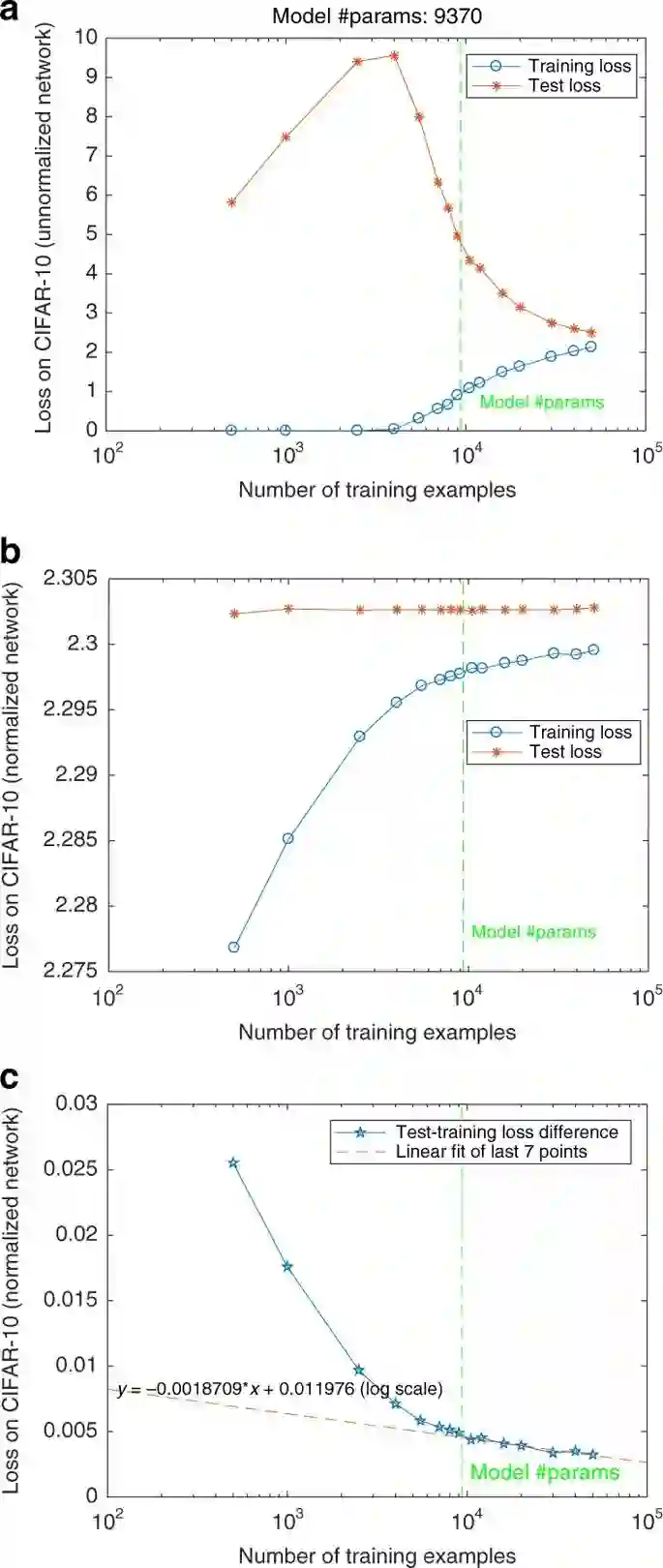

尽管在训练过程中缺乏显式的复杂性控制,如显式正则化项,但参数化过度的深层网络预测效果良好。对于指数型损失函数,我们通过在与分类相关的归一化权值方面展示梯度下降的有效正则化效果来解决这个难题。

https://www.nature.com/articles/s41467-020-14663-9

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“CGD” 就可以获取《Nature论文—深度网络中的梯度下降复杂度控制》专知下载链接

登录查看更多

相关内容

专知会员服务

57+阅读 · 2020年3月13日