学界 | 为卷积模型执行加入循环和远程反馈,更完整地拟合生物视觉

作者:Aran Nayebi等 来源:arXiv,机器之心

大脑的感觉系统必须要在复杂的有噪声感觉数据中检测出有意义的模式 [James, 1890]。视觉环境可以揭示对象的积极或消极性质,包括食物种类、危险标志以及令人记忆犹新的社会伙伴。这些对象在每一时刻的位置、姿势、对比度、背景以及前景都各不相同。因此,从低级图像属性中进行目标检测是很不容易的 [Pinto 等人,2008]。灵长类动物的视觉系统会对相关的高级属性进行编码,以便指导行为 [Majaj 等人,2015]。这一过程可被建模为把一张图从原始像素值转换为内部表征 [DiCarlo 等人,2012]。好的编码算法能够将任务的相关特征提供给简单的解码过程,如线性分类器 [Hung 等人,2005,Majaj 等人,2015]。

近期的研究工作表明,基于任务优化的深度卷积神经网络(CNN)是灵长类动物大脑视觉编码的精准量化模型 [Yamins 等人,2014,Khaligh-Razavi 和 Kriegeskorte,2014,Güçlü 和 van Gerven,2015]。目前与其他模型类别相比,用于识别 ImageNet 目标的 CNN 可以更好地解释视觉系统中神经元的平均时间响应(temporally-averaged response)。来自底层、中层、高层的卷积层的模型单元分别提供了发生在早期(V1 区 [Khaligh-Razavi 和 Kriegeskorte,2014,Cadena 等人,2017])、中期(V4 区 [Yamins 等人,2014])和更高的视觉皮层区域(下颞叶皮质,即 IT 区,[Khaligh-Razavi 和 Kriegeskorte,2014,Yamins 等人,2014])的神经诱发反应的已知最好线性预测值。

但灵长类动物的视觉系统还有不能用前馈 CNN 建模的其他解剖结构。这些结构包括每个皮层区域内密集的局部循环连接以及不同区域间的远程连接,例如从视觉层次的较高部分到较低部分的反馈 [Gilbert 和 Wu,2013]。灵长类动物大脑的视觉系统中「循环」(recurrence)的功能尚未得到充分研究。一些猜想认为循环「填补」了缺失数据 [Spoerer 等人,2017,Michaelis 等人,2018,Rajaei 等人,2018,Linsley 等人,2018],如被其他物体遮挡住的物体部分;一些猜想认为循环通过自上而下的注意力特征的细化「锐化」了表征,以便对特定的刺激因素或特定任务的性能进行解码 [Gilber 和 Wu,2013,Lindsay,2015,McIntosh 等人,2017,Li 等人,2018];一些猜想认为循环允许大脑「预测」未来的刺激信号(如电影的帧)[Rao 和 Ballard,1999,Lotter 等人,2017,Issa 等人,2018];还有一些猜想认为循环「扩展」了前馈计算,这意味着展开的循环网络等价于通过多次重复变换来保存神经元(和可学习参数)的更深层前馈网络 [Khaligh-Razavi 和 Keirgeskorte,2014,Liao 和 Poggio,2016,Zamir 等人,2017,Leroux 等人,2018]。

因为现有的神经数据无法排除这些可能性,所以计算模型可能有助于对这些假设进行评估。我们试着将来自前馈 CNN 和神经信号时间平均值的目标驱动建模方法 [Yamins 和 DiCarlo,2016,Mante 等人,2013,Shi 等人,2018] 扩展到卷积循环神经网络(ConvRNN)和神经动态(neural dynamics)。具体来说,我们假设给 CNN 添加循环和反馈有助于这些模型执行行为相关任务(ethologically-relevant task),并且这样的增强网络可以更好地解释视觉路径中神经响应的精细时间轨迹。

尽管添加了循环结构的增强 CNN 已用于解决相对简单的遮挡变形和预测未来的任务 [Spoerer 等人,2017,Lotter 等人,2017],但这些模型既无法泛化到前馈 CNN 执行的较困难任务(如识别 ImageNet 数据集中的目标),也无法像 ImageNet 优化的 CNN 一样对神经响应作出解释。在本文的撰写过程中,在 ImageNet 中进行目标识别是已知仅有的可以产生与视觉皮层神经元激活模式相仿的 CNN 激活模式的任务 [Khaligh-Razavi 和 Kriegeskorte,2014,Yamins 等人,2014,Cadena 等人,2017]。事实上,由于多样性和复杂性,ImageNet 包含许多可以根据上述假设(例如严重遮挡、出现多个前景目标等)利用循环过程的图像。此外,近期一些针对 ImageNet 的最有效方法(如 ResNet 模型 [He 等人,2016])是在多个层上重复相同的架构模式,这说明它们可能与较浅的循环网络的展开近似 [Liao 和 Poggio,2016]。因此我们试着探索循环是否可以改善在 ImageNet 数据集上的分类性能。尽管其他研究是将 CNN 的输出作为 RNN 的输入来解决目标分割等视觉任务 [McIntosh 等人,2017],但我们选择将循环架构整合进 CNN 中,因为这样的架构在神经科学文献中很普遍。

我们发现标准的循环单元(例如标准 RNN 和 LSTM [Elman,1990,Hochreiter 和 Schmidhuber,1997])不会使 ImageNet 性能提升至超越参数匹配的前馈基线的水平。但我们设计了新的局部单元架构,该架构包含用于将循环架构集成到 CNN 中的结构属性。为了在广泛的模型架构空间中更好地识别模型架构,我们在数以千计的模型上进行了自动搜索,这些模型的局部循环单元和远程反馈连接有所不同。引人注目的是我们在这个过程中发现了在传统 RNN 中从未发现过的新的循环模式:例如,最成功的模型会用深度可分离的卷积专门处理局部循环连接,从而对网络中类似 ResNet 的前馈骨干网络进行多重门控。此外,小部分远程反馈连接可以提升任务性能,尽管大多数只具备中性或负面影响。总的来讲,这种搜索产生的循环模型在仅使用 75% 的参数时,表现与更深层的前馈架构(ResNet-34)差不多。最后,在比较循环模型特征和灵长类动物视觉系统中的神经响应后,我们发现基于 ImageNet 优化的 ConvRNN 提供了以 10ms 分辨率跨越中高层视觉皮层区域的精准量化的神经动态模型。这些结果提供了一个视觉系统中的局部和远程循环如何调整以适应在灵长类动物的视觉系统中执行目标识别的模型。

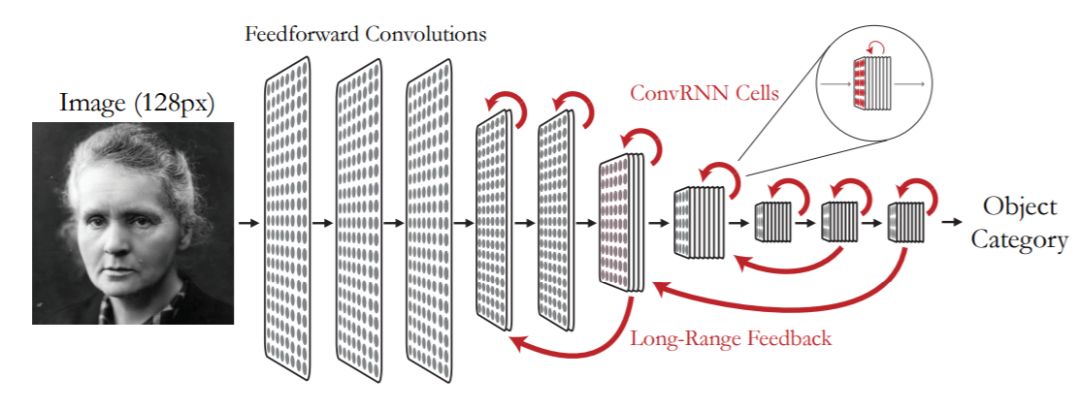

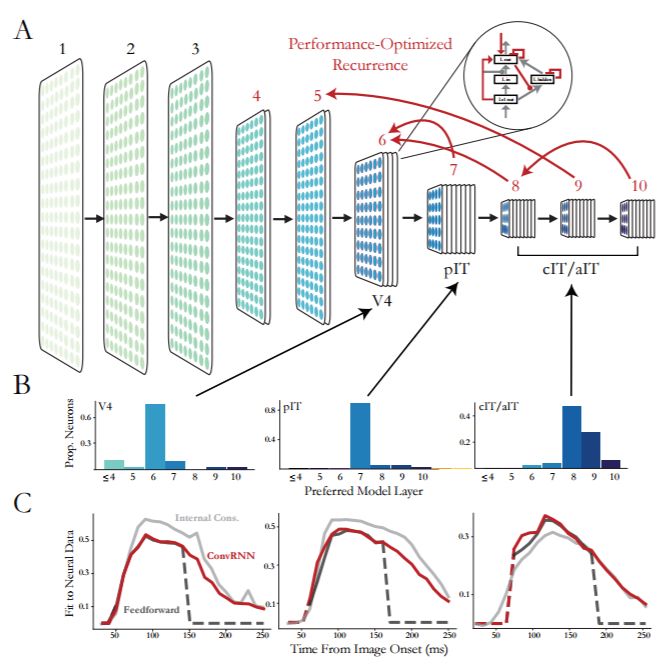

图 1:模型架构示意图。卷积循环网络(ConvRNN)是将局部循环单元和远程反馈连接组合在一起添加到 CNN 的骨干网络上。在我们的实现中,沿着黑色或红色箭头进行的传播需要一个时间步(10 ms)来模拟皮质层间的传导延迟。

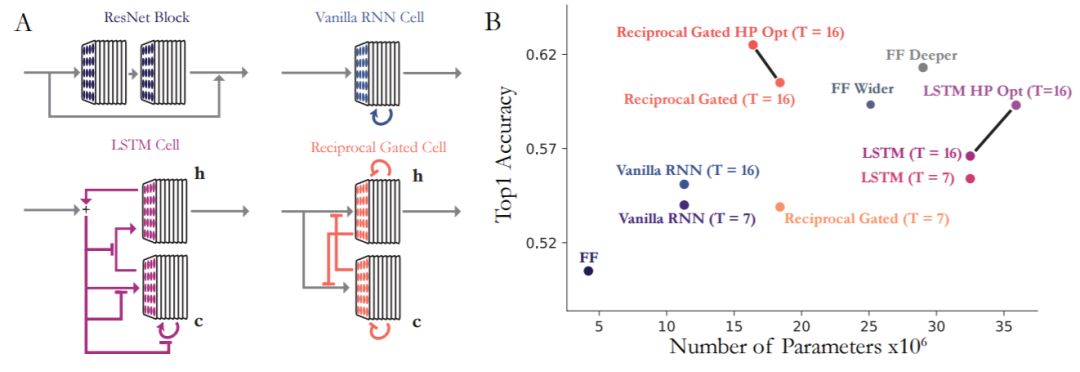

图 2:局部循环单元架构的比较。(a)ConvRNN 单元间的架构差异。标准 ResNet 和标准 RNN 单元都有旁路(见论文)。LSTM 单元有门控,在图中用 T 字连接符表示,但是没有旁路。reciprocal 门控单元两个都有。(b)多种 ConvRNN 和前馈模型随着参数数量变化产生的性能变化。彩色的点将相应的 RNN 单元合并到 6 层前馈架构(「FF」)中。「T」表示展开的步数。经过超参数优化的 LSTM ConvRNN 和 reciprocal 门控单元 ConvRNN 通过黑线连接到未优化版本。

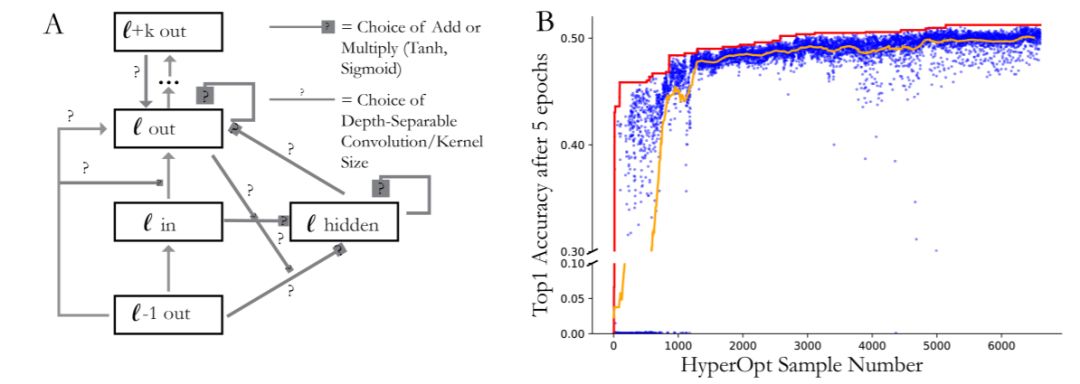

图 3:ConvRNN 的超参数化和搜索结果。(a)局部循环单元的超参数化。箭头表示输入单元、隐藏状态和输出之间的连接。问号表示可选连接,可能是常规或深度可分离的卷积,可选择卷积核大小。层(l-1 out、l in 和 l out)之间的反馈连接始终存在。带有问号的方框表示可选择 sigmoid 或 tanh 非线性激活函数、加法,或恒等连接(identity connection,像 ResNet 中一样)这样的多重门控。最终,从 l+k out 层开始的远程反馈连接可能会进入局部单元输入、隐藏状态或输出。(b)ConvRNN 搜索结果。每个蓝色的点都表示一个模型,采样自训练了 5 个 epoch 的超参数空间。橙色的线是最后 50 个模型的平均性能。红色的线表示搜索过程中该点表现最好的模型。

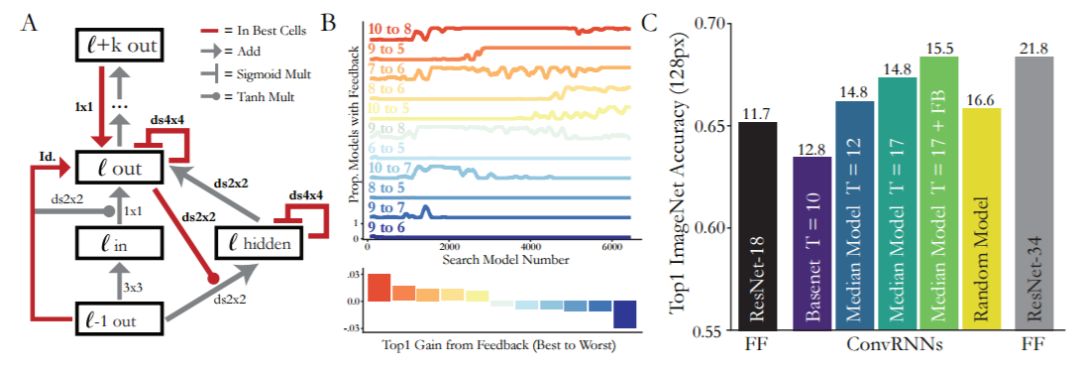

图 4:最优的局部循环单元和全局反馈连接。(a)搜索过程中表现最好的模型的 RNN 单元架构。红色的线表示每个最好的独特模型(3b 中的红线)所选择的超参数(连接和与滤波器大小)。K*K 表示卷积,dsK*K 表示卷积核大小为 K*K 的深度可分离卷积。(b)搜索中的远程反馈连接。(顶部)每条轨迹表示 100 个样本窗口中有特定反馈连接的模型的比例。(底部)每一个条表示具备给定反馈的模型与不具备该反馈的模型之间的性能中值差异。颜色与上面图中相同的反馈颜色一致。(c)在 128px 大小的 ImageNet 上完整训练的模型的性能。我们比较了 ResNet-18、18 层前馈基础模型(basenet)、搜索中有或没有全局反馈连接的中位模型,以及它的最小展开控制(T=12)的性能。「Random Model」是从模型搜索的初始随机阶段随机选取的。每个长条上方显示的是参数数量(单位:百万)。ResNet 模型的训练方法与 [He 等人,2016] 相同,但与 ConvRNN 相比,ResNet 是用 128px 大小的图像训练的。

图 5:用 ConvRNN 对灵长类动物腹侧流神经动态进行建模。(a)用于拟合神经动态的 ConvRNN 模型在 4 到 10 层具备局部循环单元和远程反馈(红色箭头)。(b)与大脑的腹侧层次一致,V4 的大多数单元都与第 6 层的特征最佳匹配;pIT 匹配第 7 层;cIT/aIT 匹配第 8/9 层。(c)与神经动态拟合的模型特征与这些响应的噪声上限很接近。y 轴表示在 held-out 图像上预测值和真实的响应值之间相关单元的中值。

论文:Task-Driven Convolutional Recurrent Models of the Visual System

论文地址:https://arxiv.org/pdf/1807.00053.pdf

摘要:前馈卷积神经网络(CNN)是针对像 ImageNet 这样的目标分类任务的当前最佳模型。此外,它们是灵长类动物大脑视觉系统中神经元平均时间响应的精准量化模型。但是生物的视觉系统有两个独一无二的、普通 CNN 没有的结构特征:皮质区域内的局部循环和从下游区域到上游区域的远程反馈。我们在此探索了循环在改善分类表现中所扮演的角色。我们发现深度 CNN 中标准形式的循环结构(标准 RNN 和 LSTM)在 ImageNet 任务中表现得不是很好。相比之下,包含两个架构特征(旁路和门控)的自定义单元能大大提高任务的准确率。我们将这些设计原理扩展到自动架构搜索中,即在数千个模型架构中识别有利于目标识别的新型局部循环单元和远程反馈连接。此外,基于任务优化的 ConvRNN 比前馈网络更好地解释了灵长类动物视觉系统中神经激活的动态,这说明在执行不同复杂视觉行为时大脑的循环连接扮演着重要角色。

- 加入AI学院学习 -

点击“ 阅读原文 ”进入学习