【AAAI2021】带有生成变换器(CGT)的对比学习三元组提取框架

编码器-解码器模型是功能强大的工具,已在许多NLP任务中获得成功,但是现有方法仍然存在两个关键问题。首先,由于递归神经网络(RNN)的固有缺陷,它们无法捕获长期依赖关系,从而导致重要信息的丢失,否则将在句子中反映出来,从而导致模型无法应用更长的文本。第二,缺乏工作致力于生成忠实的三元组,序列到序列的体系结构会产生不忠实的序列,从而产生意义上的矛盾。例如,给定句子“美国总统特朗普在纽约市皇后区长大,并居住在那里直到13岁”,该模型可以生成事实“(特朗普出生于皇后区)”。尽管从逻辑上讲是正确的,但我们无法从给定的句子中找到直接的证据来支持它。

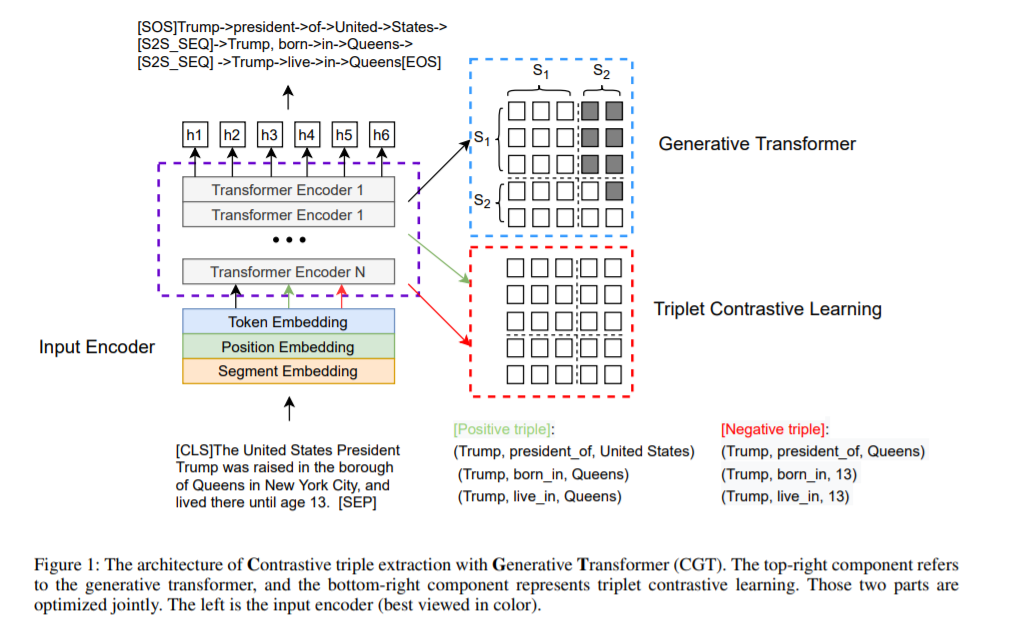

为了解决这些问题,我们引入了带有生成变换器(CGT)的对比学习三元组提取框架,该框架是一个共享的Transformer模块,支持编码器-解码器的生成式三元组对比学习多任务学习。首先,我们使用分隔符和部分因果掩码机制将输入序列与目标序列连接起来,以区分编码器-解码器表示形式。除了预先训练的模型之外,我们的模型不需要任何其他参数。然后,我们介绍了一种新颖的三元组对比学习对象,该对象利用真实的三元组作为正实例,并利用随机令牌采样将损坏的三元组构造为负实例。为了共同优化三元组生成对象和对比学习对象,我们引入了分批动态注意掩码机制,该机制允许我们动态选择不同的对象并共同优化任务。最后,我们介绍了一种新颖的三元组校准算法,以在推理阶段滤除虚假三元组。

https://www.zhuanzhi.ai/paper/93a9d99e5778d778ce940414dd97d2e7

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“CGT” 可以获取《【AAAI2021】带有生成变换器(CGT)的对比学习三元组提取框架》专知下载链接索引

登录查看更多

相关内容

Arxiv

13+阅读 · 2020年8月11日