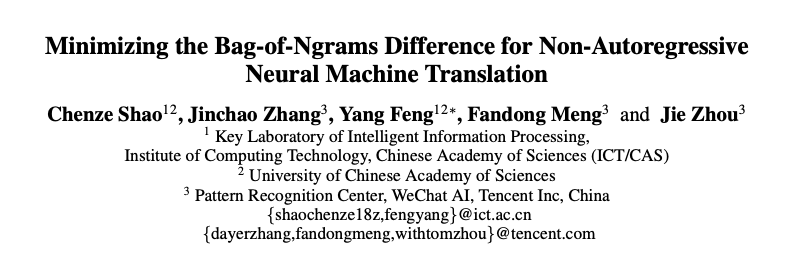

AAAI 2020 | 邵晨泽:非自回归机器翻译,基于n元组的训练目标(视频解读)

作者 | 邵晨泽

编辑 | Camel

本文是对计算所冯洋组和腾讯微信AI团队共同完成,被 AAAI2020 录用的论文《Minimizing the Bag-of-Ngrams Difference for Non-Autoregressive Neural Machine Translation》进行解读,相关工作已开源。

论文:https://arxiv.org/pdf/1911.09320.pdf

代码: https://github.com/ictnlp/BoN-NAT

论文简介:

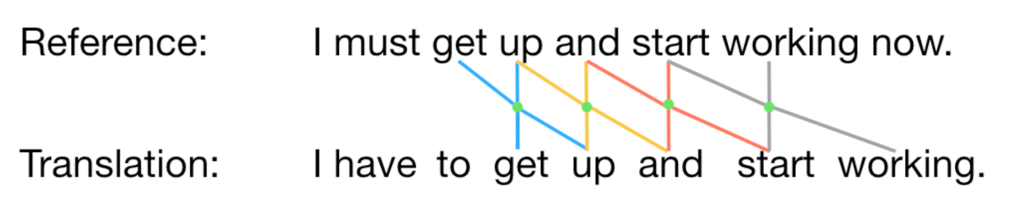

非自回归神经机器翻译模型(NAT)对目标词的生成进行独立的建模,从而显著地提升了翻译速度。然而,对非自回归模型来说,词级别的交叉熵损失函数不合理地要求模型输出与参考译文严格对齐,并且无法准确地建模目标端的序列依赖关系,从而导致其与模型翻译质量的相关性较弱。

在本文中,我们提出了基于模型与参考译文间n元组袋差异的训练目标,以该训练目标来训练非自回归模型。我们克服了指数级搜索空间和n元组袋维度巨大的困难,给出了计算n元组袋差异的高效算法,使这个基于n元组袋的训练目标具有可导、高效、易于实现的优点。我们在三个机器翻译数据集上进行了实验验证,结果表明,我们的方法在WMT14英语-德语数据集上取得了约5.0个BLEU值的大幅提升,在另外两个数据集上也有显著提升。

(或者到AI研习社官网观看更多AAAI 2020 论文解读视频:http://www.mooc.ai/open?from=meeting)

文字版解读:计算所&微信AI:改进训练目标,提升非自回归模型翻译质量(已开源)

关注「AI科技评论」微信公众号,后台回复「邵晨泽@AAAI2020」下载讲解 PPT。

作者简介:

邵晨泽,中国科学院计算技术研究所2018级直博生,研究方向为自然语言处理、机器翻译等,博士期间在自然语言处理顶级会议上发表多篇论文,两篇关于非自回归模型的工作分别发表于ACL2019、AAAI2020。

更多AAAI 2020信息,将在「AAAI 2020 交流群」中进行,加群方式:添加AI研习社顶会小助手(AIyanxishe2),备注「AAAI」,邀请入群。

AAAI 2020 论文解读系列:

13. [中科院自动化所] 通过解纠缠模型探测语义和语法的大脑表征机制

14. [中科院自动化所] 多模态基准指导的生成式多模态自动文摘

16. [UCSB 王威廉组] 零样本学习,来扩充知识图谱(视频解读)

18. [奥卢大学] 基于 NAS 的 GCN 网络设计(视频解读)

19. [中科大] 智能教育系统中的神经认知诊断,从数据中学习交互函数

30. [东北大学] 基于联合表示的神经机器翻译(视频解读)

31. [计算所] 引入评估模块,提升机器翻译流畅度和忠实度(视频解读)

32. [清华大学]用于少次关系学习的神经网络雪球机制(视频解读)