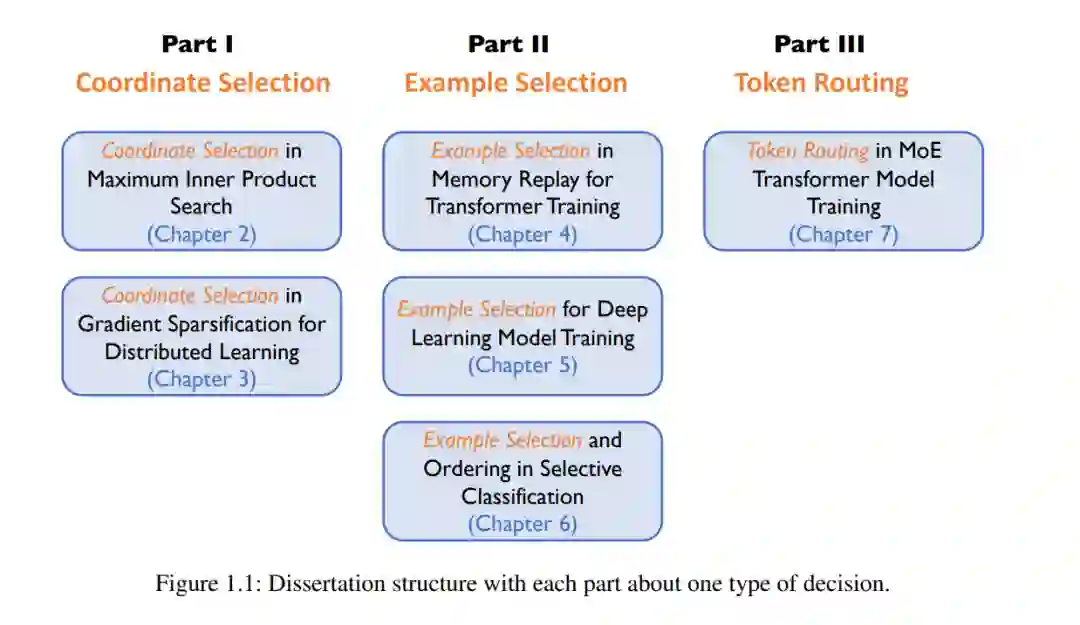

大规模机器学习是许多人工智能近期成功的核心,例如AlphaGo、BERT、DALL-E、GitHub Copilot、AlphaCode和ChatGPT。这些大规模模型无疑是强大的,但训练成本也非常高昂。为了降低成本,我们将顺序决策制定融入到机器学习模型的训练中。顺序决策制定长期以来一直是独立领域的关注焦点(例如,强化学习和多臂老虎机)。我们观察到顺序决策制定问题也出现在多种不同设置下的机器学习模型训练中。我们展示了通过精心解决这些问题可以提高训练效率,从而减少训练时间。根据具体的训练设置,决策内容涉及如何(a)选择向量的坐标,(b)从训练集中选择示例,或(c)在不同机器之间路由令牌。在这篇论文中,我们考虑了包括推荐系统、分布式学习、课程学习和变换器模型在内的多种训练设置。我们为每种训练设置设计了定制的决策制定策略,并通过大量实验展示了训练时间的缩短以及通常更高的准确性。

在过去几年中,机器学习模型变得越来越强大,在许多现实世界应用中取得了前所未有甚至超越人类的表现。例如,得益于机器学习的进步,AlphaGo成为了第一个在围棋游戏中击败世界冠军的电脑程序[210]。BERT在多个自然语言任务(如问答)中实现了超越人类的性能[53]。DALL-E是一个革命性的工具,能够基于文本提示生成多种风格的逼真图像[180]。GitHub Copilot依赖于Codex模型,为包括Python、JavaScript、PHP和Shell在内的十多种编程语言提供高质量的代码补全服务[32]。另一个代码生成系统AlphaCode,在具有挑战性的编程竞赛中,在5000多名参与者中的预估排名可达前54%[133]。最近,OpenAI发布了ChatGPT,这是一种可以以前所未有的方式与人类互动的聊天机器人,例如回答后续问题和承认错误[1]。

尽管这些激动人心的应用横跨游戏、编程语言生成、计算机视觉和自然语言理解等多个领域,但它们有一个共同点:都依赖于大规模机器学习模型。例如,AlphaCode使用的最大模型包含410亿个参数[133]。BERT在其早期版本中有3.4亿个参数[53],并通过使用新的混合专家(MoE)设计进一步扩展到3950亿参数[64]。DALL-E和GitHub Copilot的基础模型GPT-3包含1750亿个参数[25]。ChatGPT是基于GPT-3.5系列的模型进行微调的,其中包含高达1750亿个参数[1]。实际上,大规模机器学习模型一直是机器学习进步的基础,因为已经观察到,随着模型越来越大,其性能(例如,准确性)也越来越好。然而,更大的模型需要更多的数据和更长的训练时间,因此导致非常高的训练成本。例如,据估计,使用256个NVIDIA A100 GPU训练一个含1780亿参数的GPT-3模型需要168天[163]。据报道,训练AlphaCode模型需要数百个petaFLOPS天[133]。

本篇论文的目标是开发方法,以降低大规模机器学习算法的运行成本。具体而言,我们借鉴了顺序决策制定领域的技术。正如我们稍后将详细说明的那样,我们观察到在多种不同设置下的机器学习模型训练过程中出现了顺序决策制定。通过仔细解决这些顺序决策制定问题,我们的方法通过降低计算复杂性来改进训练程序,从而缩短了训练时间。

相关内容

密歇根大学是美国的一所顶尖公立院校,被誉为中西部的哈佛。密歇根大学的主校区在底特律的卫星城安娜堡,绰号是狼獾。它成立于1817年,被称为公立大学的典范,是公立常青藤之一。