教程网页:https://mllm2024.github.io/ACM-MM2024/

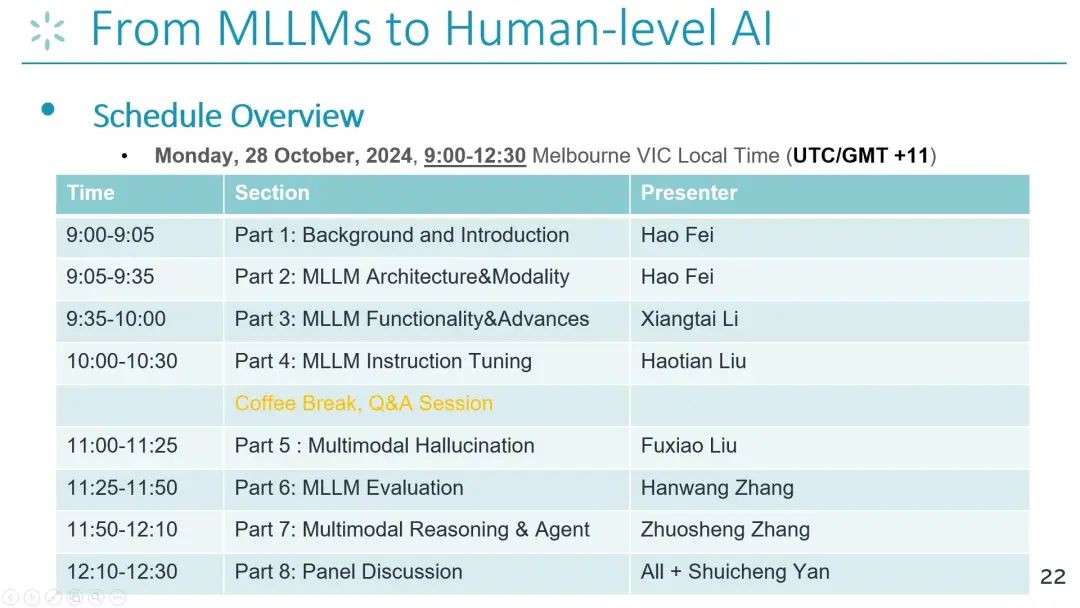

时间:墨尔本时间 2024年10月28日星期一,上午9点到中午12:30。对应北京时间 2024年10月28日星期一,上午6点到9:30

线下现场位置:Meeting Room 210, at Melbourne Convention and Exhibition Centre

线上参会Zoom:https://is.gd/Yv1hfr (ID: 857 2752 4712, Passcode: 951113)

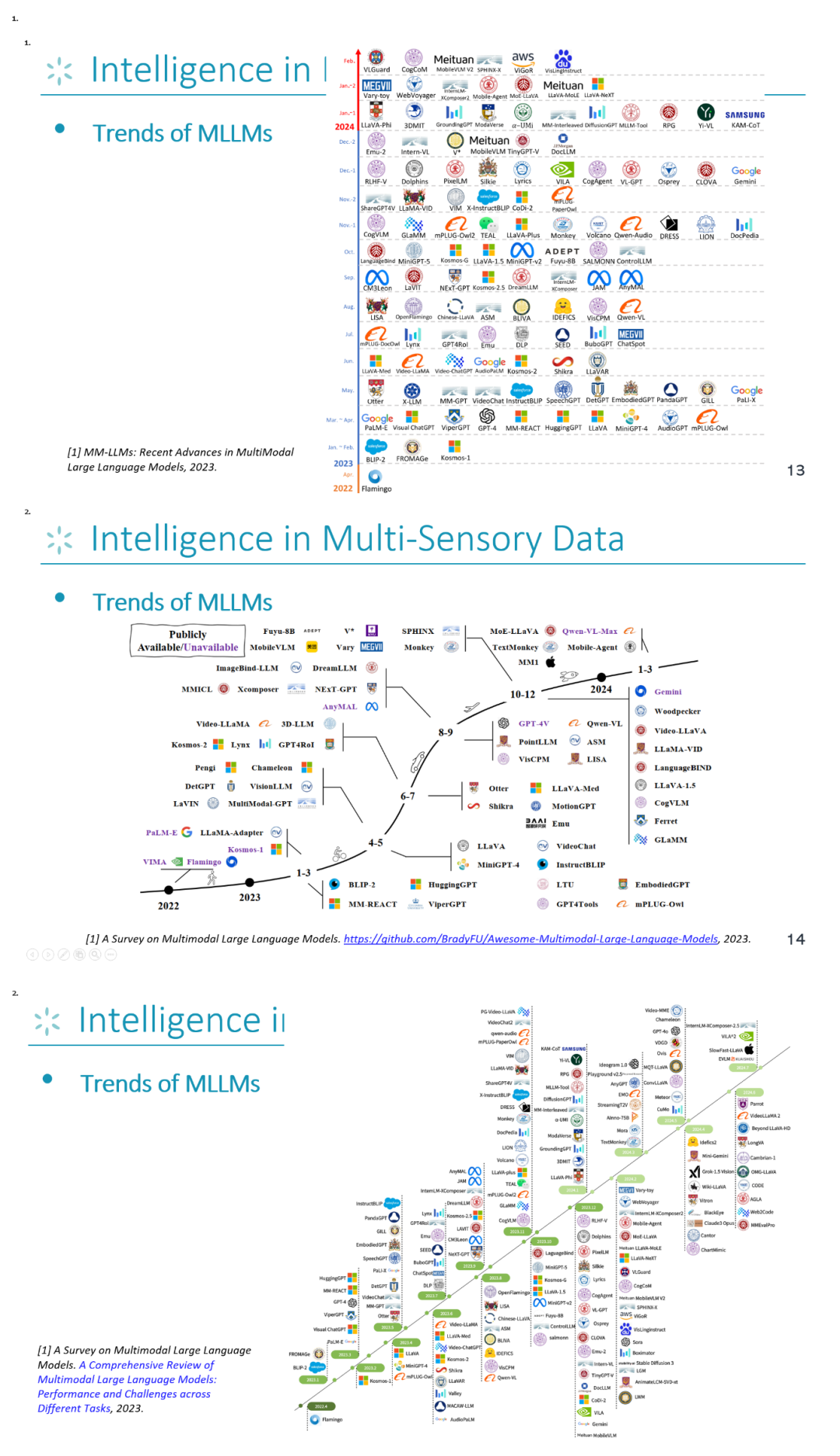

近年来,随着大语言模型(LLMs)的出现(如OpenAI的ChatGPT系列,Meta的LLAMA系列,以及Flan-T5、Vicuna和Alpaca等等),全世界目睹了人工智能(AI)前所未有的智能能力。这些LLMs在理解语言方面展示了卓越的能力,预示着实现真正的通用人工智能(AGI)的日期不远。但实际上,我们人类生活在一个包含视觉、听觉、感觉等多种信息模态共存的世界里。这赋予了研究LLMs多模态感知和理解能力的必要性,以更快更好地实现与人类类似水平的AI,即AGI。这催生了多模态大语言模型(MLLMs)研究话题和热点。MLLMs通过启用多感官学习,使多模态以及多任务能力相辅相成。研究人员在文本LLMs前后增设了额外的编码器和解码器以接收其他模态的输入甚至生成,推动了如BLIP-2、Flamingo、MiniGPT-4、LLaVA、Emu、NExT-GPT、Gemini、Qwen、Qwen-VL, GPT-4v, PixelLM, Mini-Gemini, InternLM-XComposer2, Vitron, Unified-IO 2等等一系列MLLMs的火热发展。通过相关的survey可以看到,从2023年到2024年,各种新颖的MLLMs喷涌而出,揭示了多模态大语言模型研究研发热潮以及其重要性。

本教程系列已经成功在COLING 2024 (https://mllm2024.github.io/COLING2024/)、CVPR 2024(https://mllm2024.github.io/CVPR2024/)成功举办过,并且受到了大量的关注。 本轮教程将会延续前面系列的成功,在ACM MM 2024(澳大利亚墨尔本)继续开展。我们将深入探讨MLLMs的最新进展,旨在面向各类相关研究群体,尤其是初学者们提供一个全面的、深入的MLLM的介绍,以帮助构建更强大、更高效、更接近人类智能水平的MLLMs和系统。

欢迎社区所有科研工作者参与教程(现场或者线上)。访问教程网页获取所有的教程slides、视频。 本教程团队来自于新加坡国立大学、字节跳动、xAI、马里兰大学、上海交大、南洋理工大学、上海人工智能实验室以及 Skywork AI的多名资深学者、教授等,其都在多模态学习、MLLM方向上具备丰富的研究经验,有诸如LLAVA、NExT-GPT、SPHINX、Meta-Transformer、ImageBind-LLM、MMIU、MMT-Bench、Multimodal CoT的作者。

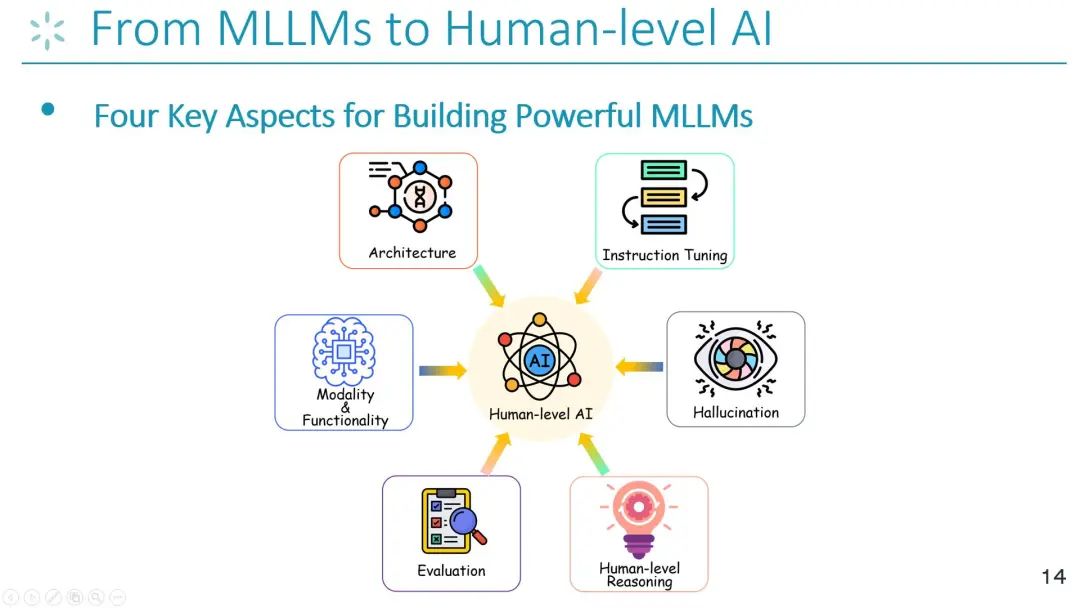

整个教程的内容将包括6个关键内容:

每位学者将会负责每一部分的教程讲解,最后所有学者将会组成一个penal,进行开放式的探讨,关于如何实现更加强大的面向AGI的多模态大模型:

时间安排表如下: