问题

核指挥与控制系统与人工智能(AI)的结合使其自主性不断提高,这将产生战略层面的影响,既可能增强核稳定性,也可能加剧使用核武器的风险。当前和不久的将来,机器学习(ML)系统固有的技术缺陷,再加上不断发展的人机心理关系,会使判断失误增加核风险,并可能导致无意或错误地使用核武器。本报告的一个重要启示是,这个问题并没有解决方案;相反,它代表了核决策背后的范式转变,要求改变推理、行为和系统,以确保能在不加剧核不稳定性的情况下收获自动化和机器学习的好处。

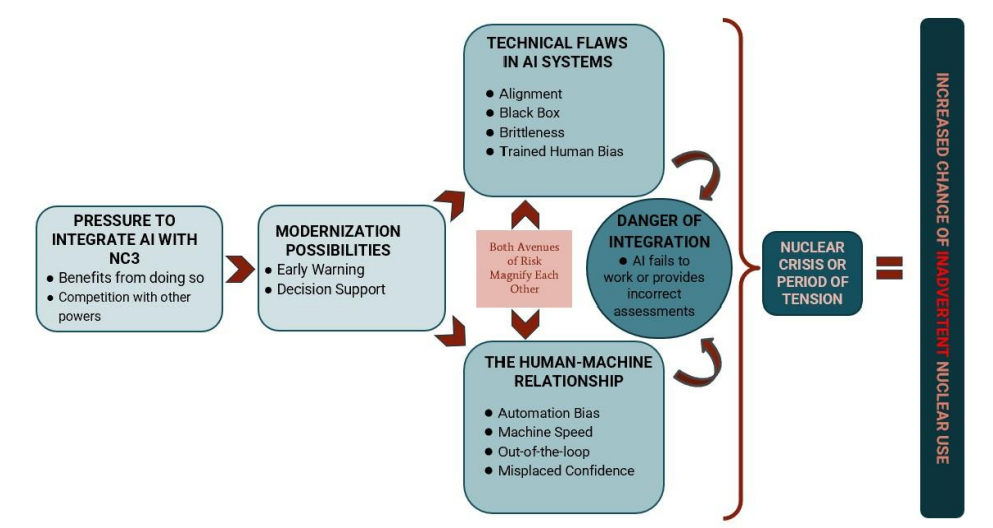

下图展示了从人工智能/机器学习系统与核指挥与控制的整合到增加核武器使用风险的一般路径。

处理好我们与机器的关系,特别是在军事领域,是保护人类生命不可或缺的一部分。当我们在已经充满争议的核领域考虑这一挑战时,我们的关注点从保护人类生命扩展到保护人类文明。毫无疑问,任何改变核武器使用决策的发展都需要我们密切关注。人工智能和 ML 将大大提高核指挥、控制和通信(NC3)的自动化程度。只有时间才能揭示这种发展的确切方式,但预警和决策支持系统似乎有可能实现高度自动化。

集成 ML 系统可以提高这些系统的准确性,同时还可能消除与人为相关的错误。然而,鉴于其在检测方面的重要性,以及其误报的历史,任何影响预警和决策支持系统的变化都需要经过严格的审查,即使这种变化有可能提高此类系统的安全性。

本报告旨在阐述问题,分析可能的解决方案,并介绍旨在支持有影响力的项目和发展的资助机会。然而,与学术论文更相似的是,本报告的主线强调了 ML 为 NC3 带来的自动化可能会对核决策产生重大影响。通过提高自动化程度,我们实际上是在将权力 "预先 "下放给机器智能系统,而尽管机器智能系统可以带来诸多优势,但它们却不可避免地存在缺陷。从某种意义上说,它们的不完美本身并不会破坏任何支持集成 ML 的论点。它们要么与人类操作员并肩作战,要么取代人类操作员,而人类操作员也是有缺陷的,其能力也是有限的。然而,当我们考虑自动化将如何影响人机关系时,依赖有缺陷的机器的真正危险就显而易见了。

开发人工智能的根本目的是为了让它在理论上比人类表现得更好--更快、更强,并持续保持警觉。然而,对自身能力的过度自信可能会导致过度部署技术和过早 "预先授权 "责任。这不仅为现代和近期的人工智能系统的技术缺陷埋下了伏笔,增加了灾难的风险,也使人类脱离了这一进程。虽然人类远非完美无缺,但在不到一个世纪的时间里,我们还是成功地避免了意外使用核武器和核战争。人类自身的弱点在防止意外使用核武器方面发挥了关键作用。因此,伴随着 ML 与 NC3 集成的自动化程度不断提高,核武器决策制定过程可能会发生巨大转变,这将加剧与无意中使用核武器有关的现有风险。

可能的干预

如果有兴趣减少因人工智能与 NC3 整合计划不周而产生的核风险,可以支持加强对这一主题的研究和讨论,和/或为这些概念和可能性提供更有力的实证支持。

可能的干预措施包括资助新的实验性兵棋推演工作、资助关键智库的研究工作以及加大国际人工智能治理力度。以下一些智库和研究团体可能是有影响力的候选者,但远非一份详尽的清单:

1.联合国裁军研究所 2.斯德哥尔摩国际和平研究所 3.兰德公司 4.战略与国际研究中心 5.核威胁倡议

目标受众

本报告旨在概述将人工智能/模拟语言与 NC3 结合可能对意外使用风险产生的影响。本报告的主要读者群也是对核威慑文献有一定了解,对危机的稳定性/不稳定性有一定认识的人。尽管如此,本报告还是深入探讨了其中一些与主要论点直接相关的话题。本报告不是对人工智能技术背后的计算机科学的深入研究,也不是旨在作为人机关系权威文献的心理学研究。

本报告旨在借鉴核威慑和人工智能安全两个领域的见解。通过综合这两个领域的文献,希望能让核资助者了解这种整合所涉及的风险,并为进一步的研究或其他努力提供方向,以缓解这一问题。

分析范围

这部著作的重点是美国和西方盟国:英国、法国和以色列。原因有三:

-

不同大国之间的制度各不相同,而在核大国中,本文最适合研究西方的核指挥权。

-

解决的问题与技术本身有关:技术如何可能影响人机关系并影响核决策。这些问题并不针对具体国家,因此本报告忽略其他核国家并不是一个重大缺陷。

-

可以说,降低核风险的合作努力是可取的,但单边行动也很重要,可以对核稳定产生积极影响。

在这种情况下,任何旨在减轻人工智能与核指挥整合的负面影响的努力,都有可能为所有参与者的安全带来净积极的结果。因此,我们可以将注意力主要集中在美国身上,并为降低核风险提供合理的建议。

还有一个危言耸听的问题。一些思想家正确地指出,关于新兴技术的讨论往往是一种危险的危言耸听。 从历史上看,化学武器等其他被预言会改变战争性质的技术都未能达到人们的期望。其他时候,"即使技术确实会产生重大的战略影响,它们也往往需要几十年的时间才能出现,飞机和坦克的发明就说明了这一点"。核武器的出现是一个明显的例外。自核武器问世以来,其无可否认的纯粹破坏力一直主导着国际安全和大国互动。虽然人工智能将如何影响整个世界以及具体到军事领域的细节尚不确定,但我们有理由担心,与其他被过度夸大的技术相比,人工智能将更类似于核武器。有人将人工智能比作电力;"就像电力给我们周围的物体带来动力一样,人工智能也将给它们带来智慧"。还有人说,这将是 "人类历史上最大的地缘政治革命"。战略性军事人工智能可能产生的巨大影响,以及针对这一问题的相对较少的慈善活动,凸显了概述潜在危险的必要性。

报告提纲

本报告首先界定了讨论人工智能和 NC3 的含义。其次,报告概述了将人工智能与 NC3 融合的压力、支持这一主张的证据以及如何实现现代化。第三,报告描绘了可能导致核使用风险增加的机制:人工智能系统中的技术缺陷和围绕人机关系的问题。第四,报告简要分析了应对这些风险的各种解决方案,并概述了哪些方案似乎最有可能对降低风险产生积极影响。第五,也是最后一点,报告提供了一份可行的筹资机会清单。