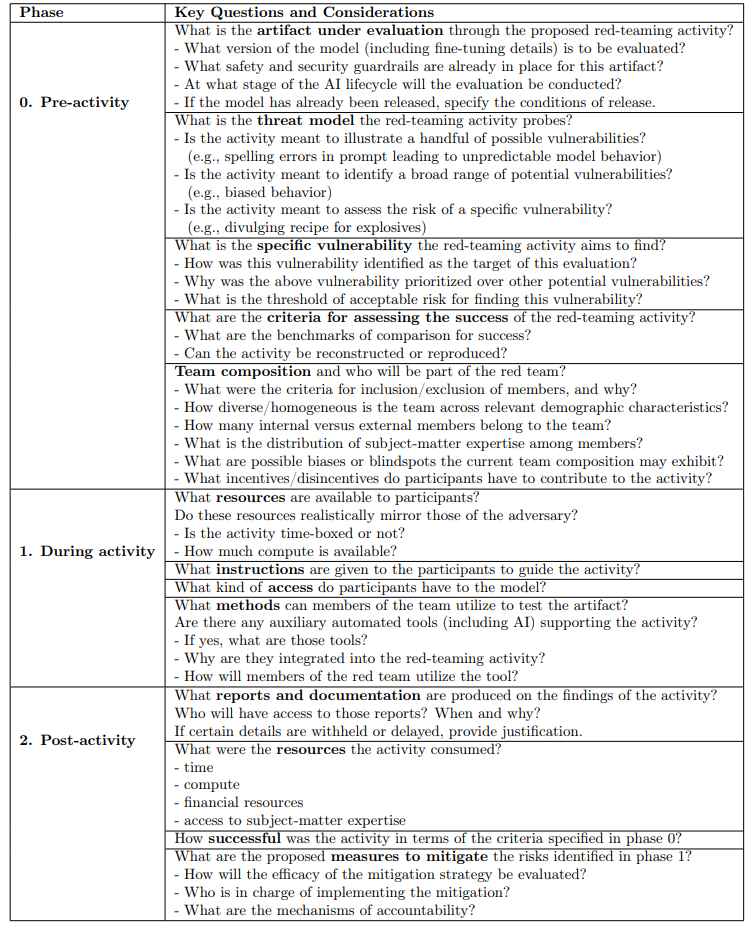

为了应对人们对生成式人工智能(GenAI)模型的安全性、保障性和可信性日益增长的担忧,从业者和监管者都将人工智能 "红队"(red-teaming)作为其识别和降低这些风险的战略的关键组成部分。然而,尽管人工智能红队在政策讨论和企业信息传递中扮演着核心角色,但对于它的确切含义、它在监管中能发挥什么作用,以及它与网络安全领域最初设想的传统红队实践之间的关系,仍然存在重大疑问。在这项工作中,我们确定了人工智能行业最近的 "红队"活动案例,并对相关研究文献进行了广泛调查,以确定人工智能 "红队"实践的范围、结构和标准。我们的分析表明,先前的人工智能 "红队"方法和实践在几个方面存在分歧,包括活动的目的(通常比较模糊)、被评估的人工智能产品、开展活动的环境(如参与者、资源和方法),以及由此产生的决策(如报告、披露和缓解)。根据我们的研究结果,我们认为,虽然 "红队 "可能是描述 GenAI 危害缓解措施的一个有价值的大帐篷想法,而且行业可能会闭门有效地应用 "红队 "和其他策略来保护人工智能,但将 "红队"(基于公开定义)作为解决所有可能风险的“万能药”的姿态近乎不可能。为了为生成式人工智能提供一个更强大的评估工具箱,我们将我们的建议综合成一个问题库,旨在指导和支持未来的人工智能 "红队"实践。

表 1:提出的用于指导未来人工智能红队活动的一系列问题。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日

Arxiv

152+阅读 · 2023年3月29日

Arxiv

85+阅读 · 2023年3月21日