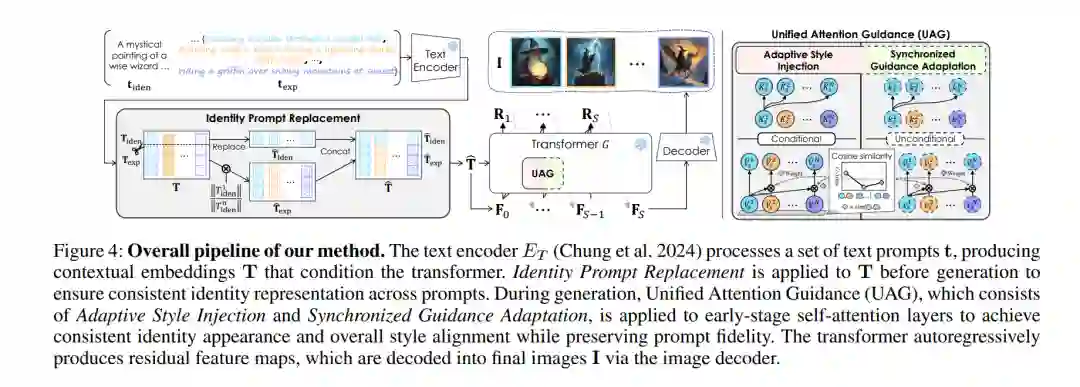

我们提出Infinite-Story,一个专为多提示词叙事场景设计的免训练连贯文本到图像生成框架。该方法基于按尺度自回归的生成模型,重点解决连贯文生图面临的两大核心挑战:身份不一致性与风格不一致性。为此,我们引入了三项互补技术:身份提示替换,通过减轻文本编码器中的上下文偏差来对齐多提示词间的身份属性;以及统一注意力引导机制,包含自适应风格注入与同步引导适配,二者协同工作以增强全局风格与身份外观的一致性,同时保持对各提示词语义的忠实度。与现有需要微调或推理速度缓慢的扩散模型方法不同,Infinite-Story完全在推理阶段运行,能够在多样化的提示词下实现高度的身份与风格一致性。大量实验表明,我们的方法在生成质量上达到了当前最优水平,同时相比现有最快的连贯文生图模型实现了超过6倍的推理加速(每张图像仅需1.72秒),充分凸显了其在现实视觉叙事应用中的高效性与实用性。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

87+阅读 · 2023年4月4日