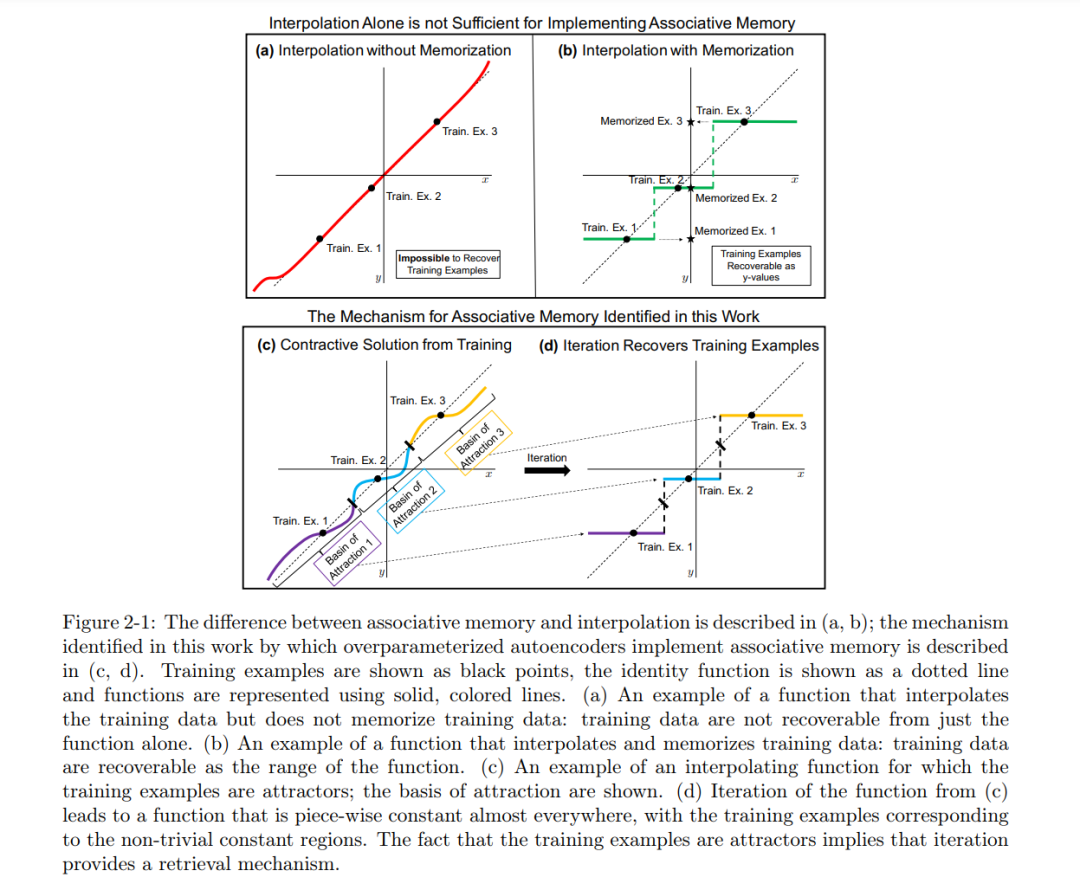

在这篇论文中,我们建立并分析了推动神经网络成功的两个核心原则:超参数化和特征学习。我们利用这些原则设计了在各种计算机视觉和生物医学应用上具有更好性能和解释性的模型。我们首先讨论超参数化的好处,即使用越来越大的网络完美地拟合训练数据。尽管之前的工作已经描述了超参数化网络在监督学习任务中的好处,但我们展示了超参数化对于非监督学习问题(如自动编码)也是有益的。越来越大的网络的普遍优势意味着无限大的网络应该提供最佳的性能。值得注意的是,在某些条件下,训练无限宽的网络简化为使用神经切线核(NTK)训练经典模型,也称为核机器。我们通过推导并使用NTK来展示其在矩阵补全问题(如图像修复和虚拟药物筛选)中的实际价值。此外,我们利用NTK连接为深度神经网络提供理论保证。具体地说,我们构建了插值的无限宽和深的网络,对于分类来说,它们是贝叶斯最优的或一致的。

尽管NTK已经成为理解深度网络属性的有用工具,但它缺少对神经网络成功至关重要的关键组件:特征学习。在这篇论文的第二部分,我们识别并数学地描述了深度神经网络如何自动选择数据中的特征或模式的机制。我们展示了神经特征学习是通过基于它们如何在扰动下改变预测来重新加权特征来发生的,这一过程在数学上由平均梯度外积来描述。我们的结果解释了如虚假特征、彩票票据和grokking等深度学习现象。此外,我们工作中确定的机制为任何机器学习模型提供了一个无需反向传播的特征学习方法。为了展示这种通用特征学习机制的有效性,我们使用它来实现核机器中的特征学习。我们展示了由此产生的模型,称为递归特征机,达到了表格数据上的最新性能。总体而言,这篇论文推进了机器学习的基础,并为构建新的机器学习模型提供了工具,这些模型在计算上简单、可解释且有效。

成为VIP会员查看完整内容

相关内容

麻省理工学院(Massachusetts Institute of Technology,MIT)是美国一所研究型私立大学,位于马萨诸塞州(麻省)的剑桥市。麻省理工学院的自然及工程科学在世界上享有极佳的盛誉,该校的工程系曾连续七届获得美国工科研究生课程冠军,其中以电子工程专业名气最响,紧跟其后的是机械工程。其管理学、经济学、哲学、政治学、语言学也同样优秀。

Arxiv

42+阅读 · 2023年4月19日

Arxiv

86+阅读 · 2023年4月4日

Arxiv

152+阅读 · 2023年3月29日