战争中的生死抉择不容轻视,无论是数百万人的生命,还是一个孩子的命运。战争法和交战规则为士兵在混乱的战斗中做出决定提供了框架,但在任何特定情况下,要做出正确的选择,往往需要正确的判断。

在人类与战争的关系中,技术已经把人类带到了一个关键的临界点。在未来的战争中,机器可能会独自做出生死攸关的交战决策。全球各国军队都在争先恐后地在海上、地面和空中部署机器人--九十多个国家都有无人机在空中巡逻。这些机器人的自主性越来越强,许多还配备了武器。目前,它们在人类的控制下运行,但当 “捕食者 ”无人机拥有和谷歌汽车一样的自主权时,会发生什么呢?我们应该赋予机器什么样的权力来决定最终的生死?

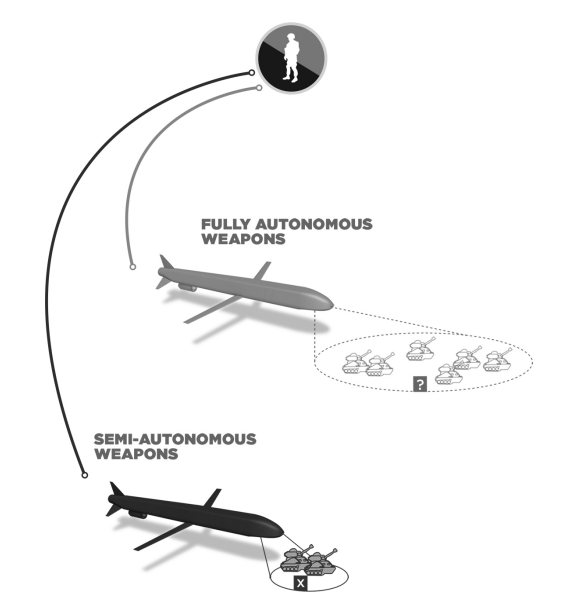

这不是科幻小说。目前已有三十多个国家拥有自主防御武器,以应对交战速度过快、人类无法做出反应的情况。这些系统用于防御火箭弹和导弹对舰船和基地的饱和攻击,由人类进行监督,必要时可以进行干预,但其他武器,如以色列的 “哈比 ”无人机,已经超越了完全自主的界限。与由人类控制的 “捕食者 ”无人机不同,“哈比 ”无人机可以在大范围内搜索敌方雷达,一旦发现敌方雷达,无需征得允许即可将其摧毁。该无人机已出售给少数几个国家,中国也对其进行了反向工程改造。更广泛的扩散是肯定可能的,“哈比 ”可能只是一个开始。韩国已经在与朝鲜接壤的非军事区部署了机器人哨兵枪。以色列使用武装地面机器人在加沙边境巡逻。俄罗斯正在建造一套武装地面机器人,用于在欧洲平原作战。目前已有 16 个国家拥有武装无人机,另有十几个国家正在公开研发。

这些发展是更深层次技术趋势的一部分:人工智能(AI)的崛起,有人称之为 “下一次工业革命”。技术大师凯文-凯利(Kevin Kelly)将人工智能比作电力:就像电力给我们周围的物体带来动力一样,人工智能也将给它们带来智能。从仓库机器人到下一代无人机,人工智能可以让机器人变得更加复杂和自主,还可以帮助处理大量数据并做出决策,为推特机器人提供动力,编制地铁维修时间表,甚至做出医疗诊断。在战争中,人工智能系统可以帮助人类做出决策,也可以授权人类自己做出决策。

人工智能的崛起将改变战争。二十世纪初,各国军队利用工业革命将坦克、飞机和机枪带入战争,造成了前所未有的破坏。机械化使人们能够制造出在体力上比人类更强、更快的机器,至少在某些任务上是如此。同样,人工智能革命正在实现机器的认知化,创造出在完成某些任务时比人类更聪明、更快速的机器。人工智能在军事上的许多应用是没有争议的--如改进后勤、网络防御以及用于医疗后送、补给或监视的机器人--然而,将人工智能引入武器领域却提出了具有挑战性的问题。如今,自动化已被用于武器的各种功能,但在大多数情况下,仍然是人类在选择目标和扣动扳机。这种情况是否会继续下去还不清楚。大多数国家对自己的计划保持沉默,但也有少数国家表示打算全速推进自主化。俄罗斯高级军事指挥官预计,在不久的将来,“将建立一支完全机器人化的部队,能够独立开展军事行动”,而美国国防部官员则表示,部署完全自主武器的选择应该 “摆在桌面上”。

由武装机器人决定杀戮对象听起来像是一场乌托邦噩梦,但有些人认为,自主武器可以让战争变得更加人道。让自动驾驶汽车避开行人的自动化技术也可以用来避免战争中的平民伤亡,而且与人类士兵不同,机器永远不会生气或寻求报复。它们永远不会疲劳或疲倦。飞机自动驾驶大大提高了商用客机的安全性,挽救了无数生命。自动驾驶能否为战争带来同样的效果?

新型人工智能(如深度学习神经网络)在视觉物体识别、面部识别和感知人类情绪方面取得了惊人的进步。不难想象,未来的武器在分辨手持步枪的人和手持耙子的人方面可以胜过人类。然而,计算机在理解上下文和诠释含义方面仍与人类相差甚远。如今的人工智能程序可以识别图像中的物体,但无法将这些单独的线索串联起来理解全局。

战争中的一些决策是简单明了的。有时敌人很容易识别,射击也很明确。但有些决策,比如斯坦尼斯拉夫-彼得罗夫面临的决策,需要了解更广泛的背景。有些情况,比如我的狙击小组遇到的情况,需要进行道德判断。有时,做正确的事需要打破常规--合法和正确并不总是一致的。

本书将探索下一代机器人武器的快速发展之旅。走进制造智能导弹的防务公司和从事蜂群技术前沿研究的研究实验室。还将介绍制定政策的政府官员和争取禁止机器人武器的活动家。本书将回顾过去--包括曾经出错的地方--展望未来,将会见推动人工智能发展的研究人员。

本书将探讨未来自主武器的发展前景。自动股票交易导致了华尔街的 “闪电崩盘”。自动武器会导致 “闪电战 ”吗?深度学习等新的人工智能方法功能强大,但往往导致系统实际上成为一个 “黑盒子”--甚至对其设计者来说也是如此。先进的人工智能系统会带来哪些新挑战?

3000 多名机器人和人工智能专家呼吁禁止攻击性自主武器,60 多个非政府组织也加入了 “制止杀手机器人运动”。斯蒂芬-霍金(Stephen Hawking)、埃隆-马斯克(Elon Musk)和苹果公司联合创始人史蒂夫-沃兹尼亚克(Steve Wozniak)等科技界名人都公开反对自主武器,并警告它们可能引发 “全球人工智能军备竞赛”。

军备竞赛可以避免吗?如果已经发生,能否阻止?人类在控制危险技术方面的记录好坏参半;早在古代就有人试图禁止那些被视为过于危险或不人道的武器。其中许多尝试都以失败告终,包括二十世纪初试图禁止潜艇和飞机的尝试。即使是那些成功的尝试,如禁止化学武器,也很少能阻止巴沙尔-阿萨德的叙利亚或萨达姆-侯赛因的伊拉克等流氓政权。如果国际禁令无法阻止世界上最可恶的政权建立杀手机器人陆军,那么我们有一天可能会面对最黑暗的噩梦变成现实。