近年来,人工智能(AI)系统有了长足的进步,其功能也在不断扩展。特别是被称为 "生成式模型 "的人工智能系统在自动内容创建方面取得了巨大进步,例如根据文本提示生成图像。其中一个发展尤为迅速的领域是能够生成原始语言的生成模型,这可能会给法律和医疗保健等多个领域带来益处。

不过,生成式语言模型(简称 "语言模型")也可能存在负面应用。对于希望传播宣传信息--旨在塑造观念以促进行为者利益的恶意行为者来说,这些语言模型带来了自动创建有说服力和误导性文本以用于影响力行动的希望,而不必依赖人力。对社会而言,这些发展带来了一系列新的担忧:那些试图暗中影响公众舆论的人可能会开展高度可扩展、甚至极具说服力的活动。

本报告旨在评估:语言模型的变化会如何塑造影响力行动,以及可以采取哪些措施来减轻这些威胁?由于人工智能和影响力行动都在迅速变化,这项任务本质上是推测性的。

作者于 2021 年 10 月召集了 30 位人工智能、影响力行动和政策分析领域的专家,讨论语言模型对影响力行动的潜在影响,该研讨会为报告中的许多观点提供了参考。由此产生的报告并不代表研讨会与会者的共识。

希望这份报告对那些对新兴技术的影响感兴趣的虚假信息研究人员、制定政策和投资的人工智能开发人员以及准备应对技术与社会交叉领域的社会挑战的政策制定者有所帮助。

语言模型在影响力行动方面的潜在应用

分析了生成式语言模型对影响力行动三个众所周知的方面——发起行动的行为体、作为战术的欺骗行为以及内容本身——的潜在影响,并得出结论:语言模型可能会极大地影响未来影响力行动的发起方式。表 1 总结了这些变化。

语言模型有可能以较低的成本与人类撰写的内容相媲美,这表明这些模型与任何强大的技术一样,可以为选择使用它们的宣传者提供独特的优势。这些优势可以扩大与更多行为者的接触,实现新的影响策略,并使竞选活动的信息传递更有针对性和潜在的有效性。

表 1:语言模型如何塑造影响力行动

1、行为体

由于生成AI文本的潜在变化

- 涌现出更多和更多样化的行为体。

- 外包公司变得更加重要。

对变化的解释

- 随着生成式模型降低宣传成本,更多行为体可能会发现开展影响力行动的吸引力。

- 自动生成文本的雇佣宣传者可能会获得新的竞争优势。

2、行为

由于生成AI文本的潜在变化

- 内容制作自动化可扩大宣传活动的规模。

- 现有行为变得更有效率。

- 新策略层出不穷

对变化的解释

- 文本自动生成后,宣传活动将更容易扩大规模。

- 有了语言模型,跨平台测试等昂贵的策略可能会变得更便宜

- 语言模型可实现动态、个性化和实时内容生成,如一对一聊天机器人。

3、内容

由于生成AI文本的潜在变化

- 信息更可信、更有说服力。

- 宣传不易被发现。

对变化的解释

- 与缺乏目标语言或文化知识的宣传人员撰写的文本相比,生成式模型可以改进信息传递。

- 现有的宣传活动经常因使用复制粘贴文本(copypasta)而被发现,但语言模型可以制作出语言独特的信息。

影响力行动的进展和关键未知因素

语言模型的技术进步不可能停止,因此任何试图了解语言模型将如何影响未来影响行动的尝试都需要考虑到预期的进步。语言模型可能会变得更加可用(使模型更容易应用于任务)、可靠(减少模型产生明显错误输出的机会)和高效(提高应用语言模型进行影响行动的成本效益)。

这些因素促使我们做出高度自信的判断,即语言模型在未来的影响力行动中将大有用武之地。然而,其应用的确切性质尚不明确。

有几个关键的未知因素将塑造影响力行动如何以及在多大程度上采用语言模型。这些未知因素包括:

-

哪些新的影响力能力将作为善意研究的副作用而出现?传统的研究过程以更广泛的语言任务为目标,其结果是产生了可应用于影响力行动的系统。未来可能会出现新的能力,如制作长篇有说服力的论据。这些新出现的能力很难通过生成模型来预测,但可以决定宣传人员将使用语言模型来执行哪些具体任务。

-

为影响力行动设计特定的语言模型是否比应用通用模型更有效?虽然目前大多数模型都是为通用任务或具有科学或商业价值的任务而建立的,但宣传人员可以建立或调整模型,使其直接用于说服和社会工程等任务。例如,宣传人员可以对一个较小、能力较弱的模型进行调整,这一过程被称为微调。这很可能比建立一个更大、更通用的模型更便宜,尽管还不能确定会便宜多少。此外,对最先进的模型进行微调可以使宣传者更容易获得新的影响能力。

-

随着时间的推移,参与者是否会对语言模型进行大量投资?如果许多参与者都投资并创建了大型语言模型,这将增加宣传者获取语言模型(合法或通过盗窃)的可能性。宣传者本身也可以投资创建或微调语言模型,纳入定制数据--如用户参与数据--以优化其目标。

-

政府或特定行业是否会制定禁止将模型用于宣传目的的规范?正如使用规范会限制其他技术的滥用一样,它们也可能会限制语言模型在影响力行动中的应用。一个同意不将语言模型用于宣传目的的国家联盟可以让那些不遵守的国家付出代价。在次国家层面,研究团体和特定行业可以制定自己的规范。

-

何时才能公开提供易于使用的文本生成工具?语言模型的熟练使用仍然需要操作知识和基础设施。易于使用的工具可以生成推文或段落长度的文本,这可能会让缺乏机器学习知识的现有宣传人员依赖语言模型。

由于这些关键的可能性可能会改变语言模型对影响力行动的影响,因此为减少不确定性而开展更多研究是非常有价值的。

如何减轻潜在威胁?

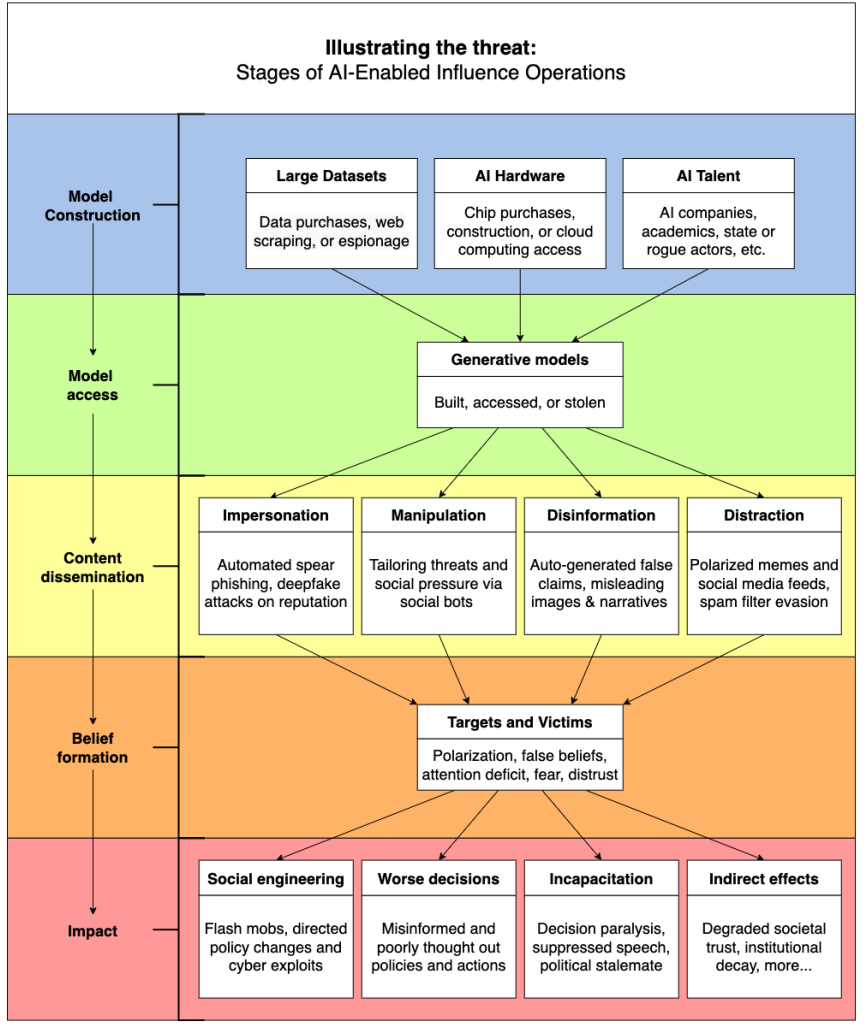

在2021 年 10 月召开的研讨会的基础上,对现有的大量文献进行了调查、 试图为各种可能的缓解战略提供一个杀伤链框架,并对其类型进行调查。目的不是认可具体的缓解策略,而是展示缓解策略如何针对影响力行动流水线的不同阶段。

表 2:缓解措施实例摘要

宣传者的要求

1.能够生成真实文本的语言模型

2.可靠地获取此类模型

3.分发生成内容的基础设施

4.易受影响的目标受众

干预阶段

1.模型设计与制作

2.模型接入

3.内容传播

4.信念形成

说明性的缓解措施

1.1 人工智能开发人员建立对事实更敏感的模型

1.2 开发人员传播扩散性数据,使生成模型可被检测到

1.3 对数据收集施加限制

1.4 对人工智能硬件实施访问控制

2.1 人工智能供应商对语言模型实施更严格的使用限制

2.2 人工智能开发者围绕模型发布制定新规范

3.1 平台和人工智能供应商协调识别人工智能内容

3.2 平台要求发布"个人身份证明"

3.3 依赖公众意见的实体采取措施减少误导性人工智能内容的风险

3.4 数字出处标准得到广泛采用

4.1 机构参与媒体扫盲运动

4.2 开发人员提供以消费者为中心的人工智能工具

上表表明,没有什么灵丹妙药能彻底消除影响力行动中语言模型的威胁。一些缓解措施可能在社会上不可行,而另一些则需要技术突破。还有一些可能会带来不可接受的负面风险。相反,要有效减轻威胁,很可能需要一种结合多种缓解措施的全社会方法。

此外,有效的管理还需要不同机构之间的合作,如人工智能开发者、社交媒体公司和政府机构。只有这些机构通力合作,许多建议的缓解措施才能产生有意义的影响。除非社交媒体公司能与人工智能开发人员合作,将文本归属于某个模型,否则他们很难知道某个虚假信息活动是否使用了语言模型。最激进的缓解措施--比如在互联网协议中加入内容出处标准--需要极度的协调,如果它们是可取的话。

也许最重要的是,强调的缓解措施需要更多的开发、审查和研究。对其有效性和稳健性的评估值得认真分析。

图 4:人工智能赋能的影响力行动的干预阶段。为了阻止宣传者利用语言模型实施影响力行动,可针对以下四个阶段采取缓解措施:(1) 模型设计与构建;(2) 模型获取;(3) 内容传播;(4) 信念形成。最终,在这些阶段进行干预可减轻影响行动的直接和间接影响。