人工智能分布式部署的代理系统日益普及,对高效选择影响智能体学习行为的参数、复杂环境下的机制设计应用以及整合多样化智能体能力达成预期目标提出了新挑战。算法机制设计(这一融合计算机科学、数学与经济学的跨学科领域)致力于开发引导理性智能体实现期望行为的算法,其应用涵盖资源分配、成本分摊、定价与组合拍卖。然而,传统方法受限于计算约束与静态假设,在动态不确定环境中的有效性不足。本论文通过整合强化学习(RL)与贝叶斯优化(BO)开发动态多智能体环境中的自适应机制以突破上述局限。

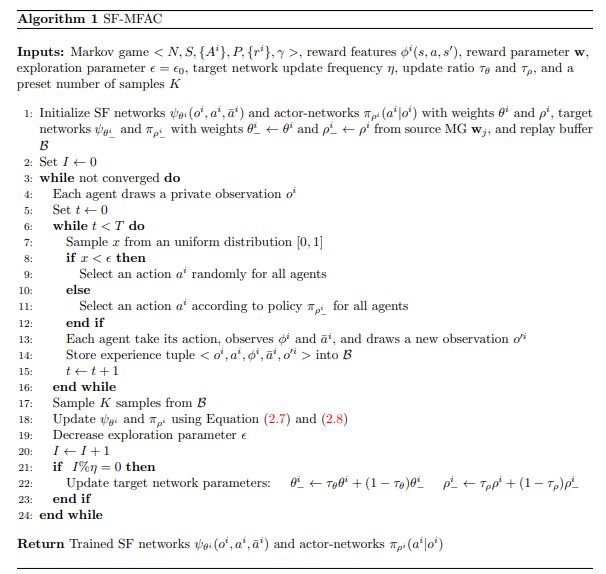

本文提出多智能体强化学习(MARL)中机制设计的新框架,依托新型BO方法高效探索潜力方案。MARL捕捉随机环境中多智能体动态交互的复杂性,通过求解底层马尔可夫博弈学习联合策略。评估多MARL场景的计算复杂度问题通过以下方式解决:(一)扩展"后继特征"至纳什均衡策略的迁移学习;(二)采用基于BO的框架限制评估资源,使问题可解。所提机制设计框架的有效性通过多项实际应用基准研究验证,包括:出租车平台司机服务费设定、共享自然资源开发管理(实现社会福利最大化)、机器人编队勘探任务硬件采购决策优化,以及定义最优激励与招募策略(最大化委托方目标)。实证结果表明,本方法在现实问题中优于现有技术,彰显BO与MARL结合优化复杂多智能体系统的潜力,为机制设计未来研究奠定坚实基础。

成为VIP会员查看完整内容

相关内容

Arxiv

38+阅读 · 2023年4月19日

Arxiv

205+阅读 · 2023年4月7日

Arxiv

141+阅读 · 2023年3月29日