强化学习(RL)是一种框架,在这种框架中,智能体通过与环境的交互,以行动奖励或惩罚的形式获得数据驱动的反馈,从而学会做出决策。深度 RL 将深度学习与 RL 相结合,利用深度神经网络的强大功能来处理复杂的高维数据。利用深度 RL 框架,我们的机器学习研究界在使机器能够在长时间范围内做出连续决策方面取得了巨大进步。这些进步包括在雅达利(Atari)游戏中实现超人性能[Mnih 等人,2015],掌握围棋游戏,击败人类世界冠军[Silver 等人,2017],提供强大的推荐系统[GomezUribe 和 Hunt,2015, Singh 等人,2021]。本论文的重点是找出一些阻碍 RL 智能体在其特定环境中学习的关键挑战,并改进方法,从而提高智能体的性能、改善样本效率以及学习到的智能体策略的普适性。

在论文的第一部分,我们将重点放在单智能体 RL 设置中的探索上,在单智能体 RL 设置中,智能体必须与复杂的环境交互以追求目标。不探索环境的智能体不可能获得高性能,因为它会错过关键奖励,因此无法学习到最佳行为。一个关键的挑战来自于奖励稀少的环境,在这种环境中,智能体只有在任务完成后才会收到反馈,这使得探索更具挑战性。我们提出了一种能进行语义探索的新方法,从而提高了样本效率和稀疏奖励任务的性能。

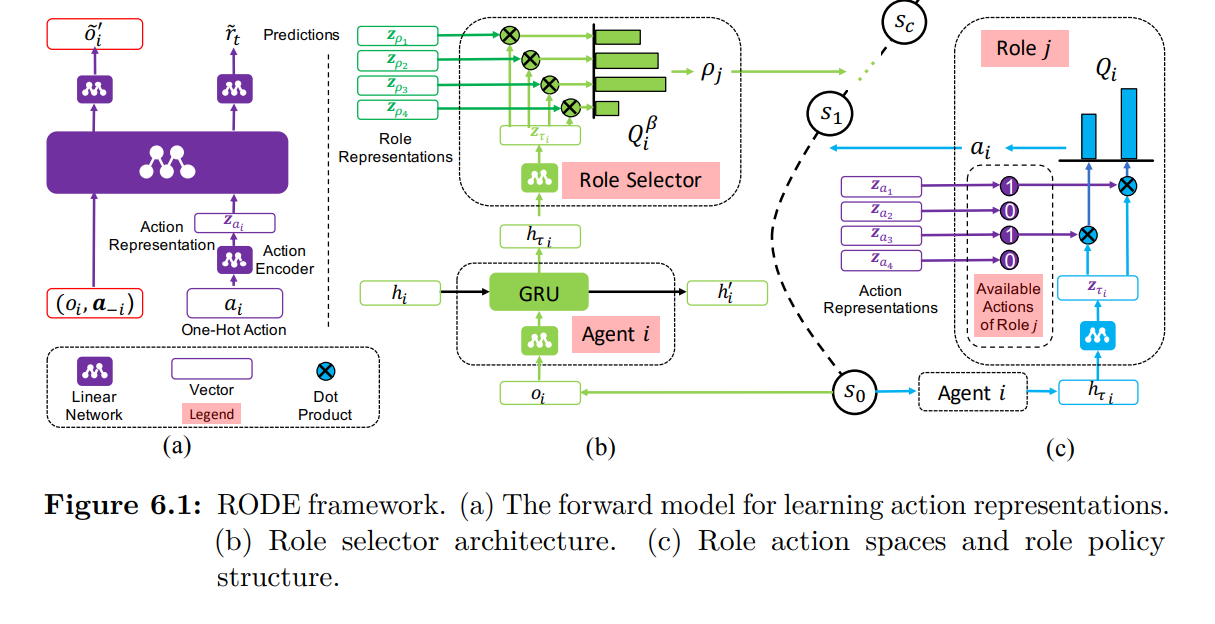

在论文的第二部分,我们将重点放在合作式多智能体强化学习(MARL)上,这是对通常的 RL 设置的扩展,我们考虑多个智能体在同一环境中为共同的任务进行交互。在多智能体任务中,各智能体之间需要进行大量协调,并对协调失误进行严格惩罚,而最先进的 MARL 方法往往无法学习到有用的行为,因为各智能体会陷入次优平衡状态。另一个挑战是在所有智能体的联合行动空间中进行探索,而这一空间会随着智能体数量的增加而呈指数级增长。为了应对这些挑战,我们提出了通用价值探索和可扩展的基于角色的学习等创新方法。这些方法有助于改善智能体之间的协调,加快探索速度,并增强智能体适应新环境和新任务的能力,展示零镜头泛化能力,从而提高样本效率。最后,我们研究了合作式 MARL 中基于独立策略的方法,其中每个智能体都将其他智能体视为环境的一部分。我们表明,在一个流行的多智能体基准上,这种方法的表现优于最先进的联合学习方法。

总之,本论文的贡献大大提高了深度(多智能体)强化学习的最新水平。本论文中开发的智能体可以高效地探索其环境以提高采样效率,学习需要大量多智能体协调的任务,并在各种任务中实现零点泛化。