自然语言生成(NLG)在许多应用中发挥着至关重要的作用。评估生成文本的质量对于确保NLG系统的有效性和用户满意度至关重要。随着近年来深度学习的普及,许多模型被报告在流行的基准测试中达到了超越人类的性能。然而,人们观察到,现有的整体基准和评估指标经常未能准确评估该领域感兴趣的特定评估因素。 本论文探索了一个诊断性评估框架,用于评估NLG任务中生成文本的语法性、忠实度和多样性(GFD)。这三个指标被视为基本的语言质量,NLG模型的输出中需要具备这些质量。通过分析句子与明确定义的形式语法的解析性来检查语法性。忠实度被分为两个方面:基于事实的忠实度和任务的忠实度。这两个方面调查模型输出与输入中提供的信息以及任务的固有要求的对齐程度。多样性进一步细分为词级和解析级多样性测量。在提出的GFD框架中,评估这三个指标不需要构建特定于任务的参考资料。

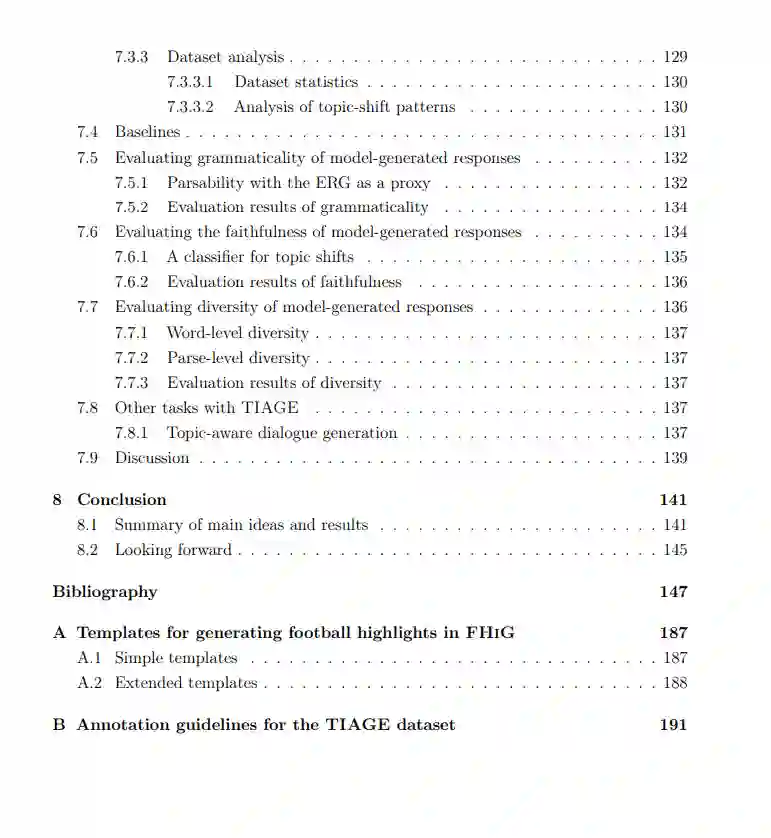

通过清晰定义和评估这些生成质量,该框架旨在提供对NLG模型的优势和限制的见解。为了展示GFD评估框架的多功能性,探索了三种不同的生成任务:合成图像标题生成、足球精彩片段生成自比赛统计数据和话题转换对话生成。这些任务被故意选择来涵盖生成场景的广泛范围。每个任务提供独特的基础信息和约束,影响生成过程,进而为评估NLG模型创造多样的挑战。对这些任务的实验揭示了在真实表达减少或者在输入基础与任务约束之间存在微妙平衡时,进行细粒度NLG评估的挑战。本论文通过实验证明了GFD评估框架结合诊断数据集如何能够提供模型优势和限制的见解以补充标准评估。

https://www.repository.cam.ac.uk/items/1718b380-029b-42a3-891d-da52016323c2

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日