本书旨在向读者介绍深度学习算法这一主题。简而言之,当我们谈论深度学习算法时,我们指的是一种计算方案,其目的是通过所谓的深度人工神经网络(ANNs)和某种数据的反复使用来近似某些关系、函数或量。而ANNs可以被看作是由多个非线性函数的组合构成的函数类,这些非线性函数被称为激活函数,以及某些仿射函数。宽泛地说,这种ANNs的深度对应于ANN中涉及的迭代组合的数量,当非线性和仿射函数的组合数量超过两个时,就开始谈论深度ANNs。

我们希望这本书对那些还没有深度学习背景的学生和科学家有用,帮助他们获得坚实的基础,也对希望在深度学习的对象和方法上获得更坚实数学理解的从业者有所帮助。

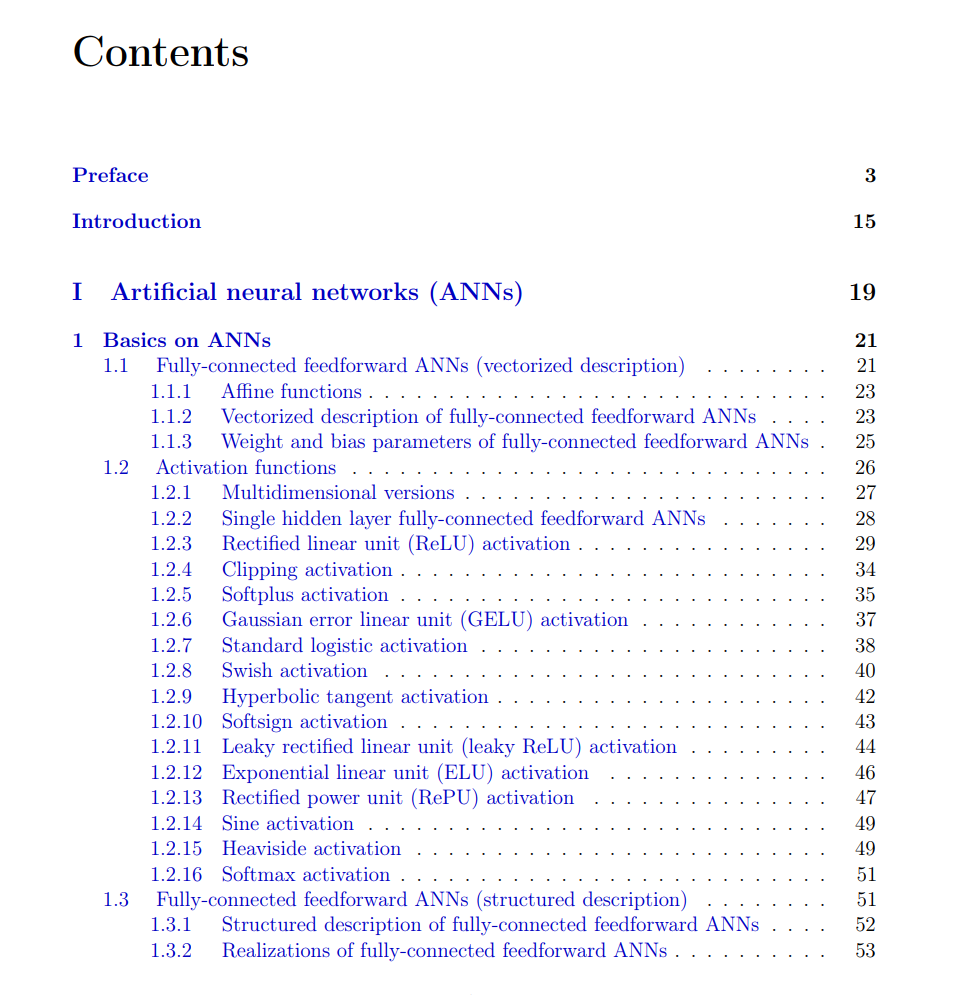

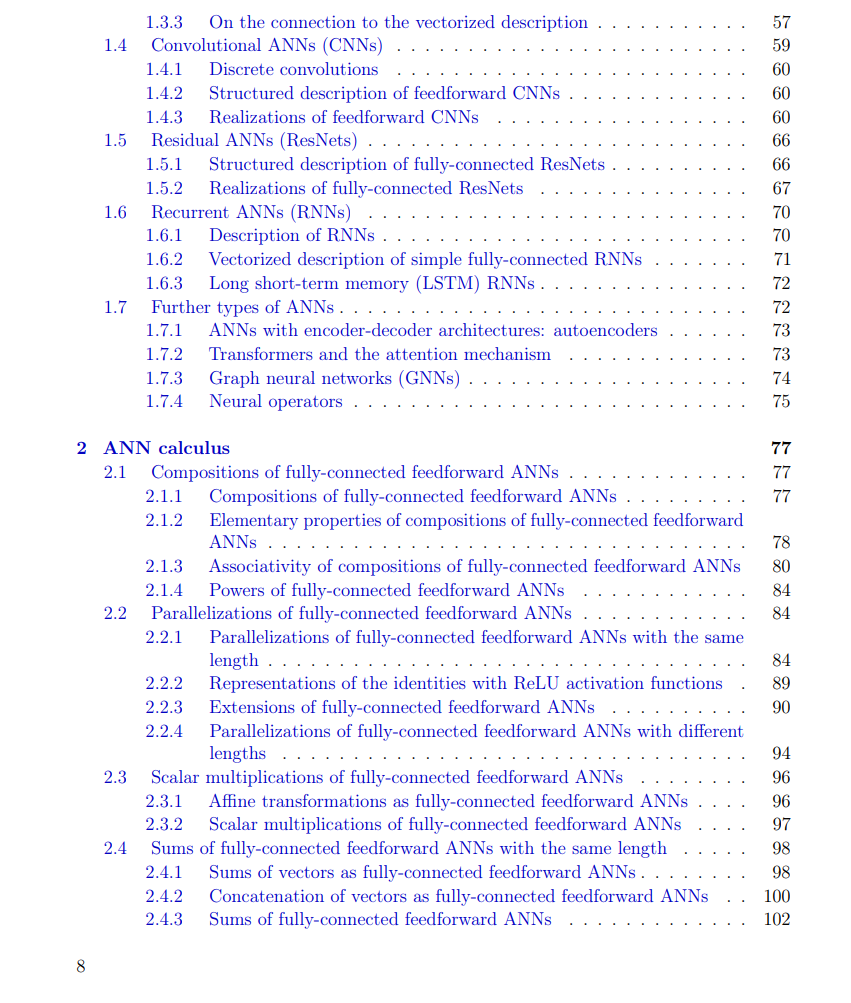

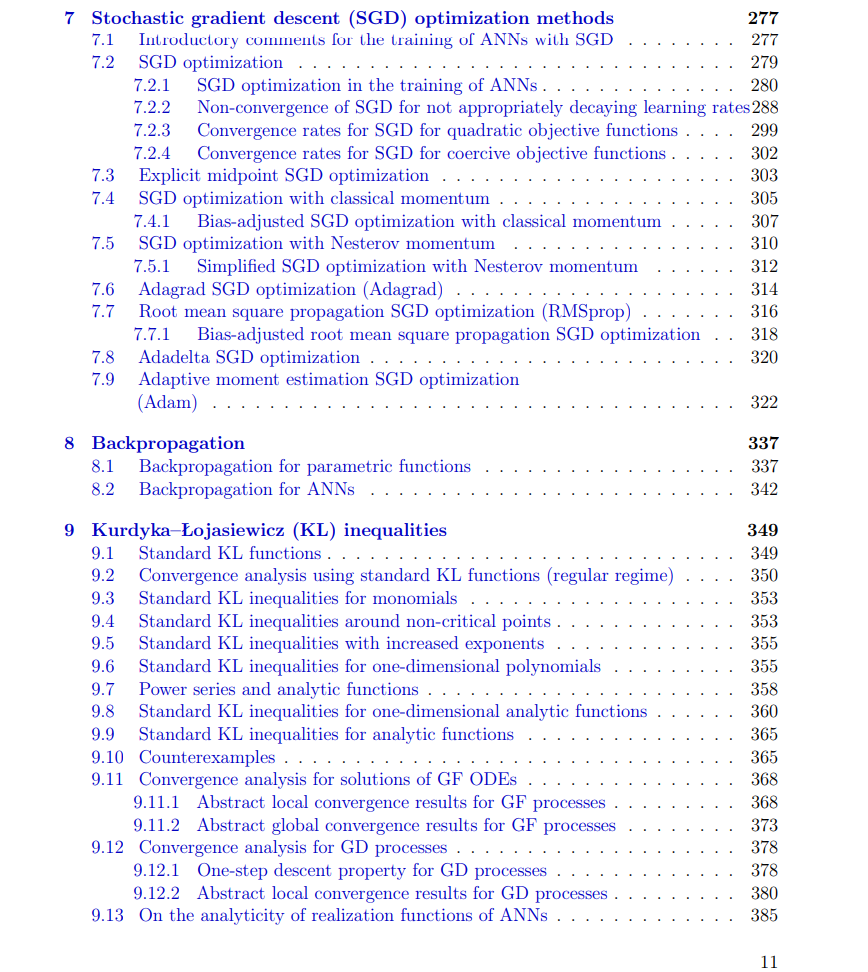

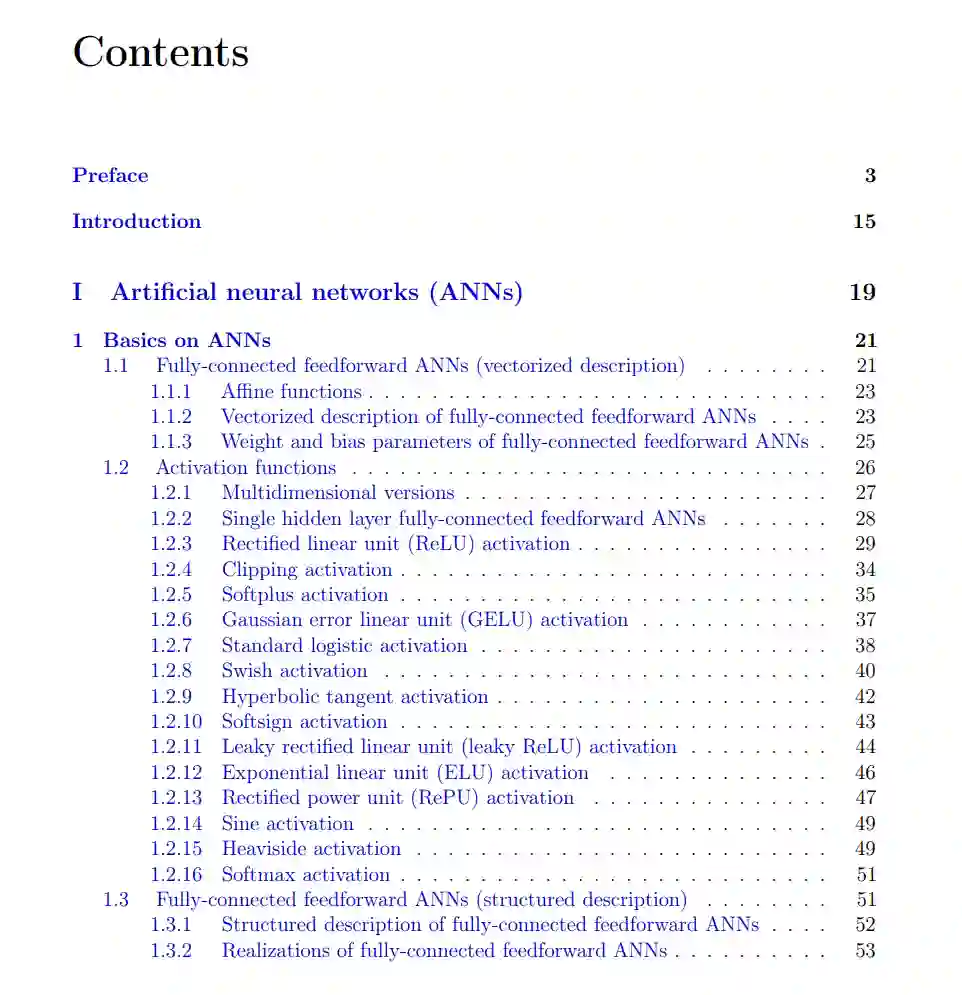

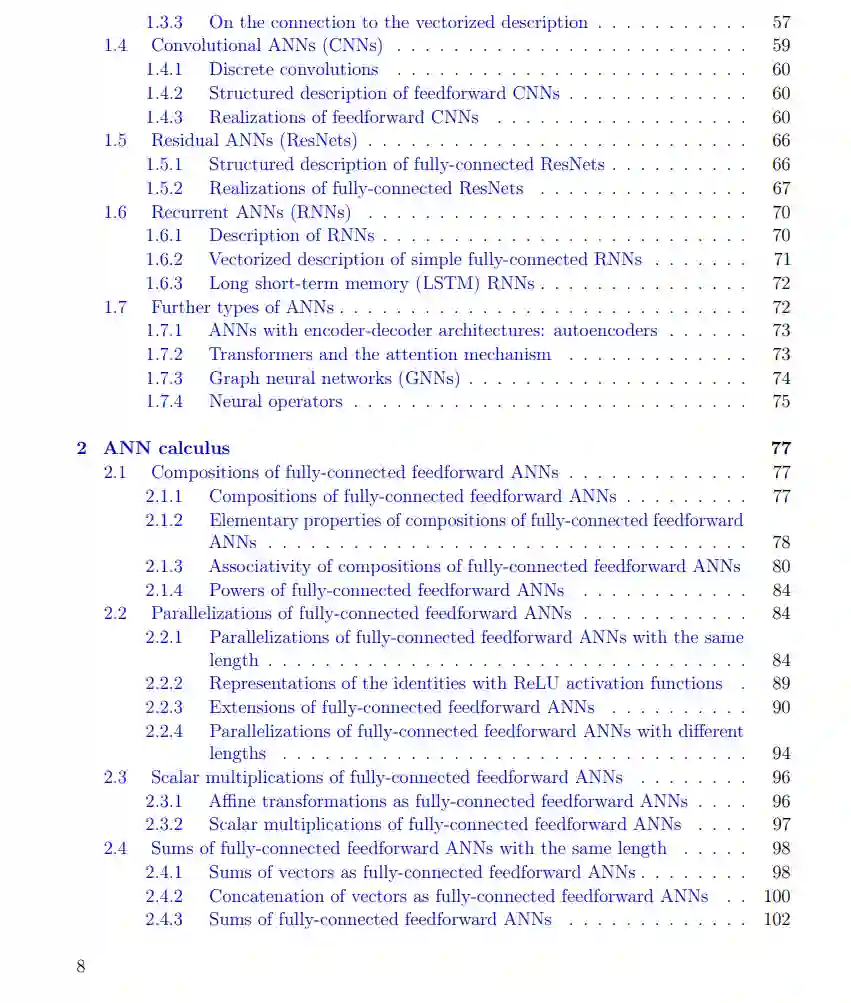

在简短的介绍之后,本书分为六部分(见第一部分、第二部分、第三部分、第四部分、第五部分和第六部分)。在第一部分中,我们在第1章中介绍了不同类型的ANNs,包括全连接前馈ANNs、卷积ANNs(CNNs)、循环ANNs(RNNs)和残差ANNs(ResNets),并详细介绍了它们的所有数学细节;在第2章中,我们介绍了全连接前馈ANNs的某种微积分。

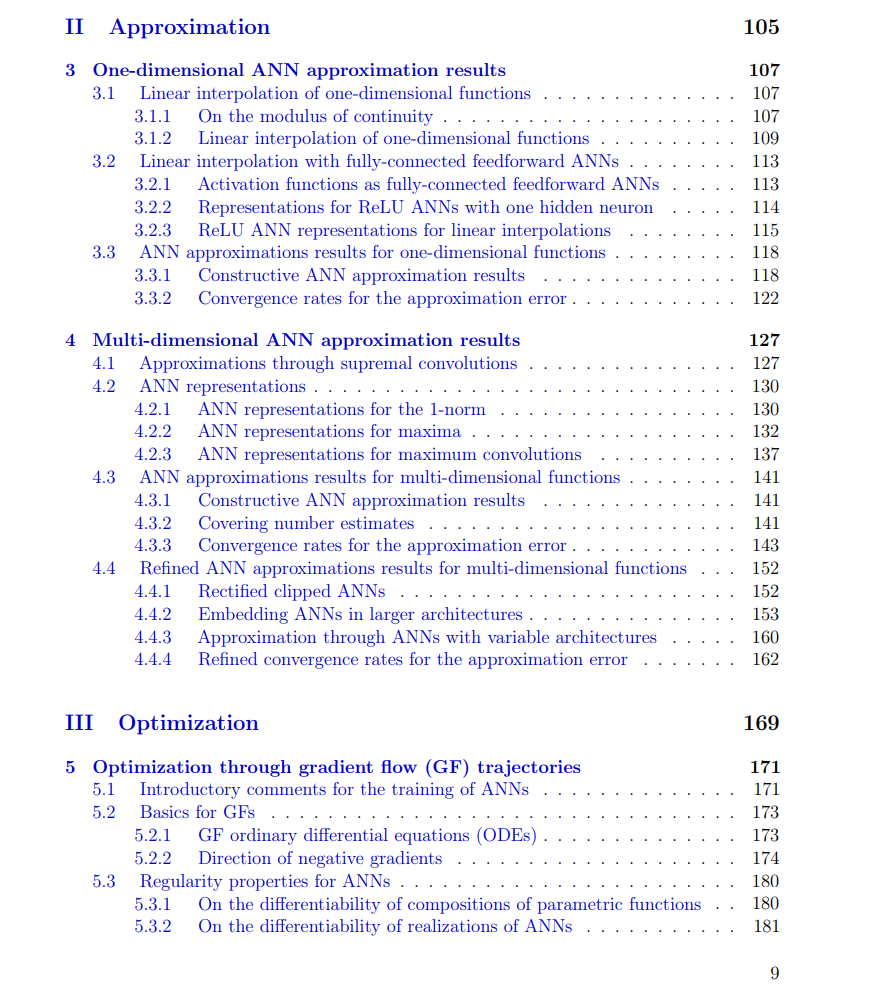

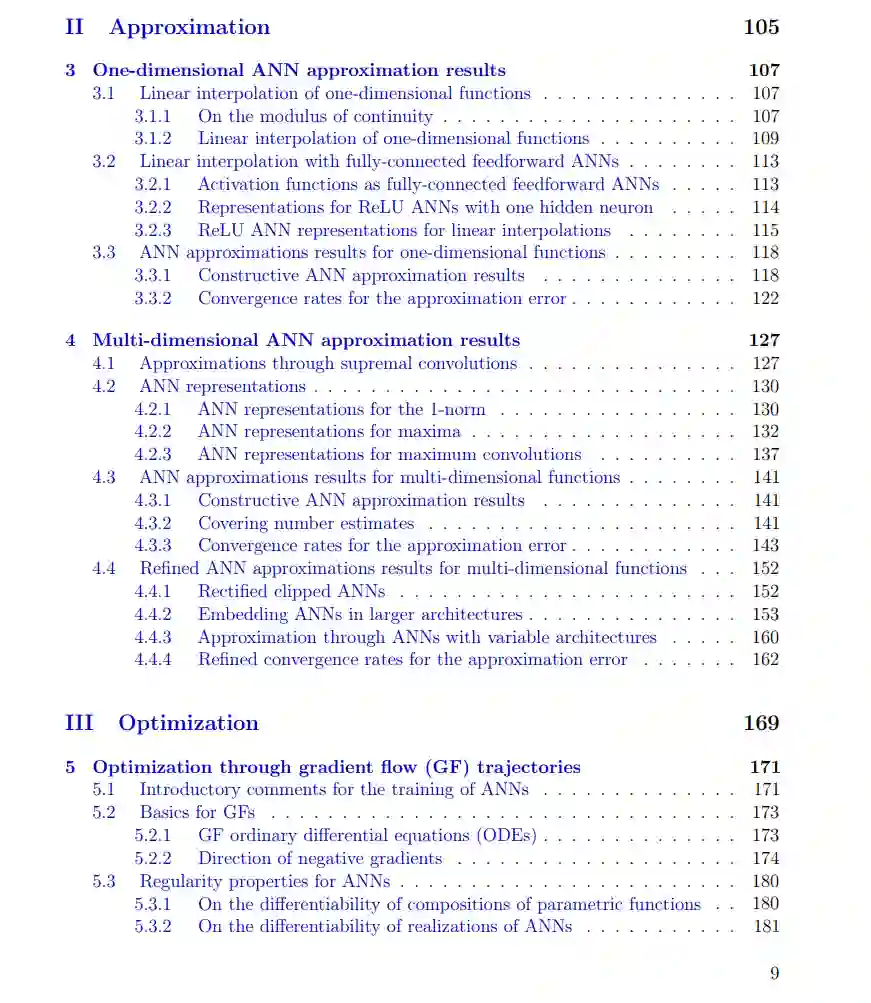

在第二部分中,我们介绍了几个数学结果,分析了ANNs如何逼近给定函数。为了使这部分内容更容易理解,我们首先在第3章限制自己研究从实数到实数的一维函数,然后在第4章研究多变量函数的ANN近似结果。

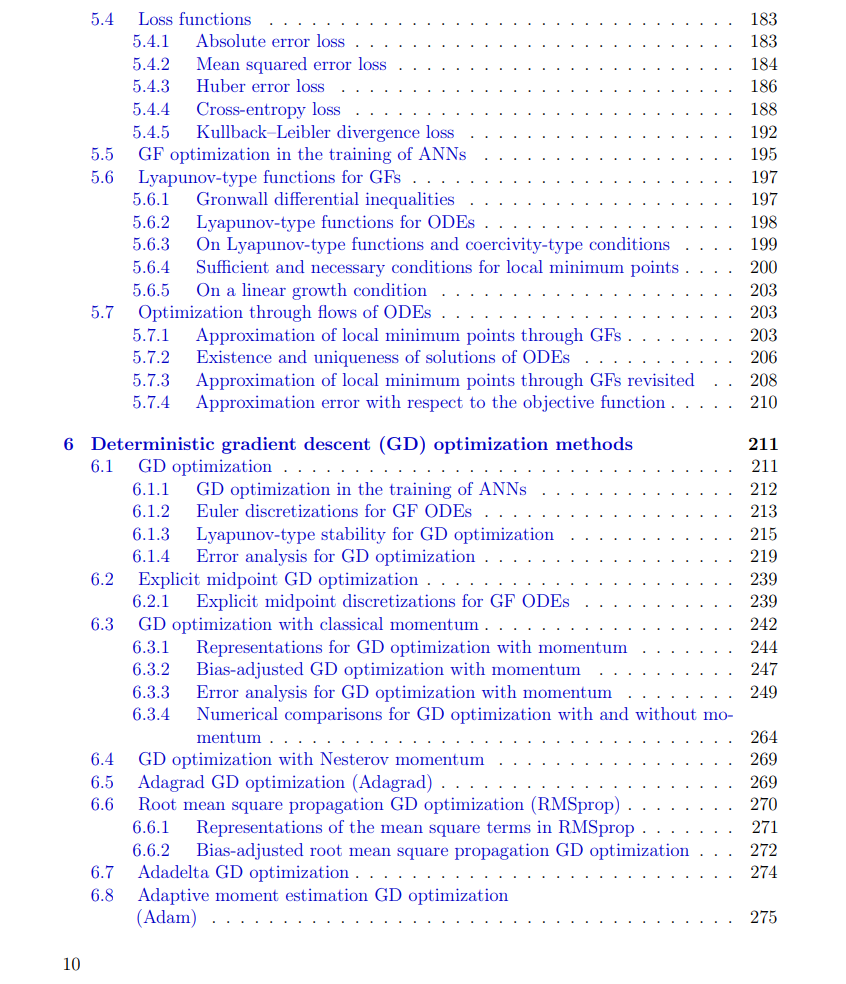

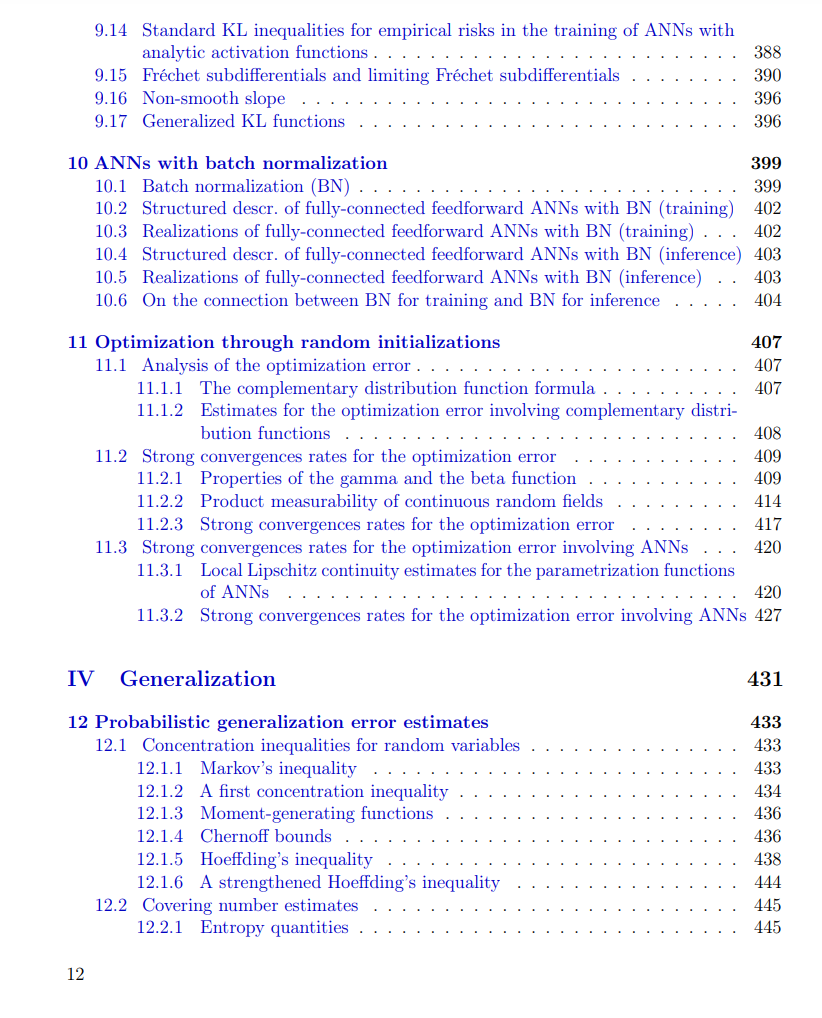

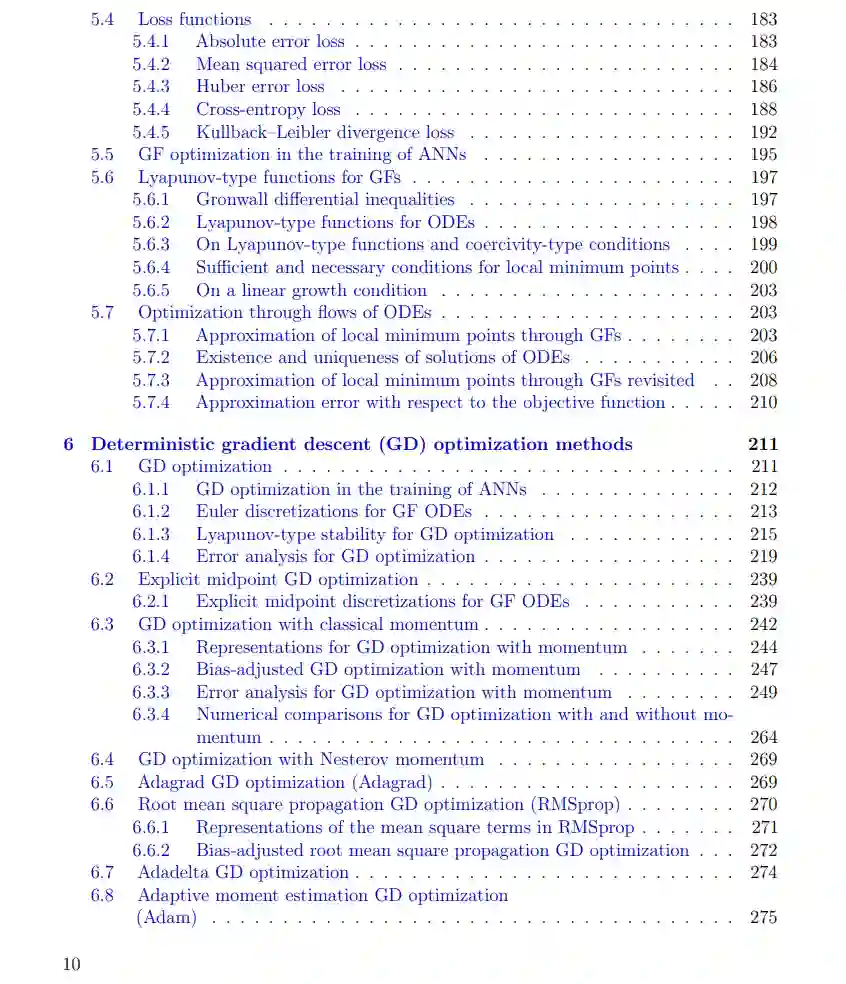

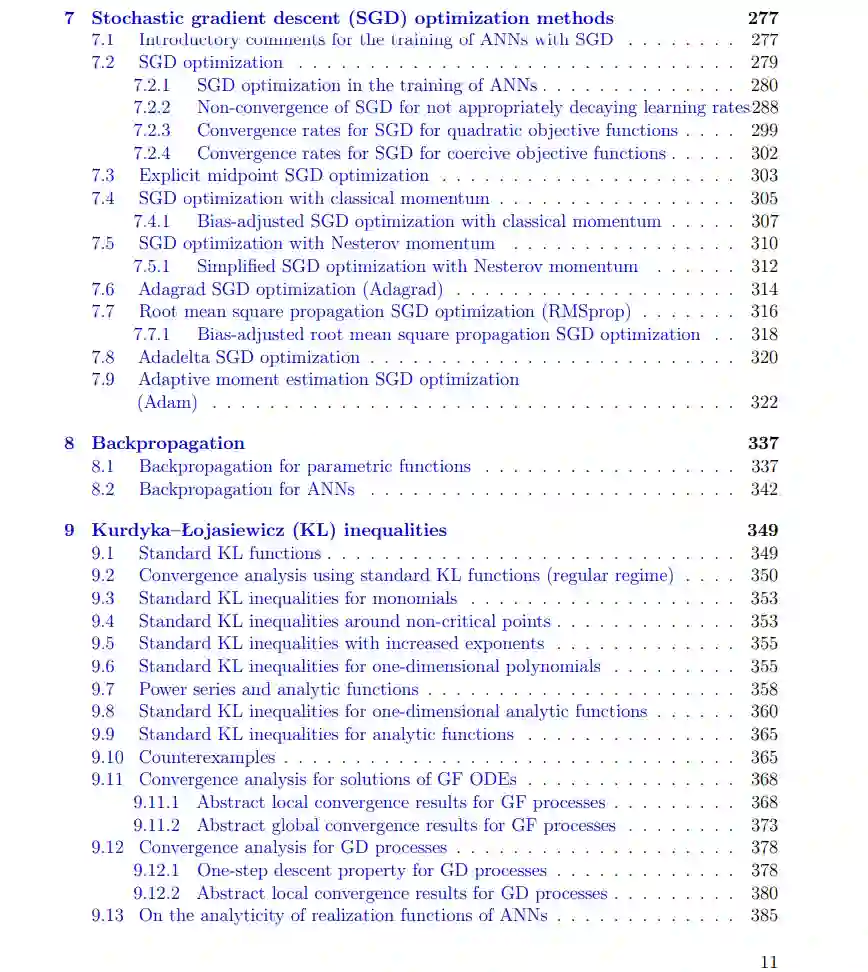

深度学习算法的一个关键方面通常是将所考虑的问题建模或重新表述为涉及深度ANNs的合适优化问题。第三部分的主题正是详细研究这些相关优化问题及其相应的优化算法,以近似解决这些问题。具体来说,在深度学习方法的背景下,这些优化问题通常以最小化问题的形式给出,并通常通过适当的基于梯度的优化方法来解决。大致来说,我们认为基于梯度的优化方法是一种计算方案,旨在通过执行基于(负)梯度方向的连续步骤来解决所考虑的优化问题。第6章回顾并研究了这类基于梯度的优化方法的确定性变体,如梯度下降(GD)优化方法;第7章回顾并研究了这类基于梯度的优化方法的随机变体,如随机梯度下降(SGD)优化方法。大致来说,GD型和SGD型优化方法可以被视为适当的梯度流(GF)常微分方程(ODEs)解的时间离散近似。为了发展对GD型和SGD型优化方法以及我们用来分析这些方法的一些工具的直觉,我们在第5章研究了这样的GF ODEs。特别是,我们在第5章展示了如何使用这样的GF ODEs来近似解决适当的优化问题。在第6章和第7章中讨论的基于梯度的方法的实现需要高效的梯度计算。在ANN训练中显式计算这些梯度的最流行且在某种意义上最自然的方法是反向传播方法,我们在第8章中推导并详细介绍了它。我们在第5章、第6章和第7章中呈现的基于梯度的优化方法的数学分析在几乎所有情况下都过于严格,无法涵盖与ANN训练相关的优化问题。然而,这些优化问题可以通过Kurdyka–Łojasiewicz(KL)方法来涵盖,我们在第9章详细讨论了这一方法。在第10章中,我们严格回顾了批量归一化(BN)方法,这是一种旨在加速数据驱动学习问题中ANN训练程序的流行方法。在第11章中,我们回顾并研究了通过不同的随机初始化来优化目标函数的方法。

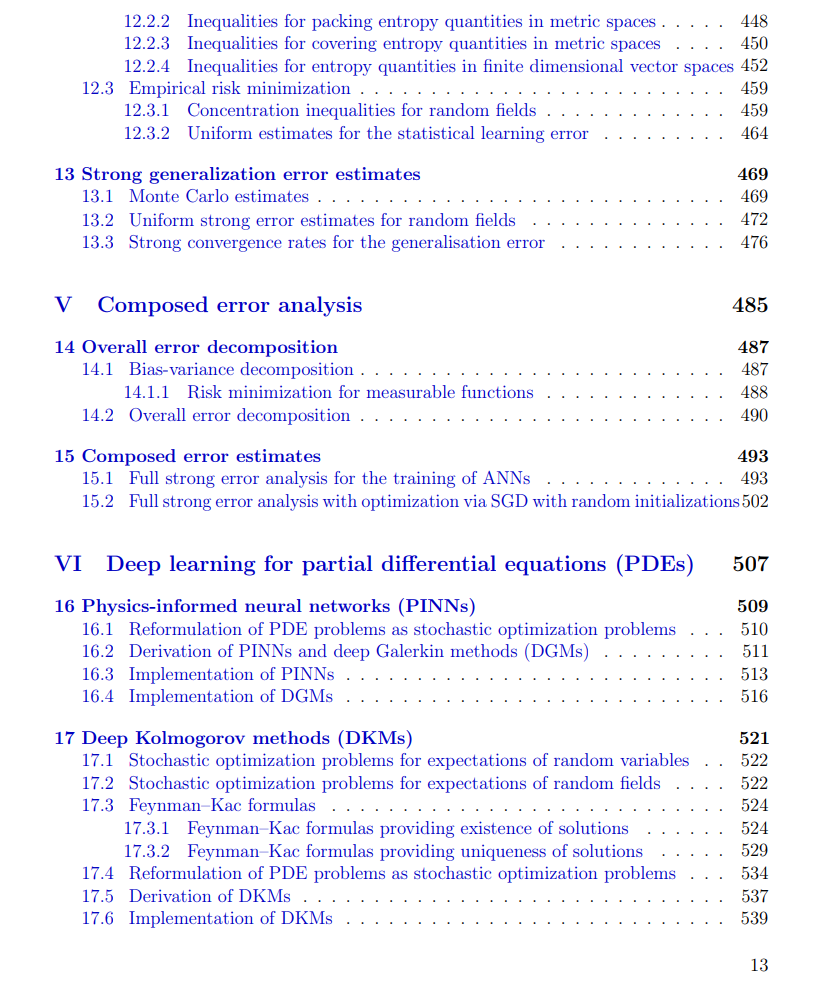

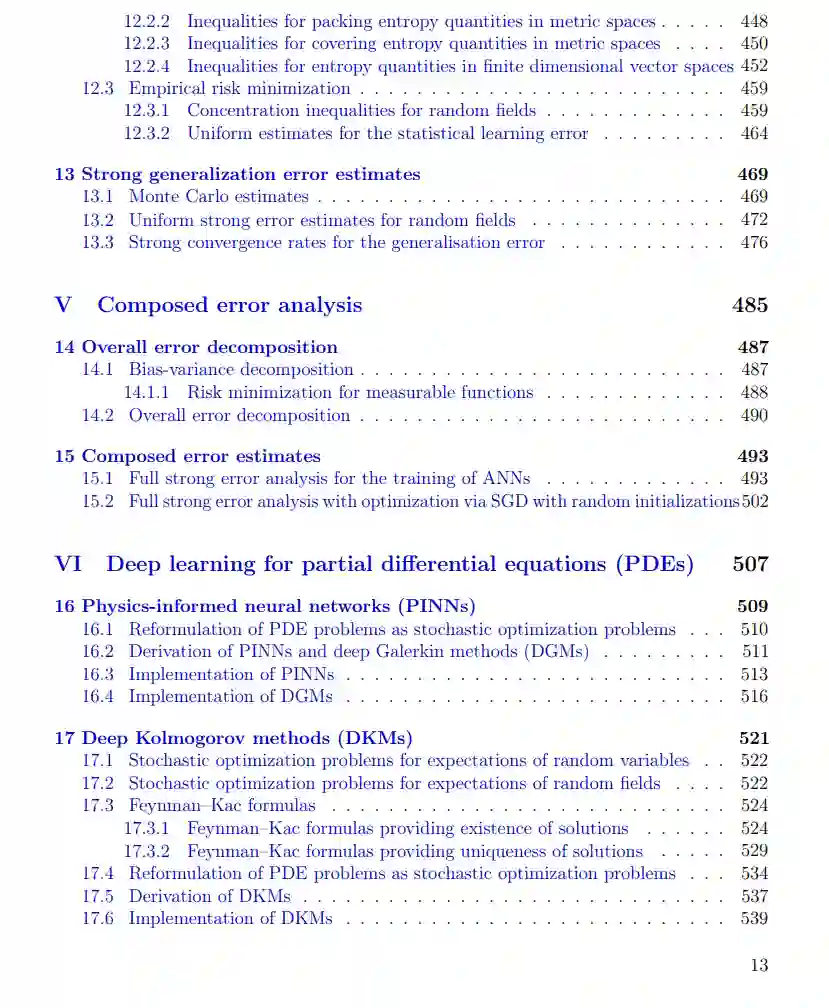

深度学习算法的数学分析不仅包括对ANNs近似能力的误差估计(参见第二部分)和涉及的优化方法的误差估计(参见第三部分),还需要对泛化误差进行估计。简而言之,当与学习问题相关的概率分布无法明确访问,而是通过有限数量的实现/数据来近似时,就会产生泛化误差。第四部分的主题正是研究泛化误差。具体来说,在第12章中,我们回顾了适用的概率泛化误差估计,在第13章中,我们回顾了适用的强Lp类型泛化误差估计。

在第五部分中,我们展示了如何结合第二部分的近似误差估计部分、第三部分的优化误差估计部分以及第四部分的泛化误差估计部分,以建立基于SGD类型优化方法的ANNs训练的整体误差估计。具体来说,在第14章中,我们为监督学习问题提出了适当的整体误差分解,我们在第15章中结合第二部分、第三部分和第四部分的一些发现,建立了上述示例性的整体误差分析。

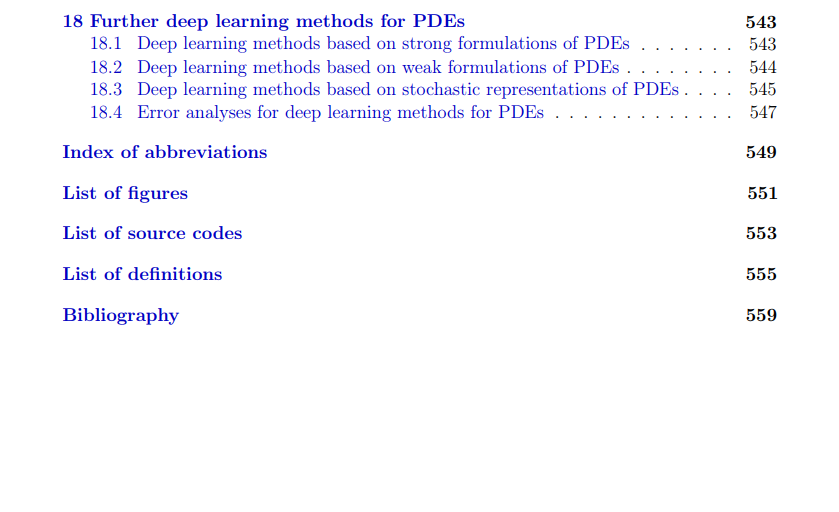

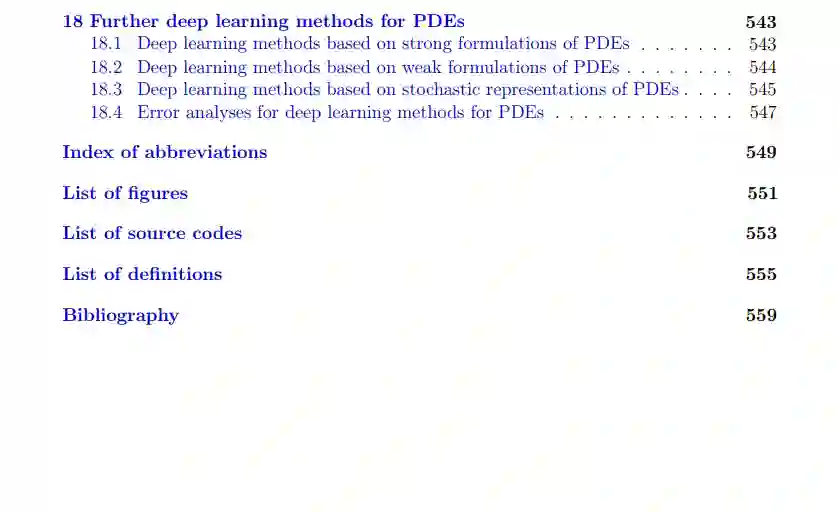

深度学习方法不仅在数据驱动的学习问题中变得非常流行,如今也被广泛用于近似求解偏微分方程(PDEs)。在第六部分中,我们回顾并实现了PDEs的三种流行的深度学习方法。具体来说,在第16章中,我们处理了物理信息神经网络(PINNs)和深度Galerkin方法(DGMs),在第17章中,我们处理了深度Kolmogorov方法(DKMs)。

这本书包含了许多Python源代码,这些源代码可以从两个来源下载,即公共GitHub仓库 https://github.com/introdeeplearning/book 和这本书的arXiv页面(点击“Other formats”链接,然后点击“Download source”)。为了方便参考,本书中每个源代码列表的标题都包含了相应源文件的文件名。