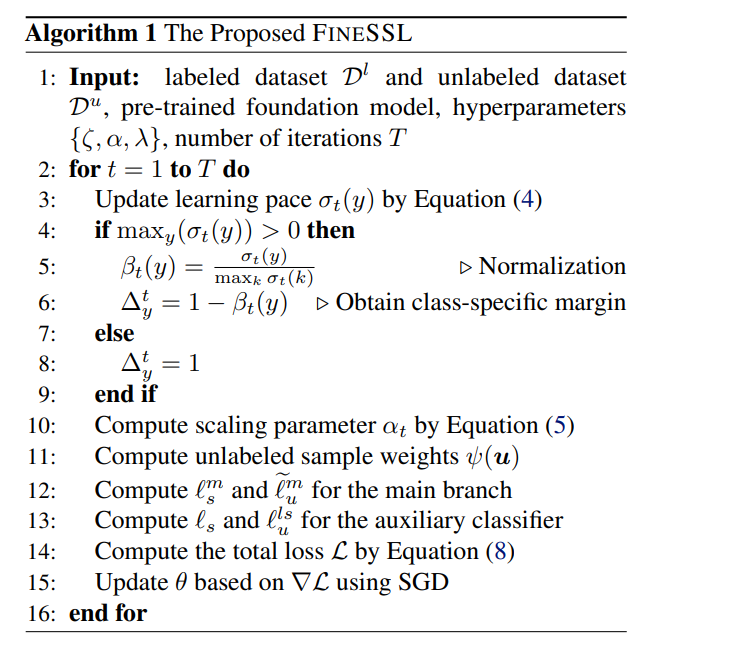

半监督学习(SSL)取得了显著进展,催生了许多方法变体。然而,实践者在尝试部署这些方法时常常遇到性能不佳的挑战。在本文中,我们提出了一种名为FINESSL的新型SSL方法,通过适应预训练的基础模型显著解决了这一限制。我们识别了基础模型中固有的聚合偏差和认知偏差问题,并提出了一个简单而有效的解决方案,通过引入平衡边缘软最大值和解耦标签平滑。在广泛的实验中,我们证明了FINESSL在多个基准数据集上设立了SSL的新标准,训练成本降低了六倍以上,并且可以无缝集成各种微调和现代SSL算法。源码可在https://github.com/Gank0078/FineSSL获取。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日