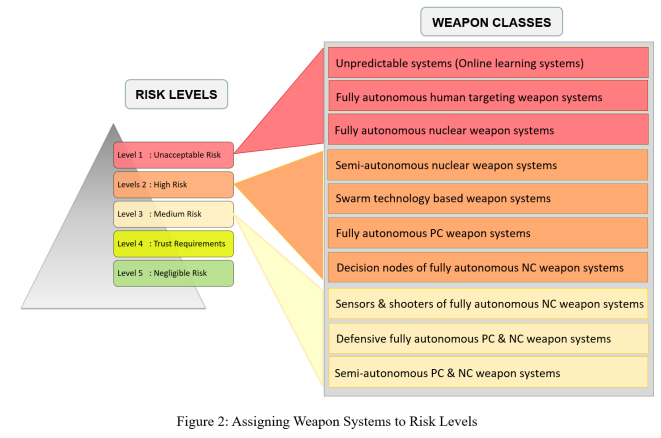

将人工智能技术应用于军事系统引发重大风险,主要源于国际人道法遵约要求与战场可靠性能考量。基于风险的监管路径能依据系统类型特质的风险性质与严重度定制缓释措施,避免过度阻碍技术发展与应用。本文提出五级风险分层框架,采用定性模型评估不同军事系统风险,其参数体系反映核心关切维度;进而主张建立差异化风险缓释机制,探讨可纳入的缓释措施类型。该路径还通过两种方式促进AI军事系统监管国际共识:首先将庞杂风险解构为简明集合以聚焦讨论;其次推动负责任国家通过自我监管确保可靠性能,为争议问题建立共同基础。

当前国际社会普遍认同:人工智能(AI)技术应用于各类系统的风险重大,须妥善应对。近年多边机构在制定AI全球标准方面取得显著进展,涵盖技术标准与负责任AI的伦理政策维度(Kerry等,2021)。2018年七国集团(G7)同意建立"全球人工智能伙伴关系"(GPAI),该多边倡议致力于探索AI发展的监管挑战与机遇。公私机构亦涌现大量宣言与框架指导负责任AI发展,其中许多已从原则声明演进为完整政策框架。军事领域,2019年联合国(UN)确立致命性自主武器系统(LAWS)新兴技术使用指导原则(联合国裁军事务厅,2019);2020年2月美国防部通过《AI伦理原则》(美国防部,2020),然其未必专门针对军事系统。值得注意的是,欧盟对AI应用监管已采用风险分级路径。

原则虽是政策制定实施的起点,仍需细化机制指导落地。对军事系统采用风险分级监管,有望成为从缓释原则转向政策实践的有效路径。因各类军事系统风险差异显著,统一缓释策略将导致三重困境:对高风险系统失之过宽,对低风险系统矫枉过正,阻碍对人类有益的军事技术发展。风险分级路径则可规避这些缺陷。

本文首先剖析AI技术特性如何引致系统潜在问题,比较民用与军事系统风险分级路径的演化原则;聚焦军事系统,探讨其核心AI风险关切;主要贡献在于提出"风险分级体系",勾勒军事AI系统风险缓释的实施框架。该体系通过精细化缓释路径促进军事AI责任领域的国际外交:聚焦关键议题推动争议问题早期共识。本文还论证:在AI军事系统全生命周期实施风险缓释措施并非零和博弈,纯粹基于提升作战效能的考量亦构成采纳这些措施的充分理由。