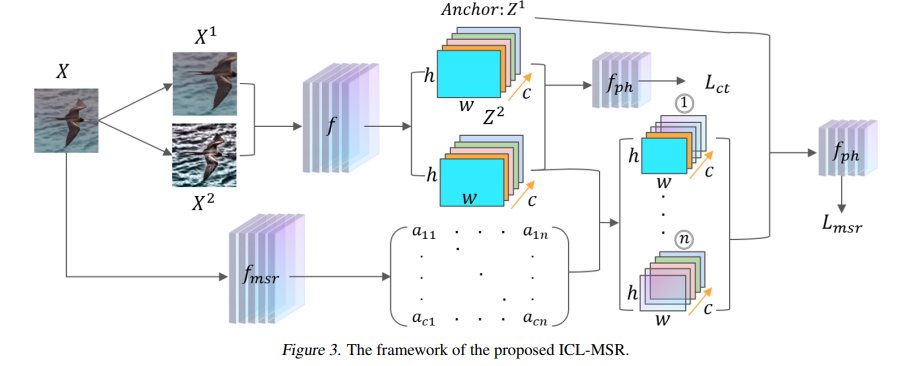

基于对比学习(CL)的自监督学习模型以成对的方式学习视觉表征。虽然目前流行的CL模型已经取得了很大的进展,但在本文中,我们发现了一个一直被忽视的现象:当用全图像训练CL模型时,在全图像中测试的性能比在前景区域测试的性能要好;当使用前景区域训练CL模型时,在完整图像中测试的性能比在前景区域测试的性能差。这一观察结果表明,图像中的背景可能会干扰模型学习的语义信息,其影响尚未完全消除。为了解决这个问题,我们建立了一个结构因果模型(SCM),将背景建模为一个混淆剂。我们提出了一种基于后门调整的正则化方法,即基于元语义正则化的介入性对比学习(ICLMSR),对所提出的供应链管理进行因果干预。ICL-MSR可以整合到任何现有的CL方法中,以减轻表征学习的背景干扰。从理论上证明了ICL-MSR具有更小的误差界。经验上,我们在多个基准数据集上的实验表明,ICL-MSR能够提高不同最先进的CL方法的性能。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2022年8月18日

Arxiv

12+阅读 · 2021年10月4日