大型语言模型(LLMs)因其在自然语言理解与生成方面的强大能力,在问答(QA)任务中展现出卓越表现。然而,基于 LLM 的问答系统在面对复杂问答任务时仍面临诸多挑战,包括推理能力不足、知识更新滞后以及幻觉生成等问题。 为应对这些挑战,近年来多个研究工作尝试将 LLM 与知识图谱(KGs)结合用于问答任务。在本综述中,我们提出了一种新的结构化分类法,根据问答任务类型和知识图谱在与 LLM 整合过程中的角色,对现有融合方法进行系统归类。 我们全面回顾了当前将 LLM 与 KG 结合用于问答的最新研究进展,从方法的优势、局限性以及对知识图谱的依赖性等方面进行了对比分析。随后,我们将这些方法与不同类型的问答任务进行对齐,探讨它们是如何应对复杂问答中主要挑战的。 最后,我们总结了相关研究在技术发展、评估指标与基准数据集方面的进展,并重点指出当前仍然存在的开放挑战与未来机遇。

1 引言

**问答(Question Answering, QA)**在人工智能、自然语言处理、信息检索和数据管理等领域中扮演着基础性角色,因其应用范围广泛,包括文本生成、聊天机器人、对话生成、网页搜索、实体链接、自然语言查询、事实核查等。**预训练语言模型(PLMs)和近期的大语言模型(LLMs)在诸如知识库问答(KBQA)、知识图谱问答(KGQA)、封闭域问答(CDQA)等任务中展现出卓越表现。 然而,基于 PLM 和 LLM 的方法在面对复杂问答任务(complex QA)**时仍存在如下关键局限: 1. 复杂推理能力有限:LLMs 通常通过预测文本中的下一个词进行预训练,因此内嵌的推理能力相对受限; 1. 缺乏最新和领域特定的知识:LLMs 的知识来自于预训练语料,在时间上存在“知识截止”,难以准确应对特定领域的实时问答; 1. 倾向于生成幻觉内容(hallucinations):由于缺乏事实校验和逻辑一致性检查,LLMs 易生成不真实或不可靠的回答。

挑战分析

检索增强生成(Retrieval-Augmented Generation, RAG)方法(Mao 等,2021)被提出用于开放域问答,其通过从大量文档中检索相关上下文辅助生成答案。同时,包括图神经网络(GNNs)(Li 等,2025b)等多种技术被用于提升检索覆盖度。尽管 RAG 相比非 RAG 方法在生成质量上有所提升,但其在处理复杂问答任务时仍存在显著限制,主要体现在以下方面: 1. 知识冲突:LLMs 与外部检索内容之间可能存在不一致或冗余知识,融合时易导致答案前后矛盾; 1. 检索上下文的相关性与质量不足:RAG 的回答质量依赖于检索内容的准确性,若上下文无关,则容易生成错误答案; 1. 缺乏迭代与多跳推理能力:对需全局理解与摘要推理的问题,RAG 结构通常难以生成解释性强、准确性高的答案。

研究动机

将 LLMs 与知识图谱(KGs)相结合的趋势,为解决上述 LLMs 在知识密集型任务(如复杂问答)中的不足提供了新的可能性(Ma 等,2025a)。近期提出的图结构检索增强生成(GraphRAG)(Zhang 等,2025;Peng 等,2024;Han 等,2024)与知识图谱检索增强生成(KG-RAG)(Sanmartin,2024;Yang 等,2024)方法,展示了在复杂问答任务中融合 LLMs 与 KGs 的强大潜力。这些方法通常引入模块化机制,如知识融合、推理指导、知识验证与优化,从而有效缓解上述挑战。

研究目标

近年来,融合 LLMs 与 KGs 以支持开放域与长上下文的复杂问答任务的研究快速增长。本综述旨在回应上述问题,全面梳理将 LLMs 与 KGs 集成用于复杂问答的最新进展,系统总结技术成果,并识别关键挑战与未来研究机遇。 与现有综述(详见附录 §A.1)不同,本研究从 KGs 在 LLM+KG 问答融合中的角色出发,提供了一个更为全面的分析框架。

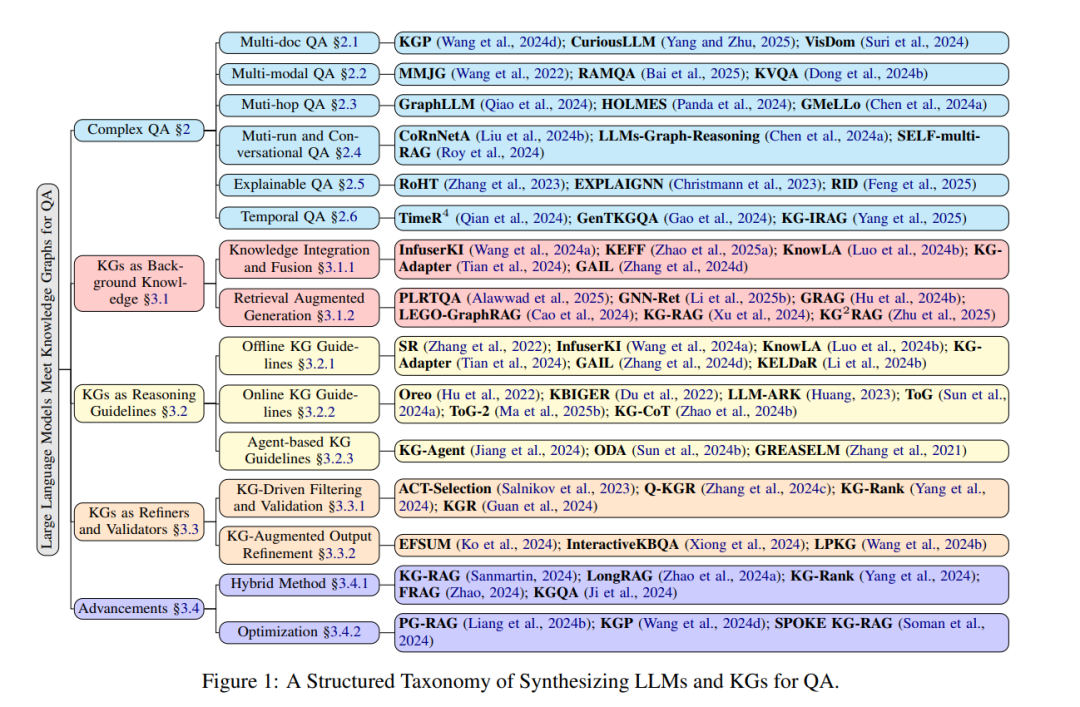

方法分类体系

我们从多个视角出发,构建了融合 LLMs 与 KGs 应用于复杂问答任务的方法分类体系,结构化的分类图见附录 §B 中的图 1。值得注意的是,这些分类视角之间并非互斥,某一研究方法可能在不同视角下被归入多个类别。 本综述的所有相关资源可通过 GitHub 在线访问。

本文贡献

鉴于 LLMs 与 KGs 的广泛应用与流行度,本综述具有高度的时效性。我们主要贡献如下: 1. 提出结构化的分类体系:对现有融合 LLMs 与 KGs 的问答研究进行系统性归类; 1. 全面回顾现有方法:涵盖不同类别下的 SOTA 工作,并讨论该领域的最新研究议题; 1. 方法与任务对齐:分析不同方法如何应对复杂问答中出现的具体挑战; 1. 揭示挑战与前景:总结当前尚未解决的技术瓶颈,并指出未来的研究方向与发展机遇。