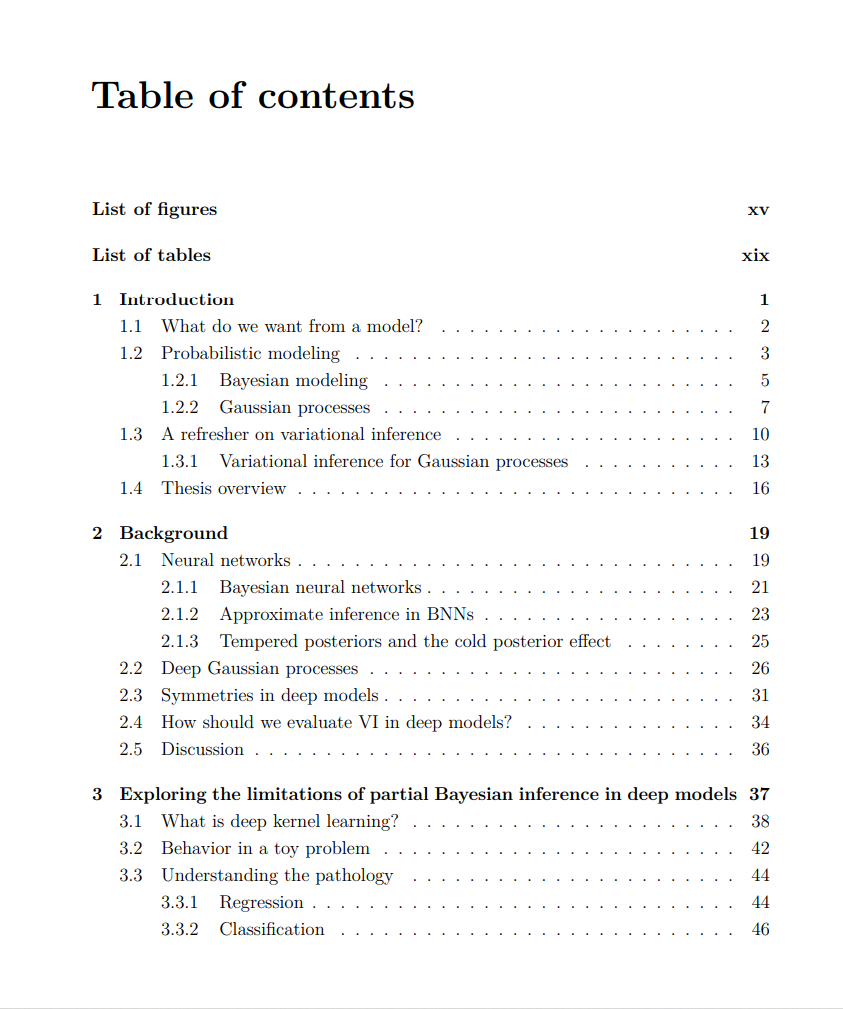

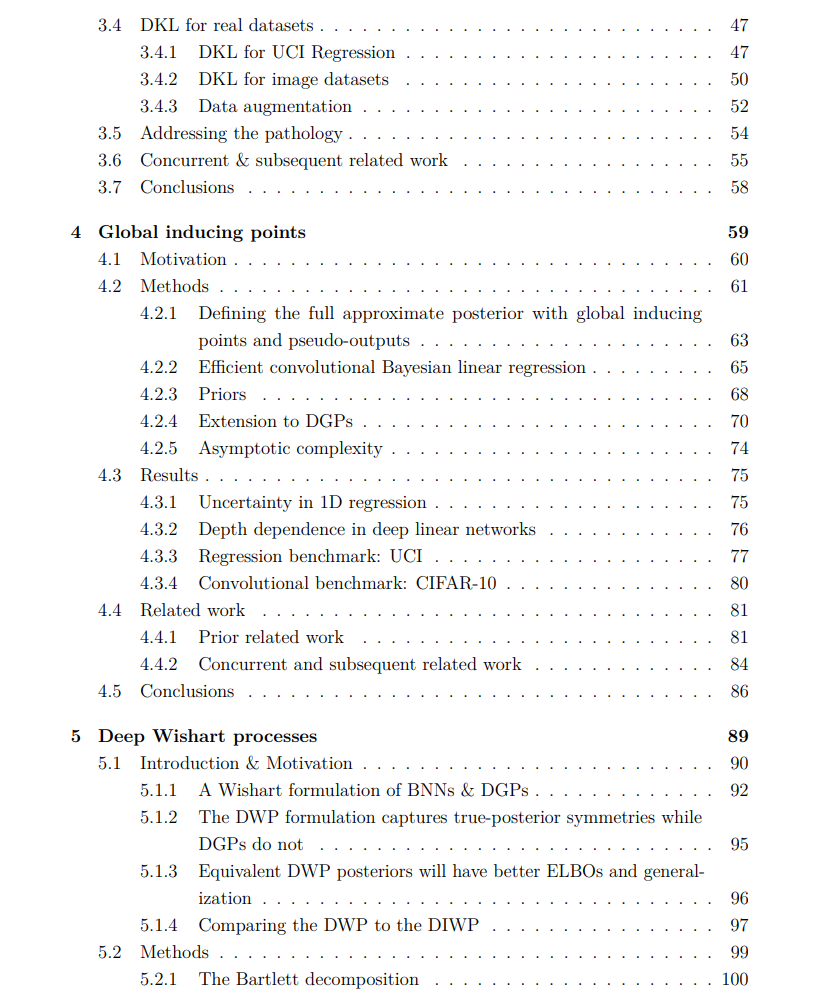

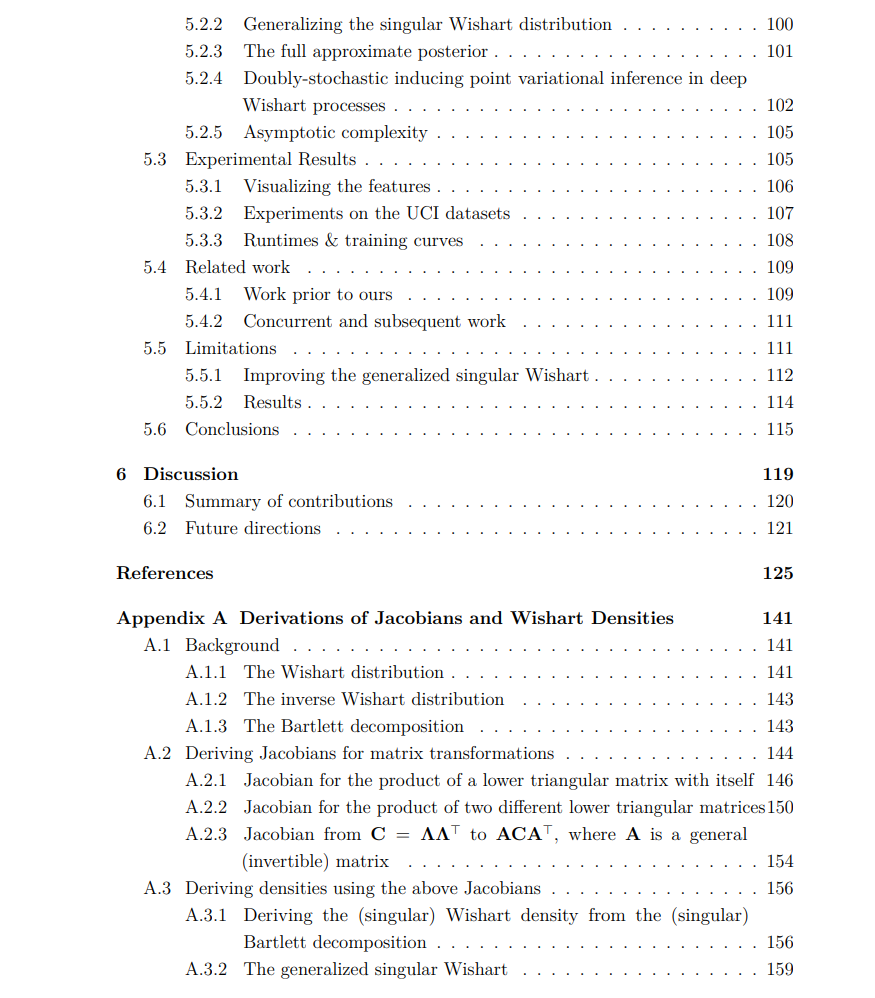

深度学习在过去的十年里引领了革命性的进展,它在各种任务的前沿,包括计算机视觉、自然语言处理和强化学习等领域取得了非凡的成就。然而,众所周知,通过最大似然估计训练的深度模型往往过于自信,并给出校准不良的预测。贝叶斯深度学习试图通过在模型参数上放置先验,然后与似然结合来执行后验推断来解决这个问题。不幸的是,对于深度模型来说,真实的后验是难以处理的,迫使用户不得不求助于近似。在这篇论文中,我们探讨了作为近似的变分推断的使用,因为它在同时近似后验和提供边缘似然的下界方面是独一无二的。如果这个下界足够紧,就可以用来优化超参数和促进模型选择。然而,这种能力在贝叶斯神经网络中很少被充分利用,可能是因为实践中通常使用的近似后验缺乏有效限制边缘似然的灵活性。因此,我们探索了深度模型的贝叶斯学习的三个方面。首先,我们的调查从询问是否有必要对尽可能多的参数进行推断开始,或者是否合理地将许多参数作为超参数,我们通过边缘似然来优化它们。这将带来显著的计算节省;然而,我们观察到这可能导致病态行为和严重的过拟合,表明尽可能“完全贝叶斯”是更好的选择。我们继续我们的论文,提出了一种变分后验,它为贝叶斯神经网络和深度高斯过程中的推断提供了统一的视角,我们展示了它有足够的灵活性来利用添加的先验超参数。最后,我们展示了如何在某些深度高斯过程模型中通过从后验中解析去除对称性,并对格拉姆矩阵而不是特征进行推断来改进变分推断。虽然我们没有直接调查我们的改进在模型选择中的使用,但我们希望我们的贡献将为将来充分实现变分推断的承诺提供一个跳板。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日