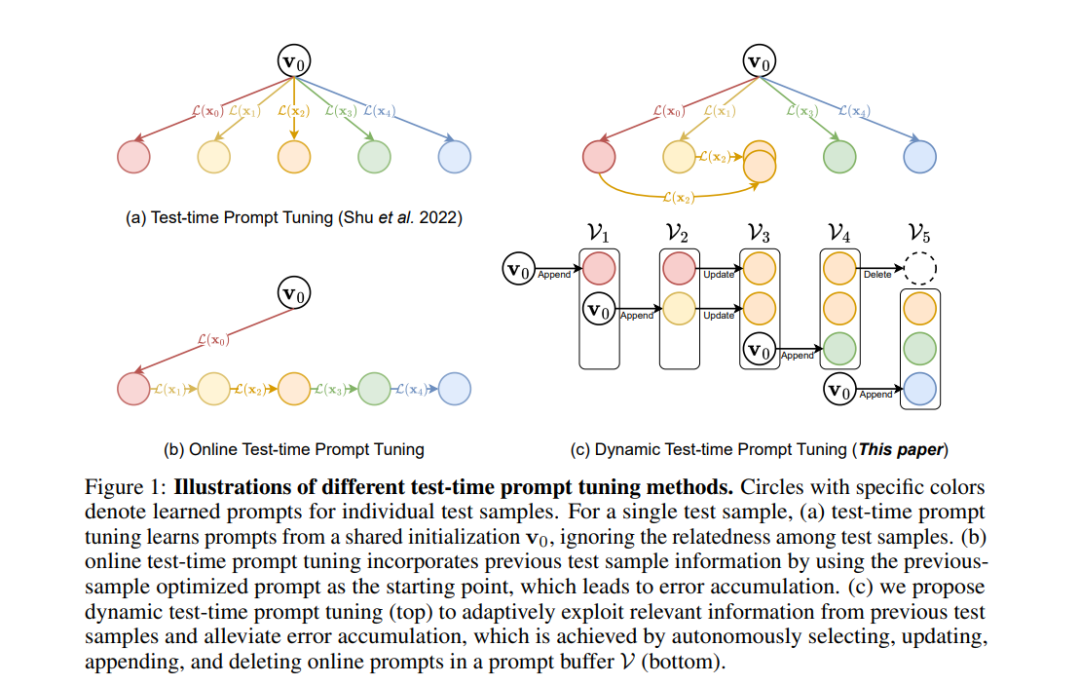

测试时提示调优增强了视觉-语言模型的零-shot泛化能力,但在推理过程中往往忽视了测试样本之间的相关性。在线测试时提示调优提供了一种简单的方式来利用前一个测试样本中的信息,尽管由于错误积累,可能会面临提示崩溃的风险。为了增强测试时提示调优,我们提出了DynaPrompt(动态测试时提示调优),在减少错误积累的同时,利用相关的数据分布信息。DynaPrompt基于在线提示缓冲区,自适应地选择和优化每个测试样本的相关提示。具体来说,我们引入了一种基于两个指标的动态提示选择策略:预测熵和概率差异。对于未见过的测试数据,我们开发了动态提示附加方法,允许缓冲区附加新的提示并删除不活跃的提示。通过这种方式,提示可以优化以充分利用特定测试数据中的有益信息,同时缓解错误积累问题。我们在14个数据集上的实验结果验证了动态测试时提示调优的有效性。

成为VIP会员查看完整内容

相关内容

Arxiv

36+阅读 · 2023年4月19日

Arxiv

73+阅读 · 2023年4月4日

Arxiv

132+阅读 · 2023年3月29日