Variational Autoencoders (VAEs) 是将概率论方法与深度学习方法结合的最著名框架之一。与许多传统的概率模型一样,VAE 通常追求两个相互关联的目标。第一个目标是近似数据的底层分布,从而能够生成新的样本,这些样本反映了从真实分布中抽取的样本的特性。第二个目标侧重于从数据中提取有价值的见解。本博士论文关注后一个目标,探索各种归纳偏置以指导模型从数据中学习有用的表示。我们探索的第一种归纳偏置是通过修改目标函数来对潜在空间施加某些约束,例如层次独立性,这是学习解耦表示的一个期望属性。我们接下来检验的归纳偏置是将结构纳入模型的潜在空间,使其更符合我们对底层数据的先验知识,正如我们在神经主题模型的案例中所示。我们实验的另一个类似的归纳偏置是设计模型的潜在空间,使其几何结构与数据的内在流形相匹配。除了探索归纳偏置之外,我们还提出了一种受能量基模型启发的替代方法,通过定义似然形式为指数族,其中充分统计量由神经网络参数化。最后,我们通过对不同网络容量和泛化问题难度的多种模型进行速率-失真分析,研究 VAE 对新数据的泛化能力。

https://hdl.handle.net/11245.1/1d0d5258-3796-45e8-a4f0-e24f536ce740

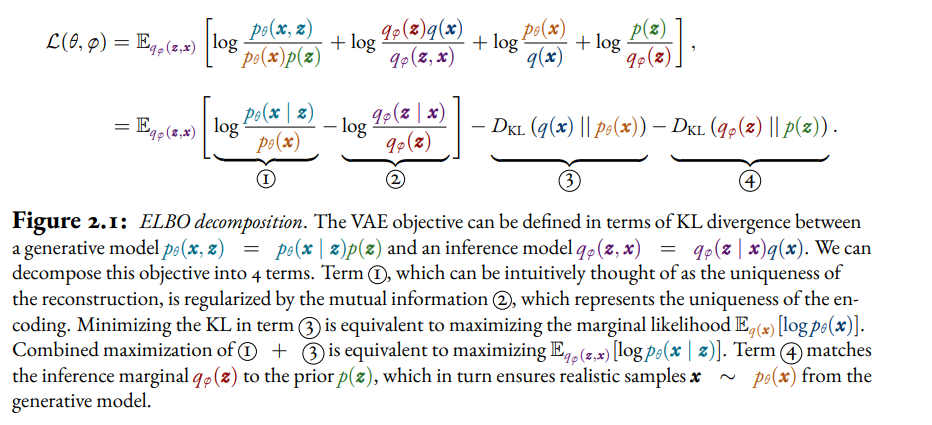

深度生成模型(DGMs)使用神经网络来参数化概率模型。这些模型在人工智能研究中有着悠久的历史,可追溯到早期的基于能量的模型,如 Boltzmann Machines(Hinton 和 Sejnowski,1983)和自编码方法,如觉醒-睡眠算法(Hinton 等人,1995)。在 2010 年代初重新对神经网络的兴趣后,随着变分自编码器(VAEs; Kingma 和 Welling (2013b); Rezende 等人 (2014))和生成对抗网络(GANs; Goodfellow 等人 (2014))的出现,DGMs 的研究重新获得了动力。从那时起,DGMs 已广泛应用于侧重于生成的设置,包括图像合成(Karras 等人,2019),音频合成(Oord 等人,2016)或分子结构的生成(Gómez-Bombarelli 等人,2018)。然而,DGMs 不仅仅有用于生成;它们还可以通过推断潜在表示来解释数据集的底层结构。本论文关注的是 DGMs 的这第二种用例。 使用深度生成模型学习表示的一个魅力在于,它以直观的方式结合了概率建模和深度学习的原则。我们可以将某些潜在变量的先验与神经似然结合起来,来表示像图像这样的数据模态,否则为其定义一个现实的似然将会很困难。通过训练结果模型以最大化与数据的一致性,我们获得了以模型后验形式的数据表示。这种学习表示的方法可以总结如下: 1. 设计一个联合模型 pθ(x, z) := p(z)pθ(x|z),其中先验 p(z) 和似然 pθ(x|z) 由带有权重θ的神经网络参数化。 1. 优化 θ 使得 pθ(x) ≈ pdata(x),其中 pdata(x) 是底层数据分布。 1. 对学习到的模型的后验 pθ(z|x)* 进行推断。 虽然这个方法很通用,但并不适用于所有类别的深度生成模型,特别是那些首先强调生成的模型。本论文主要关注 VAE(第2-4章和第6章)和在较小程度上关注基于能量的模型(EBMs,第5章)。VAEs 提供了一个概念上直接的框架,用于设计深度概率模型的变种,并且通过使用概率编码器近似后验,增加了测试时快速推断的优势。我们对(共轭)EBM的工作也将具有测试时快速推断的特性,通过定义后验是可解的基于能量的模型。

此外,有一些模型类别我们在本论文中不会考虑,包括 GANs、自回归模型(ARs)、标准化流(NFs)和扩散基模型(DBMs)。虽然 GAN 已被用于表示学习(Mukherjee 等人,2019),但由于没有用于推断潜在代码的编码器,它们不是自然的选择。反过来,NFs 和 DBMs 使用与数据同维度的向量值潜在变量,这意味着当我们关注的是学习到的表示而不是生成时,它们通常用处较小。 重要的是要强调,仅仅遵循讨论的步骤很可能不会产生适合任何任务的表示。这有许多原因。首先,在所有标准的深层潜在生成模型中,包括 VAE,潜在空间的先验是高斯的,这对大多数任务来说是次优的。此外,这种情况下先验的角色与其在贝叶斯模型中的功能不同。鉴于潜在变量可能有些任意且模型是从数据中学习的,先验并不像在经典贝叶斯模型中那样代表我们的初始信念。因此,从理论上讲,最大化对数似然与学习好的表示之间没有联系。事实上,如果有一个足够先进的生成模型,可以在 z 和 x 之间的互信息非常小的情况下达到高 log pθ(x)。针对这一点,研究人员经常将归纳偏置纳入生成模型中,以实现学习到的表示与特定任务之间更好的对齐。