自神经网络首次应用于摘要生成任务以来,抽象摘要模型取得了快速进展。我们已经从模型难以生成语法正确的句子进步到大型语言模型(如ChatGPT)能够生成流利的摘要,有时这些摘要甚至比某些人类撰写的摘要更好。摘要模型的应用正在超越新闻文章和会议记录等传统热门领域,扩展到医疗报告、金融文章、社交媒体对话、产品评论等新的小众领域。

尽管取得了进展,摘要模型的可靠性仍因罕见但灾难性的失败模式而受到质疑。例如,模型已知会生成包含事实错误或不支持输入内容的陈述的摘要(称为幻觉)。在医疗保健和金融等高风险应用中,这些错误如果被采纳可能导致严重后果。当在真实环境中部署时,模型可能会遇到输入噪音,这会显著降低摘要的质量。最后,尽管预训练模型大大提高了输出质量,来自网络的预训练数据可能会引入负面影响。例如,输出可能有毒或存在偏见,并且可能会逐字复制受版权保护的内容,导致最近的多起诉讼。这些问题可能会阻止实体在现实世界中部署摘要模型。

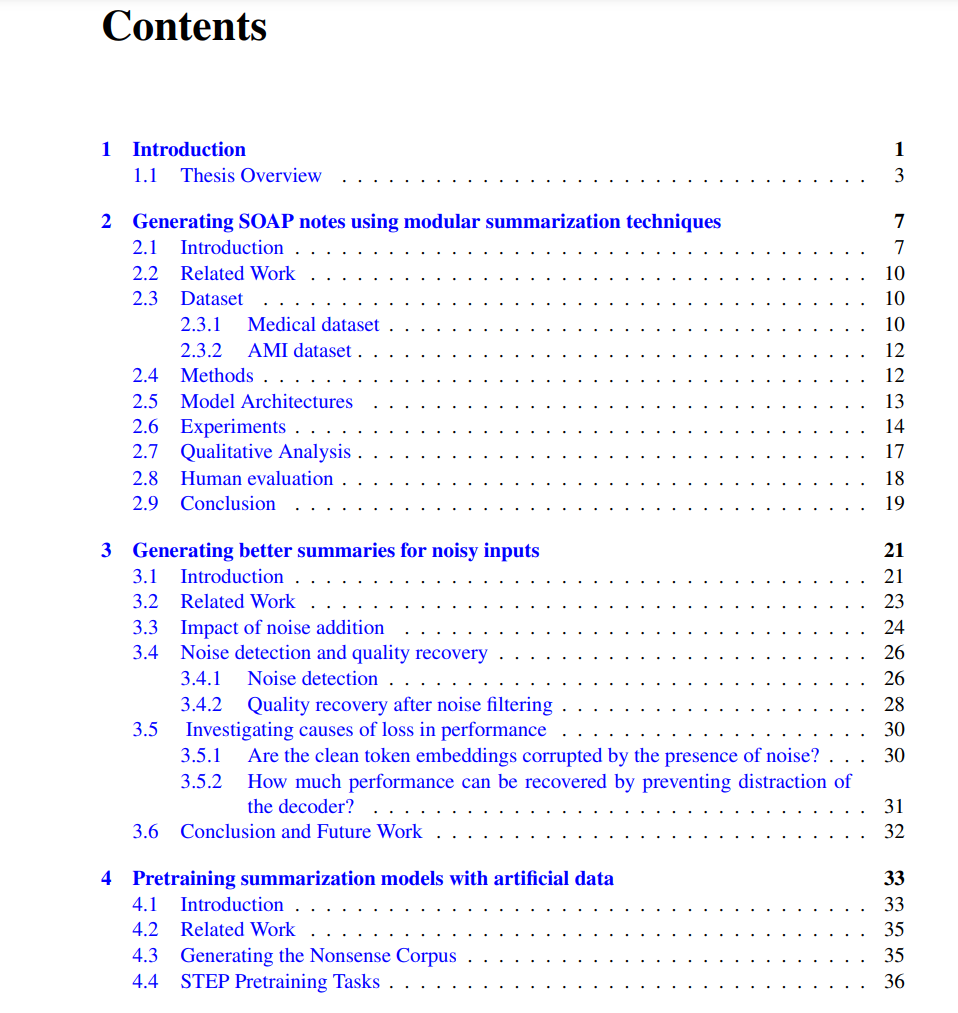

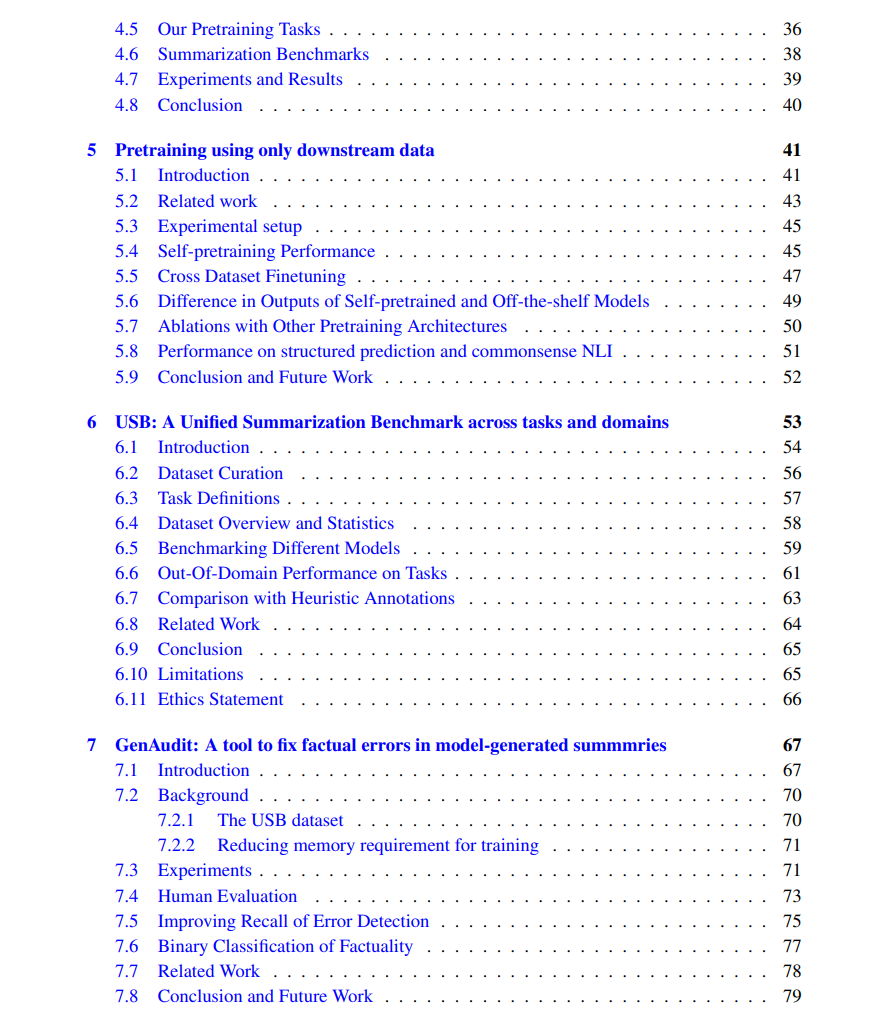

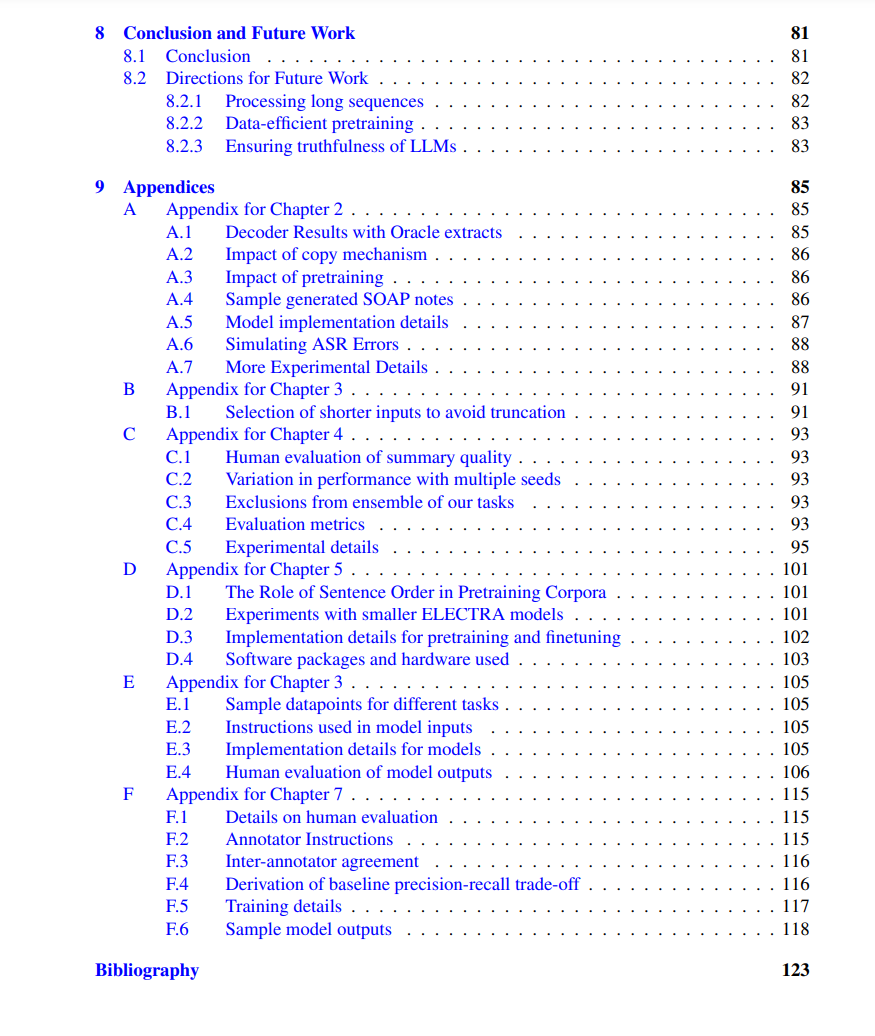

在本文中,我们提供了解决上述摘要模型问题的方法和资源。在第一部分中,我们提出了为具有挑战性特征的输入(如长对话或噪声文档)生成高质量摘要的方法。我们引入了一种模块化摘要生成管道来处理长序列,生成更好且更符合事实的摘要。然后,我们描述了输入噪音对摘要模型的影响,并设计了轻量级探测器来检测和消除噪音。在第二部分中,我们介绍了无需使用任何上游预训练文本语料库的预训练方法,但仍能实现大部分预训练对大型网络语料库的性能提升。提出的方法包括人工创建预训练语料库,并重复利用下游训练样本中的未标注文本进行预训练。此部分揭示了预训练带来的大部分性能提升归因于某种未知机制,而不是来自大规模外部预训练语料库的知识转移。在第三部分,也是最后一部分中,我们设计了验证大型语言模型生成摘要并检测其中潜在事实错误的方法。我们创建了一个公共基准数据集,用于训练和评估对事实核查摘要有用的多任务模型。然后,我们设计了一个交互工具,帮助用户将大型语言模型生成的摘要与参考文档进行核对,并展示了其在突出显示多种大型语言模型对不同领域文档生成的错误方面的有效性。