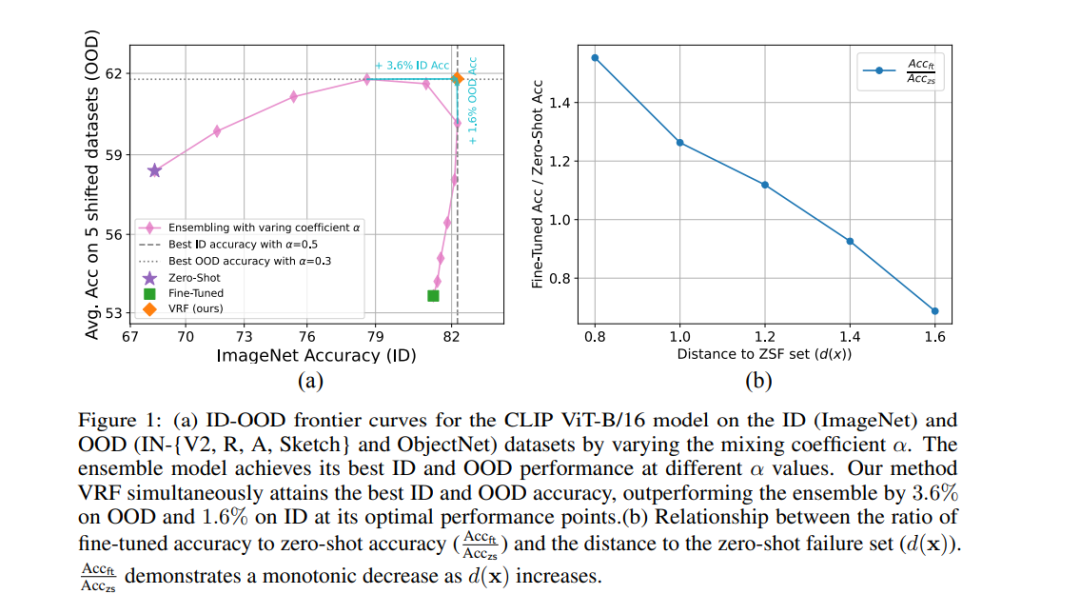

在微调零样本模型(如CLIP)时,我们的目标是让微调后的模型在分布内(ID)和分布外(OOD)数据上都表现出色。最近的研究表明,基于集成的方法(ESM)可以显著提高模型的稳健性,同时保持较高的ID准确率。然而,我们的研究发现,ESMs并未完全解决ID-OOD的权衡问题:它们在不同的混合系数下分别达到了ID和OOD准确率的最佳表现。当针对OOD准确率进行优化时,集成模型的ID准确率会显著下降,反之亦然。相比之下,我们提出了一种基于样本的集成技术,能够在不牺牲ID或OOD准确率的情况下同时达到最佳效果。 具体而言,我们构建了一个零样本失败(ZSF)集,其中包含了零样本模型错误预测的训练样本。对于每个测试样本,我们计算它与ZSF集的距离,并在集成中赋予微调模型更高的权重(当该距离较小时)。我们将此方法称为方差减少微调(VRF),因为它有效减少了集成预测的方差,从而降低了残余误差。在ImageNet和五个相关的分布偏移数据集上,VRF在保持或提高ID准确率的同时,将OOD准确率相比于集成基线进一步提高了1.5至2.0个百分点。VRF在其他分布偏移基准测试上也实现了类似的大幅稳健性提升(0.9至3.1个百分点)。代码可在 https://github.com/BeierZhu/VRF 获取。

成为VIP会员查看完整内容

相关内容

Arxiv

223+阅读 · 2023年4月7日

Arxiv

20+阅读 · 2023年3月21日