事实检验算法旨在利用现有知识库来检验文本的事实正确性。

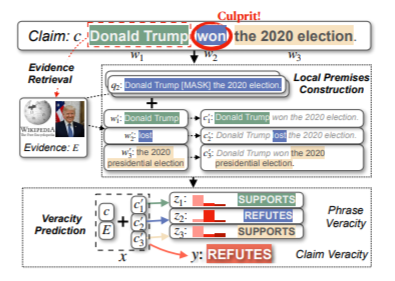

目前,事实验证的方法通常是将问题拆解为两个步骤:检索阶段(retrieval)和验证阶段(verification)。 在检索阶段,检索模型根据给定的陈述文本(claim)从知识库中检索得到相关的文本描述,作为用于验证最终结果的证据(evidence);在验证阶段,验证模型则会根据检索到的证据来推理得出最终的预测结果。 然而,大多数现有模型通常只是给出最终分类结果,缺乏对一个陈述正确与否的解释,导致我们很难知道模型为何做出了这样的预测。这对于构建值得信任的人工智能应用是十分有害的。 为了解决事实检验中的可解释性问题,字节跳动人工智能实验室和复旦大学的团队提出了 LOREN ,一种全新的可解释事实检验范式:将针对整个陈述的验证拆解为短语级别的验证。

Paper: https://www.zhuanzhi.ai/paper/ef84397cfe7e6ec8e906d047895d1564

Code: https://github.com/jiangjiechen/LOREN

在该范式下,模型能够给出整个陈述的细粒度验证结果,从而以更直观的方式帮助大家了解模型推理过程,也能够更快地锁定事实错误。

成为VIP会员查看完整内容