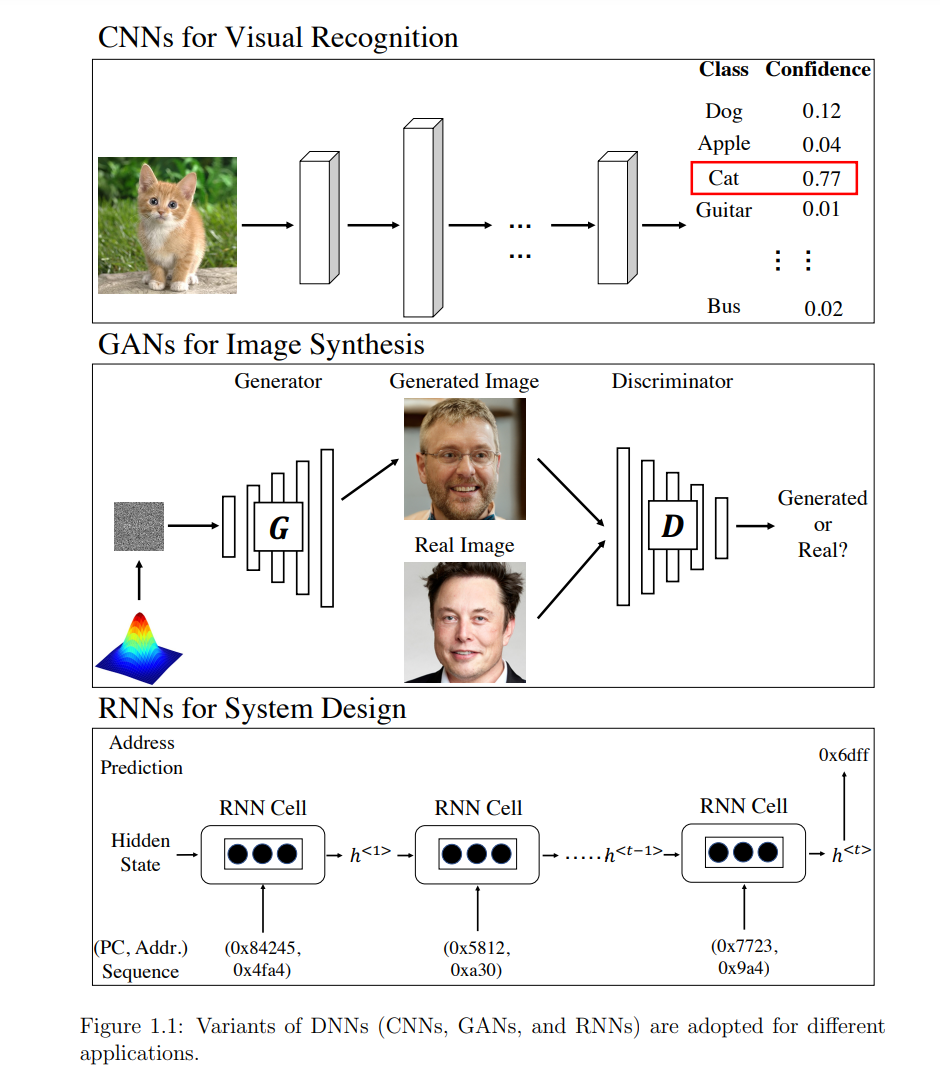

**深度神经网络(dnn)在人工智能(AI)的广泛应用中蓬勃发展。深度神经网络的普遍采用可以归因于其对不同任务的高度可定制性。**事实上,研究人员已经为不同的应用设计了DNNs的变种,例如,用于视觉识别的卷积神经网络(CNNs)、用于图像合成的生成对抗网络(GANs)、用于时间序列处理的循环神经网络(RNNs)等。所有这些变体都具有高度不同的网络拓扑和训练目标。

https://dataspace.princeton.edu/handle/88435/dsp01zk51vm00t

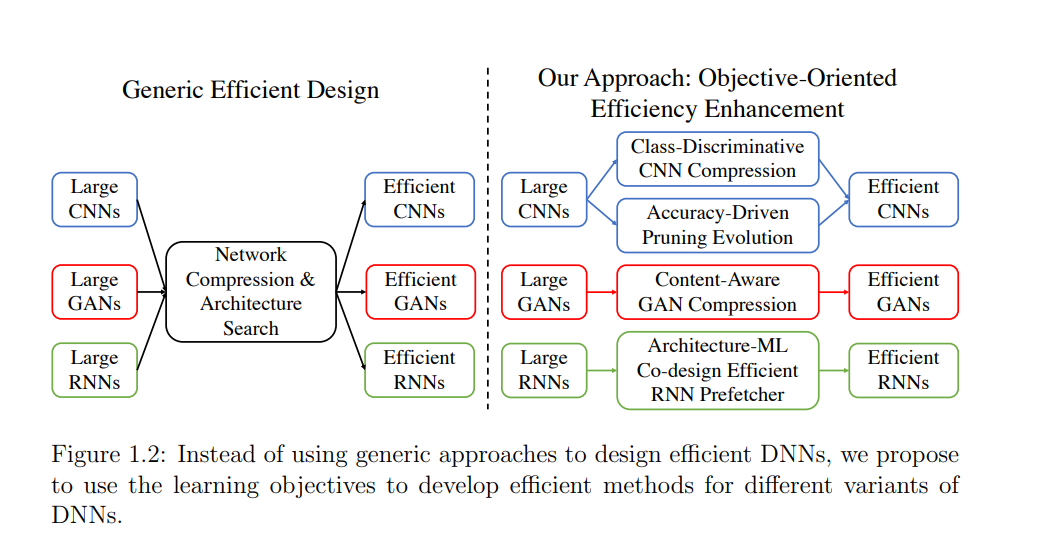

尽管DNNs取得了成功,但人们越来越关注DNNs的效率。当前的DNN资源匮乏,为它们在资源有限的边缘设备上部署设置了困难的障碍。然而,深度神经网络应用的广泛性增加了发现高效的不同变体深度神经网络的难度。由于这种关键的多样性,很难产生一种通用方法来获得高效的DNN,并在不同的应用程序中具有令人满意的性能。

本文通过一个简单而直观而有效的概念,解决了不同领域的深度神经网络高效设计的挑战:深度神经网络本身是为不同的学习目标定制的,提高其效率的方法也应该是定制的。有了这个概念,本文提出设计高效CNN、GANs和RNN的方法。本文首先提出了一种CNN压缩算法——类判别压缩(CDC),与CNN的类判别训练目标无缝契合,并在不损失精度的情况下为ImageNet上的ResNet50提供了1.8倍的加速。对CNN压缩的通道剪枝进行了深入研究。在分类精度目标的驱动下,本文提出一种进化框架,以自动发现优于手动设计的可迁移剪枝函数。本文进一步研究了GAN图像合成的另一种应用。GAN被训练成合成真实的内容,从而提出了一种内容感知的GAN压缩方法,将最先进的模型加速了11倍,而图像质量损失可以忽略不计。最后,我们将研究扩展到系统设计领域,我们的目标是通过构建高效的RNN数据预取器来缓解内存墙。本文提出一种多架构协同设计策略,将最先进的神经预取器速度提高15倍,性能甚至更好。