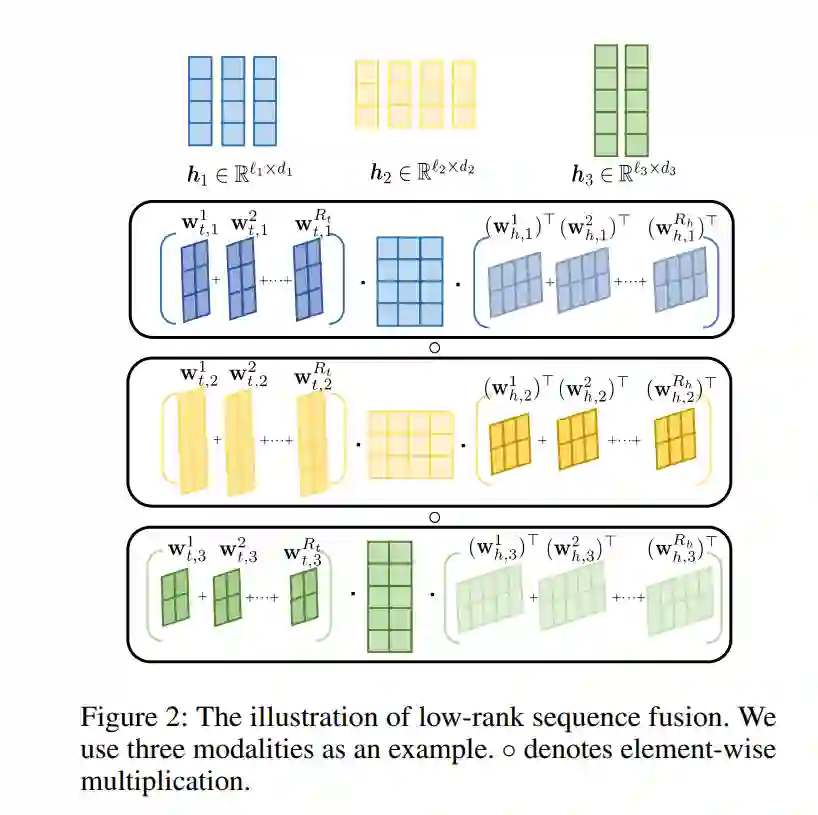

高效的迁移学习方法,如基于适配器的方法,已在单模态模型和视觉-语言模型中取得了巨大成功。然而,现有方法在微调多模态模型时面临两个主要挑战。首先,这些方法是为视觉-语言任务设计的,难以扩展到涉及多于两种模态的情况。其次,它们在模态间交互的利用上有限,且缺乏高效性。为了解决这些问题,本文提出了低秩序列多模态适配器(Wander)。我们首先通过外积有效地以逐元素方式融合来自不同模态的信息。为了提高效率,我们采用CP分解将张量分解为秩为一的组件,从而实现大幅度的参数减少。此外,我们还实现了一个基于令牌的低秩分解,用于提取更精细的特征和模态之间的序列关系。通过这些设计,Wander以参数高效的方式实现了不同模态序列之间的令牌级交互。

我们在不同模态数目的数据集上进行了广泛实验,结果表明,Wander consistently 优于现有的高效迁移学习方法。实验结果充分证明了Wander的有效性、效率和普适性。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日