据连线杂志报导,曾参与 OpenAI o3 和深度研究模型工作的研究员 Jason Wei 将加入 Meta 的超级智能实验室,他曾在Google Brain担任研究科学家,期间的工作为他赢得了广泛的认可。随后,他加入了OpenAI,继续在AI前沿领域深耕。他的学术背景扎实,研究兴趣广泛,尤其在自然语言处理(NLP)和大型语言模型方面取得了突破性进展。 作为一位在OpenAI和Google Brain都留下深刻印记的AI研究员,他的工作不仅推动了大型语言模型(LLMs)的边界,更在多个关键领域产生了深远的影响。

**Jason Wei的核心研究成果 **

Jason Wei的研究成果涵盖了大型语言模型的多个关键方面,其中最为人称道的包括:

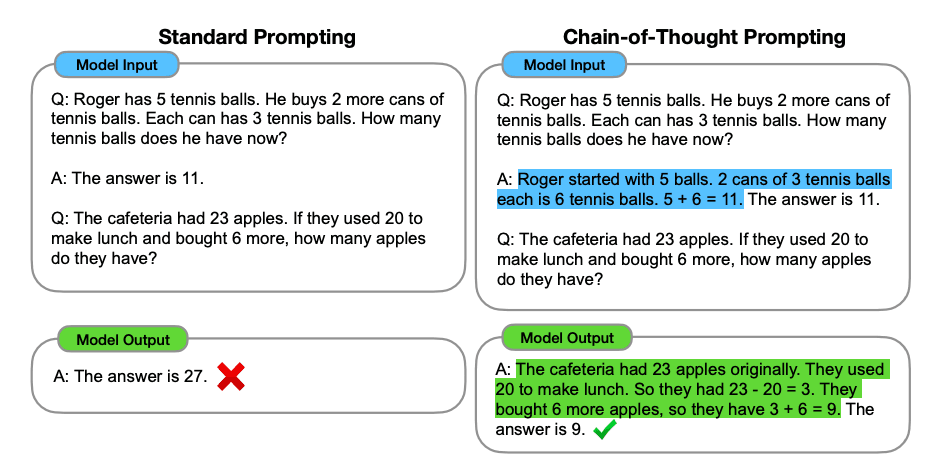

1. 思维链(Chain-of-Thought)提示

Jason Wei是“思维链提示”(Chain-of-Thought Prompting)的关键推动者之一。这项技术通过引导大型语言模型逐步思考,将复杂问题分解为中间步骤,从而显著提升了模型在复杂推理任务上的表现。例如,在数学应用题、符号推理和常识推理等任务中,思维链提示使得模型能够展现出更强的逻辑性和准确性。这项工作揭示了LLMs在处理多步骤推理时的潜力,为开发更智能、更可靠的AI系统提供了新的范式。

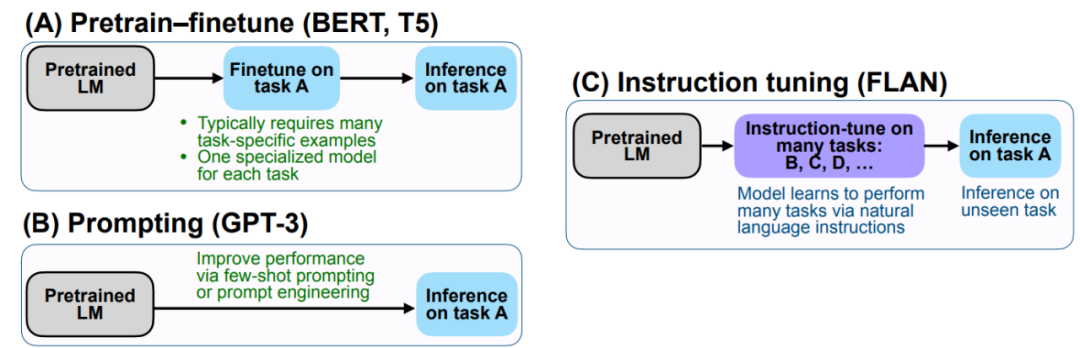

2. 指令微调(Instruction Tuning)

指令微调是另一项由Jason Wei及其团队普及的关键技术。通过对模型进行指令微调,使其能够更好地理解和遵循人类指令,从而在各种下游任务中表现出更强的泛化能力。这项技术使得LLMs能够更灵活地适应不同的应用场景,极大地提升了模型的可用性和实用性。它让大型语言模型从“知识库”转变为“智能助手”,能够根据用户的具体需求提供定制化的服务。

3. 大型语言模型的涌现能力(Emergent Abilities)

Jason Wei在“大型语言模型的涌现能力”研究方面也做出了重要贡献。他深入探讨了随着模型规模的增大,LLMs如何展现出在小规模模型中不曾出现的全新能力。这些涌现能力包括但不限于多步推理、复杂指令遵循和零样本学习等。这项研究不仅加深了我们对LLMs工作原理的理解,也为未来AI系统的发展指明了方向,即通过扩大模型规模来解锁更高级的智能。

4. 零样本学习(Zero-shot Learning)

Jason Wei的研究还强调了经过微调的语言模型在零样本学习方面的强大能力。这意味着模型在没有见过特定任务的训练数据的情况下,也能够通过理解任务指令来完成任务。这极大地减少了对大量标注数据的依赖,使得AI系统能够更快地适应新环境和新任务,加速了AI技术的普及和应用。

5. 数据增强技术

在早期工作中,Jason Wei也关注了文本分类任务中的数据增强技术。他提出了一些简单而有效的数据增强方法,旨在提升模型在数据稀缺情况下的性能。这项工作对于推动NLP领域在有限数据条件下的发展具有重要意义。**02 **

研究影响

Jason Wei的研究成果对当前AI领域产生了多方面、深远的影响:

1. 推动了大型语言模型的发展与应用

他的工作直接推动了大型语言模型从理论研究走向实际应用。思维链提示和指令微调等技术,使得LLMs在处理复杂任务和遵循人类指令方面取得了显著进步,为ChatGPT、Bard等生成式AI产品的成功奠定了基础。这些技术让LLMs不再是简单的文本生成器,而是能够进行复杂推理和交互的智能实体。

2. 改变了AI研究范式

Jason Wei对涌现能力的研究,改变了AI研究者对模型规模和能力之间关系的认知。它促使研究者们更加关注大型模型的潜力,并探索如何通过扩大规模来解锁更高级的智能。这种“规模化带来能力”的范式,成为了当前AI领域的主流研究方向之一。

3. 提升了AI系统的可用性和泛化能力

零样本学习和指令微调等技术,极大地提升了AI系统的可用性和泛化能力。开发者可以更便捷地将LLMs应用于各种场景,而无需为每个新任务都收集和标注大量数据。这加速了AI技术在各行各业的落地,降低了AI应用的门槛。 Jason Wei 换了工位,但做的事没变:继续把“让模型更会想”往前挪一小步。接下来无非是新的算力、新的数据、新的实验记录。结果好坏,要等他在 Meta 的下一篇技术报告。 本文参考:https://www.jasonwei.net/

点个在看你最好看 SPRING HAS ARRIVED