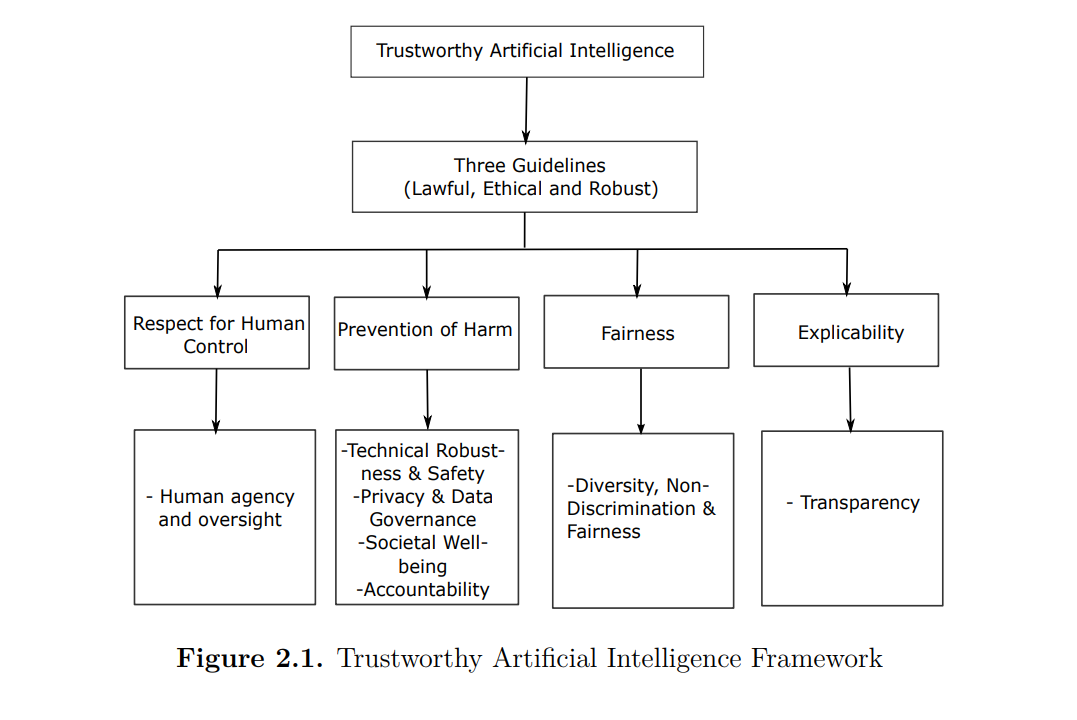

在人工智能(AI)的动态领域内,本研究探索了可信赖AI的多方面景观,专注于实现可解释性和接受度。研究讨论了AI发展的动态性,强调人类参与在塑造其轨迹中的重要角色。 这项工作的一个主要贡献是引入了一个新颖的“可信解释性接受度度量”(Trustworthy Explainability Acceptance Metric),为领域专家评估基于AI的系统量身定制。基于一种多功能的距离接受方法,该度量提供了一个可靠的接受值度量。特别是在医疗诊断等关键领域,展示了这一度量的实际应用。另一个重大贡献是提出了一个基于信任的5G社交网络安全框架。该框架通过整合社区洞察和利用信任机制,增强了安全性和可靠性,为社交网络安全提供了宝贵的进步。

研究还引入了一个人工良心控制模块模型,创新性地提出了“人工感觉”的概念。该模型旨在基于用户偏好提高AI系统的适应性,确保AI决策的可控性、安全性、可靠性和信任性。这一创新有助于增加社会对AI技术的接受度。此外,研究进行了一项全面的综述,探讨了建立AI可信赖性的基础要求。这项综述强调了公平性、问责性、隐私性、接受性以及验证/验证,为理解和解决AI应用中的伦理考虑奠定了基础。研究以探索量子替代方案结束,为可信赖AI系统中的算法方法提供了新视角。这一探索扩大了AI研究的视野,推动了传统算法的边界。 总之,这项工作对可信赖AI的讨论做出了重要贡献,确保了人类与AI系统之间复杂相互作用中的可解释性和接受度。通过其多样化的贡献,研究为各种应用中AI的负责任和伦理部署提供了宝贵的见解和实用框架。

成为VIP会员查看完整内容

相关内容

Arxiv

223+阅读 · 2023年4月7日