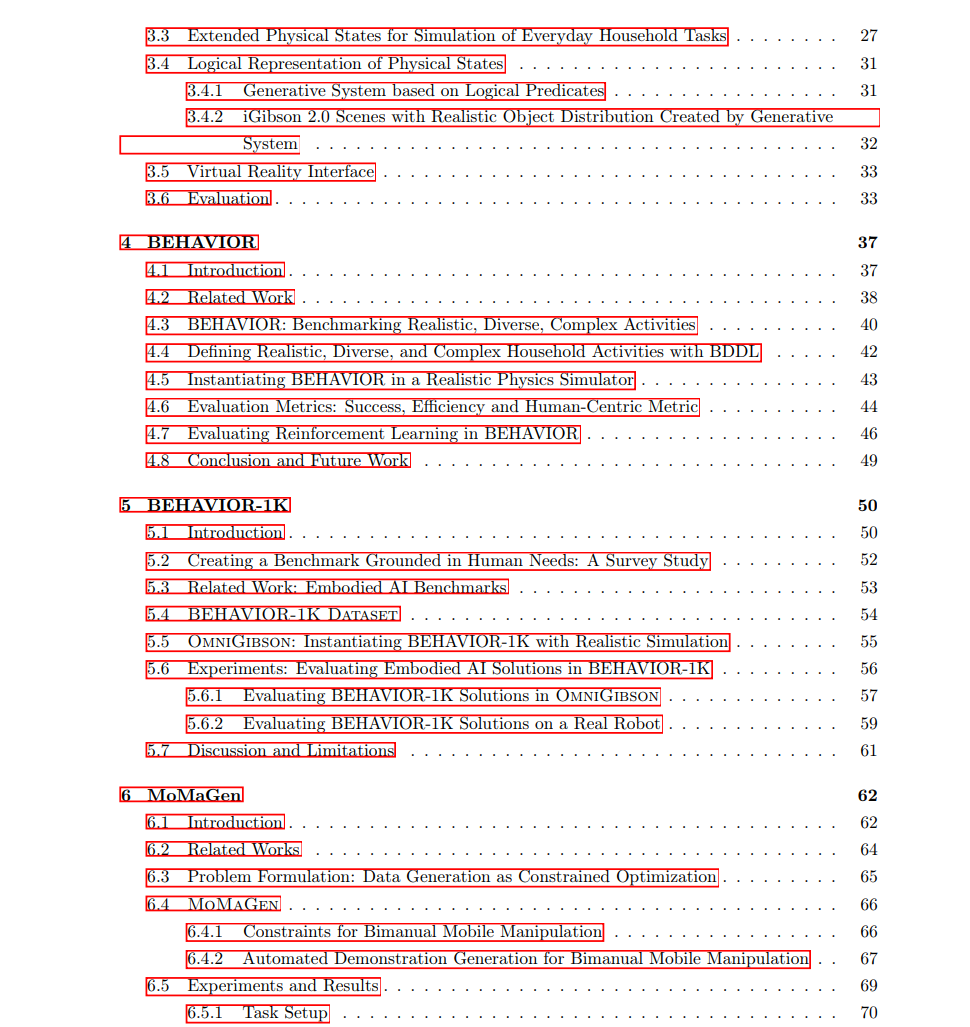

本论文围绕实现通用具身智能体的目标,探讨了两个关键研究方向:其一是开发逼真且大规模的基准测试与环境,其二是设计学习框架——尤其是动作空间表示——以支持长时序移动操作任务中的高效策略学习。 第一项工作建立了一个用于基准测试与智能体训练的闭环生态系统。从 iGibson 1.0 和 2.0 开始,我们开发了可支持复杂物体交互的物理交互式三维仿真平台,模拟真实的家庭环境。在此基础上,我们提出了 BEHAVIOR 和 BEHAVIOR-1K 基准测试,分别涵盖 100 和 1000 项日常家庭活动。这些任务基于人类时间使用数据构建,使用灵活的基于逻辑的语言进行定义,并辅以人类虚拟现实演示。为实现可扩展的数据驱动策略训练,我们提出了 MoMaGen,这是一种示范生成方法,可基于单一人类演示合成数千条多样化的轨迹。 第二项工作探讨了动作空间设计作为归纳偏置在解决长时序机器人任务中的作用。我们首先提出 HRL4IN,这是一种分层强化学习方法,通过高层末端执行器目标对交互式导航进行分解。随后我们引入 ReLMoGen,这是一种混合方法,在空间目标空间中进行高层探索,并结合低层运动生成以实现高效执行。最后,Chain of Code 利用大型语言模型(LLMs)生成可执行代码与伪代码,使智能体能够将算法推理与常识推理相结合以完成任务。 综上所述,这些研究工作共同推进了构建具备物理能力、语义理解能力以及对人类对齐的具身智能体的目标。

成为VIP会员查看完整内容

相关内容

Arxiv

40+阅读 · 2023年4月19日

Arxiv

212+阅读 · 2023年4月7日

Arxiv

79+阅读 · 2023年4月4日

Arxiv

144+阅读 · 2023年3月29日