构建能够推理、适应并与环境互动的智能自主系统一直是人工智能的长期目标。

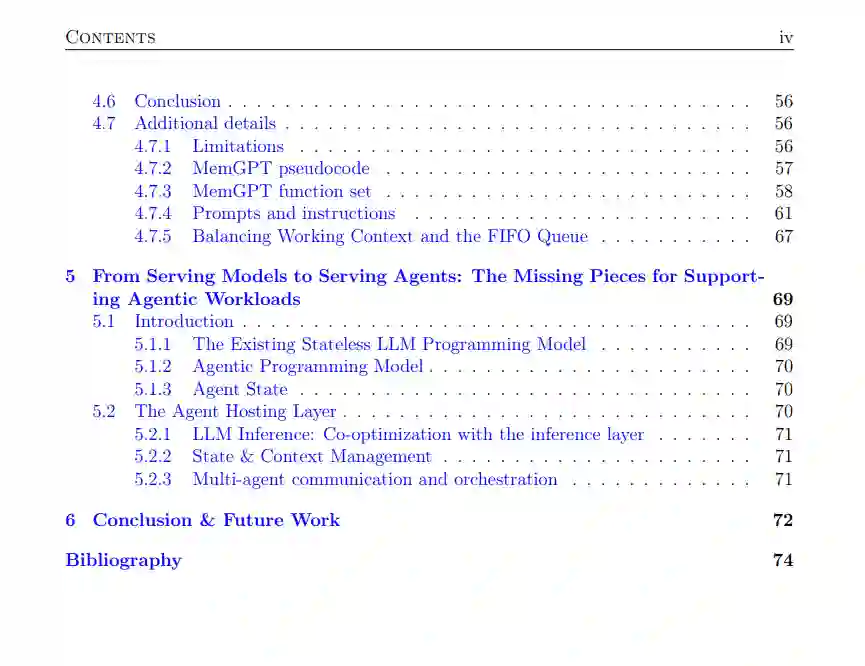

本文探讨了通过深度学习革命,代理系统(agentic systems)的演变,从强化学习到现代大规模语言模型(LLMs),重点关注构建可靠自主智能体所需的关键组件。 首先,我们解决了深度强化学习(RL)中的普适性(generalization)这一根本挑战,提出了一种系统框架,用于评估和改进学习策略在不同环境之间的迁移能力。以此为基础,我们提出了事后任务重标定(Hindsight Task Relabeling, HTR),这是一种创新方法,使得元强化学习算法能够在稀疏奖励设置中学习适应策略,而不需要在训练过程中依赖密集的奖励信号。 最后,我们讨论了利用大规模语言模型(LLMs)构建可靠智能体的最新挑战。尽管LLMs展示了前所未有的推理能力,但它们作为自主智能体的有效性受到其架构中的基本限制的制约——尤其是它们的无状态特性和固定的上下文窗口。为此,我们提出了MemGPT,一个受操作系统启发的框架,使得LLMs能够管理自己的记忆和状态,引入了虚拟上下文管理和自我导向的记忆操作等概念。MemGPT证明了,通过将LLMs视为一种新的计算基本单元——类似于CPU在传统操作系统中的角色——我们能够构建更可靠、更强大的自主智能体。 综上所述,这些系统追溯了代理AI系统的发展,并提供了创建更可靠、更强大自主智能体的关键构建块。通过解决普适性、适应性和记忆管理等核心挑战,本文为工程化下一代能够有效推理并与世界互动的AI系统奠定了基础。

成为VIP会员查看完整内容

相关内容

Arxiv

86+阅读 · 2023年4月4日

Arxiv

153+阅读 · 2023年3月29日