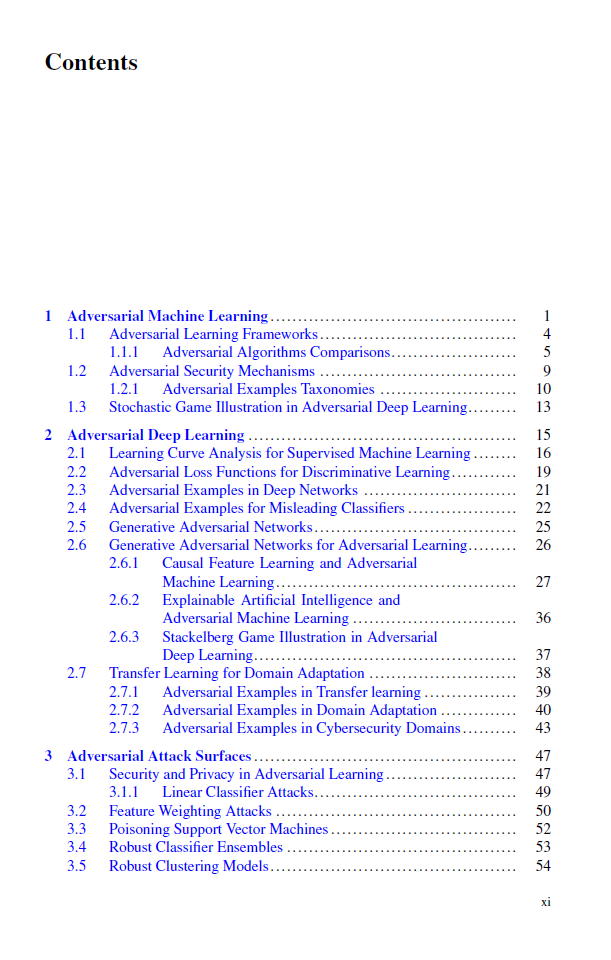

深度学习面临的一个关键挑战是深度学习网络容易受到智能网络对手的安全攻击。即使对训练数据进行无害的扰动,也可以用来以意想不到的方式操纵深度网络的行为。在本书中,我们回顾了计算机视觉中对抗性攻击技术的最新发展;自然语言处理;以及多维、文本和图像数据、序列数据和时间数据的网络安全。评估了深度学习网络的鲁棒性,以产生对抗性样本的分类,刻画了使用博弈论对抗性深度学习算法学习系统的安全性。对基于对抗扰动的隐私保护机制的研究现状进行了综述。

本文为非平稳计算学习环境中的博弈论目标提出了新的对手类型。在我们研究的决策问题中,对假设集的适当量化会导致各种函数问题、预言问题、采样任务和优化问题。还解决了目前部署在现实世界环境中的深度学习模型可用的防御机制。这些防御机制中使用的学习理论涉及对抗性深度学习算法及其应用的数据表示、特征操作、错误分类代价、敏感性景观、分布鲁棒性和复杂性类。

最后,提出了面向弹性学习系统设计的对抗深度学习应用的未来研究方向,并回顾了针对人工智能应用的攻击面和鲁棒性的形式化学习假设,以解构当代对抗深度学习设计。鉴于其范围,本书将对对抗性机器学习从业者和对抗性人工智能研究人员感兴趣,他们的工作涉及对抗性深度学习的设计和应用。 https://link.springer.com/book/10.1007/978-3-030-99772-4

成为VIP会员查看完整内容