本PPT探讨了基于扩散模型和流模型的推理时引导生成技术,旨在通过动态调整生成过程,提升生成内容与用户偏好的对齐能力。主要内容包括以下三个方面: 1. 扩散模型与流模型的背景与优势

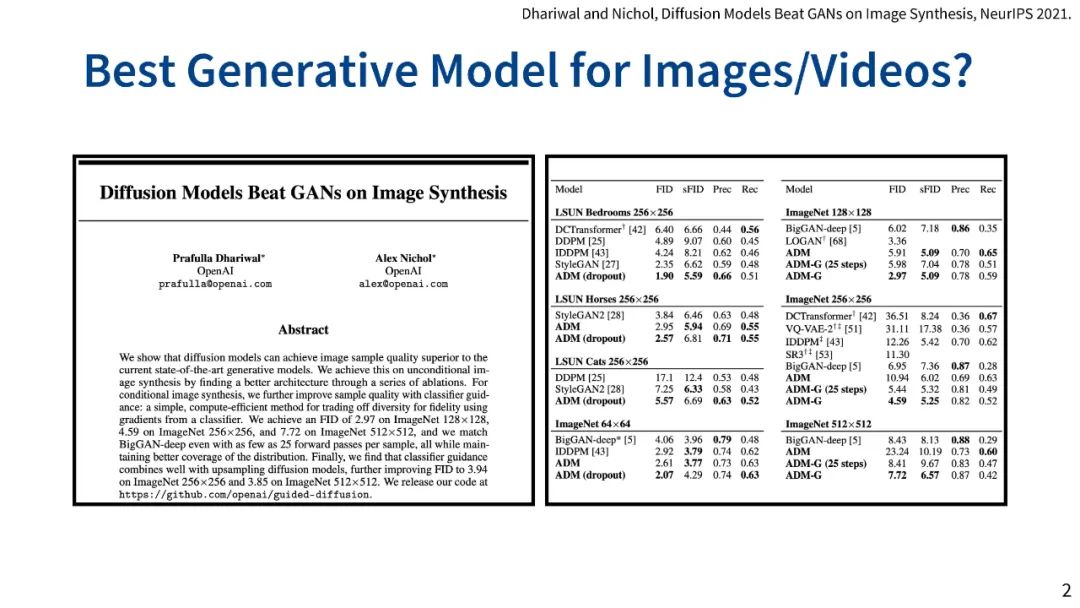

扩散模型通过逐步去噪生成高质量样本,在图像/视频合成中表现优异,但生成速度较慢。 * 流模型通过确定性轨迹实现快速生成(如Stable Diffusion 3、FLUX),但缺乏随机性限制了其灵活性。 1. 推理时引导生成的三大方法

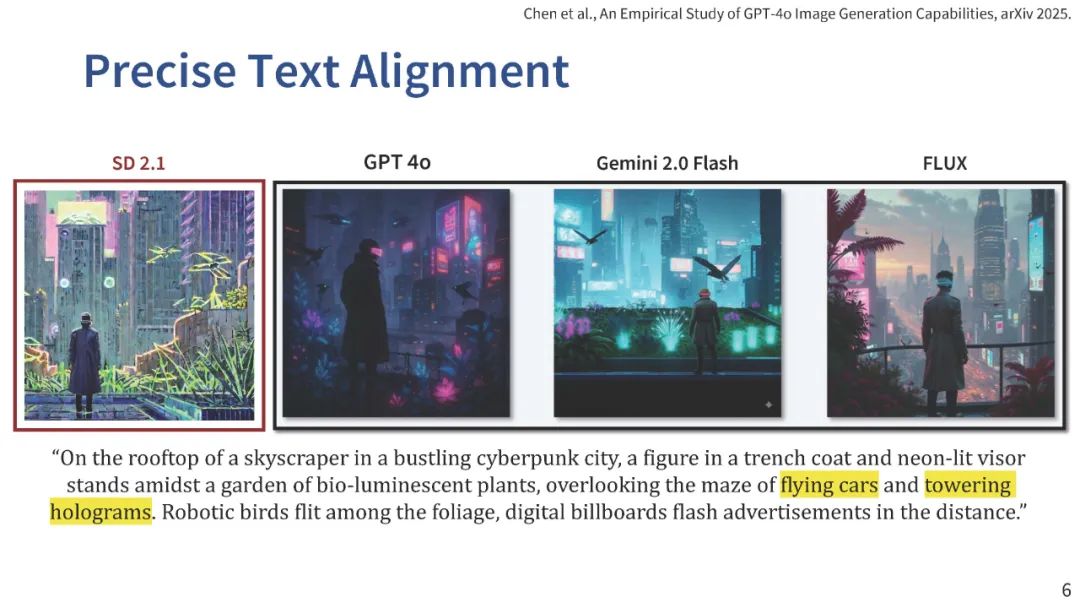

分数/注意力操纵:通过调整扩散模型中的分数或注意力图实现空间引导(如GroundIT的2D布局控制、VideoHandles的3D视频编辑)。 * 基于未来奖励的梯度上升:利用可微奖励函数(如风格一致性、逆向问题求解)优化生成过程(如DPS方法)。 * 粒子采样:通过多粒子搜索处理不可微奖励(如对象计数、文本对齐),适用于流模型时需引入随机性(ODE转SDE)。 1. 关键技术与应用

流模型的推理时扩展:通过插值系数调整和ODE-to-SDE转换,实现粒子采样(如文本对齐、美学生成)。 * 一步式模型的迭代引导:结合朗之万动力学,在隐空间优化生成内容(如ORIGEN的方向控制)。 * 跨领域同步生成:在全景图、3D纹理等任务中同步多生成过程(如SyncTweedies的网格纹理生成)。

未来方向包括探索视觉自回归模型(VAR)与扩散/流模型的混合架构,以平衡生成速度与多模态对齐能力。 核心贡献:提出无需微调的推理时引导框架,扩展了生成模型在复杂任务(如空间 grounding、3D 编辑)中的应用,同时兼容扩散模型和流模型。

成为VIP会员查看完整内容

相关内容

Arxiv

38+阅读 · 2023年4月19日

Arxiv

79+阅读 · 2023年4月4日

Arxiv

140+阅读 · 2023年3月29日