https://link.springer.com/book/10.1007/978-1-4842-8844-3

使用hugs Face库获得关于Transformer体系结构的实际介绍。本书解释了transformer如何改变人工智能领域,特别是自然语言处理领域。

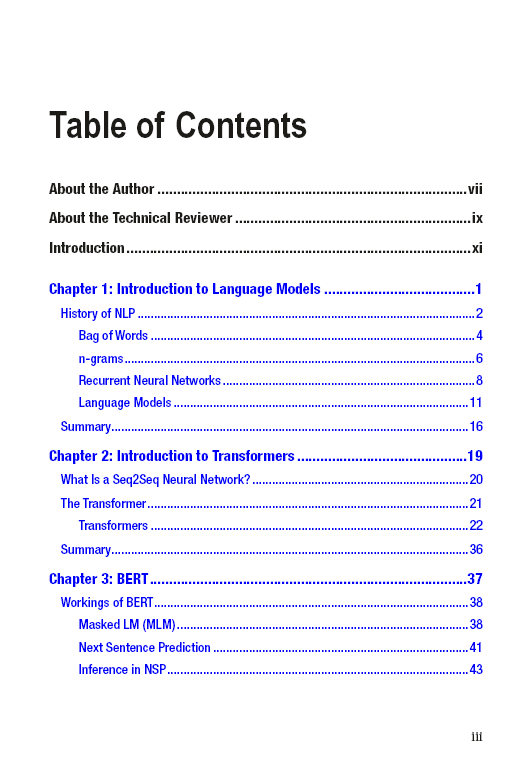

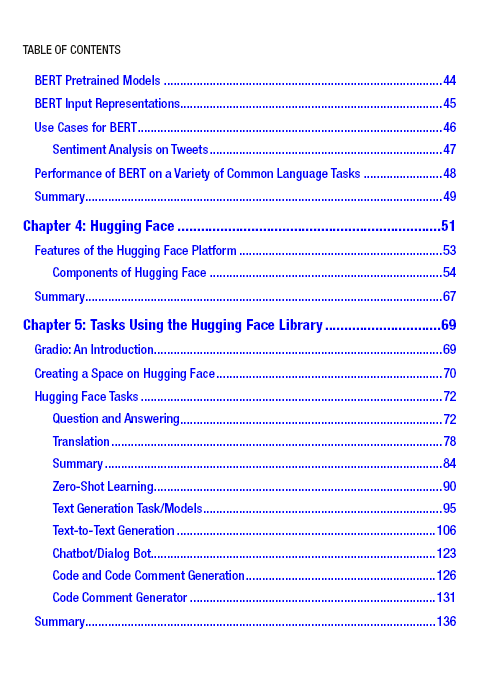

本书涵盖了Transformer体系结构及其在自然语言处理(NLP)中的相关性。它首先介绍NLP和从n-grams到基于transformer的体系结构的语言模型的进展。接下来,它提供了一些使用谷歌colab引擎的基本转换器示例。然后,介绍了hug Face生态系统及其提供的不同库和模型。接下来,本文通过一些示例解释了诸如谷歌BERT之类的语言模型,然后深入介绍了hug Face API,使用不同的语言模型来处理诸如句子分类、情感分析、摘要和文本生成等任务。

在完成《NLP Transformer入门》之后,您将理解Transformer的概念,并能够使用huggingface库解决问题。

你会:

理解语言模型及其在NLP和NLU(自然语言理解)中的重要性 * 通过实际示例掌握Transformer体系结构 * 在基于transformer的语言模型中使用hug Face库 * 基于Transformer架构在Python中创建一个简单的代码生成器

成为VIP会员查看完整内容

相关内容

专知会员服务

471+阅读 · 2022年4月21日

Arxiv

0+阅读 · 2022年12月21日