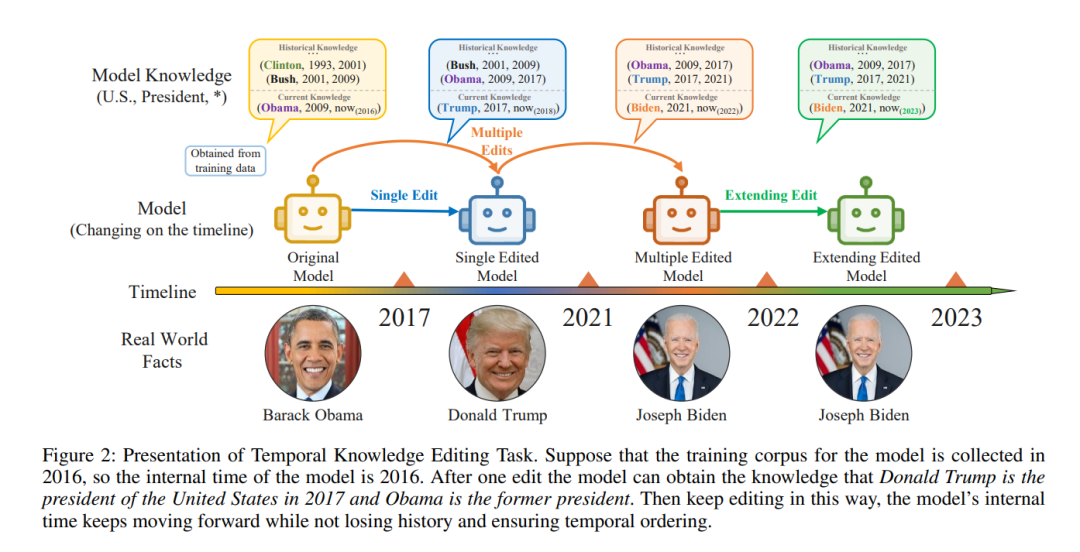

修订或更新大型语言模型中存储的知识的紧迫任务源自两个不同的来源:模型中固有的应该被纠正的内在错误和由于现实世界外部变化导致的过时知识应该被更新。在模型编辑方面的主要努力将这两类不同原因产生的编辑混为一谈,直接将模型中的原始知识修改为新知识。然而,我们认为保留模型的原始知识仍然是重要的。特别是,如果模型的知识因为世界动态的发展而过时,它应该在整合新发现的知识的同时保留对历史知识的记忆。在这项工作中,我们介绍了时序知识编辑(Temporal Knowledge Editing,TKE)的任务,并建立了一个评估当前模型编辑方法的基准——时序知识编辑评估(Assessment of TempOral Knowledge Editing,ATOKE)。我们发现,尽管现有的模型编辑方法在使模型记住新知识方面有效,但编辑过的模型却灾难性地忘记了历史知识。为了解决这一差距,我们提出了一个简单且通用的框架,名为时序目标多编辑(Multi-Editing with Time Objective,METO),用于增强现有的编辑模型,该框架同时编辑历史和新知识,并优化模型对每个事实时间的预测。我们的评估表明,虽然ATOKE仍然困难,但METO在学习新知识的有效性方面保持不变,同时显著提高了编辑模型在利用历史知识方面的性能。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日