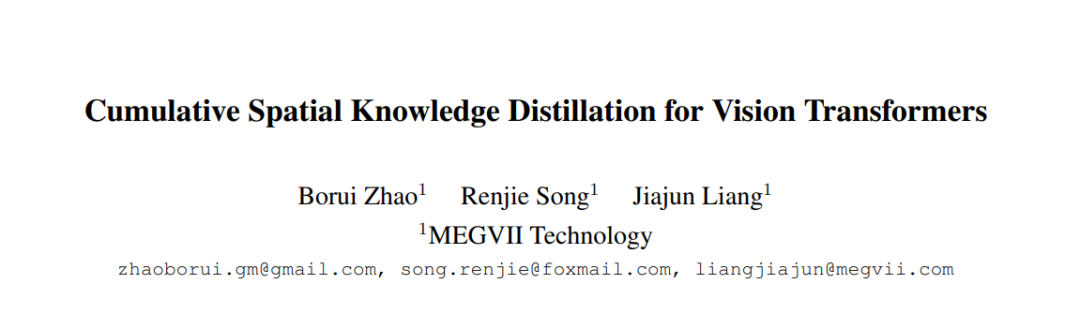

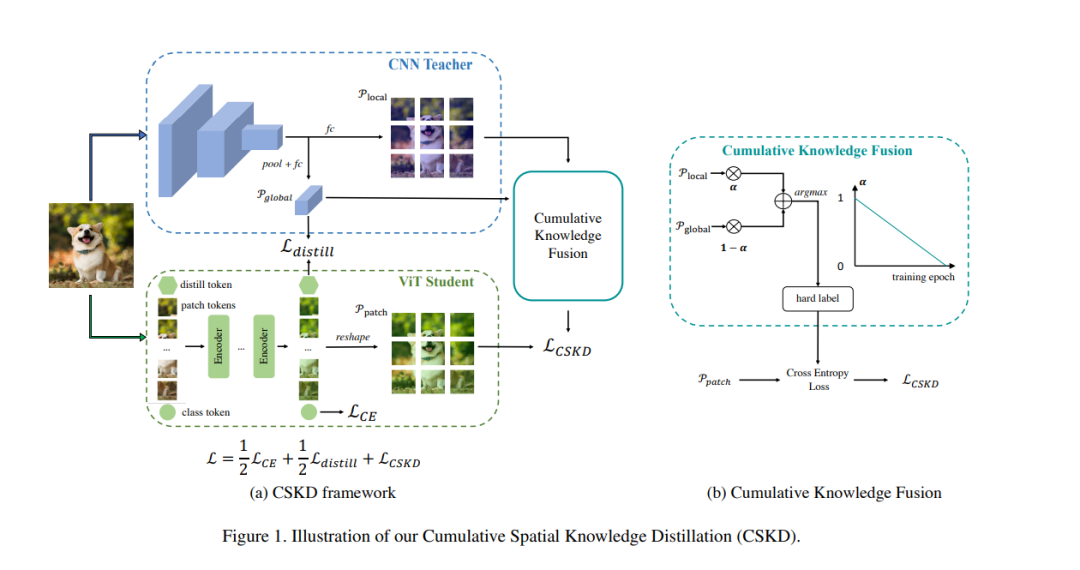

“累积空间知识蒸馏”(Cumulative Spatial Knowledge Distillation,CSKD)是一个深度学习中针对视觉变换器(ViTs)进行知识蒸馏的方法。CSKD的设计目标是解决从卷积神经网络(CNNs)中提取知识时所遇到的两大问题:(1) CNN和ViT网络设计完全不同,导致中间特征的语义级别不同,使得基于空间的知识传递方法(例如,特征模拟)效率低下;(2) 从CNN中提取知识会限制ViT在后期训练中的网络收敛,因为CNN的局部归纳偏见监督抑制了ViT整合全局信息的能力。 CSKD方法从CNN对应的空间响应中提取基于空间的知识,然后将其蒸馏到ViT的所有补丁令牌,而无需引入中间特征。此外,CSKD利用了累积知识融合(CKF)模块,该模块引入了CNN的全局响应,并在训练过程中逐渐强调其重要性。应用CKF在早期训练期间利用了CNN的局部归纳偏见,而在后期充分发挥了ViT的全局能力。在ImageNet-1k和下游数据集上的大量实验和分析证明了我们的CSKD方法的优越性。代码将公开发布。

成为VIP会员查看完整内容