在传统由人类主导的决策领域,人工智能(AI)正逐步接管多项任务。对此,与AI系统交互的人类决策者可能难以对AI生成信息建立信任。当前决策被概念化为证据积累的建构过程,但此过程可能因交互设计差异呈现不同演化路径。本研究旨在探究通过对AI建议进行中间判断时信任的时间演化特征。在线实验(N=192)发现信任随时间呈现波动,且对AI建议的中间判断具有信任强化效应。此外,研究发现参与者行为违背全概率定律,现有建模技术无法捕捉此类现象。因此,采用量子开放系统建模方法(将信任表示为单一概率分布的时间函数)相比传统马尔可夫方法,能更优地模拟对AI系统的信任演化。研究成果可优化AI系统行为,引导人类决策者趋向贝叶斯最优理性(在复杂任务环境的时效性决策中尤为重要)。

美国政府内外研究表明,AI信任是复杂概念,但美国防部(DOD)仍将其视为人本AI设计的核心认知过程。AI技术持续发展,在指挥控制(C2)等复杂环境中扩展能力。除功能增强外,AI可主动改变决策空间并实施信息干预(Strich等,2021年)。预测显示人类将日益依赖AI输出进行决策(Fuchs等,2023年)。

理解AI技术如何影响人类决策具有必要性。军事机构正经历AI驱动的技术与组织变革(Wrzosek,2022年)。多起先进技术事故揭示了自动化系统的潜在危害:伊拉克爱国者导弹误击事件(Hawley & Mares,2012年)、文森斯号击落客机事件(Bisantz等,2000年;Hestad,2001年;Marsh & Dibben,2003年)、美军黑鹰直升机误击事件(Snook,2011年),以及近期阿富汗平民误杀事件(Denning & Arquilla,2022年),均表明误解自动化系统信息的灾难性后果。这些悲剧的共同点在于自动化技术对人类决策的影响。更令人担忧的是,人类决策正被机器决策周期主导而非系统辅助(Blair等,2021年)。因此,理解AI对人类决策的影响机制是改进人机交互研究的必经之路。

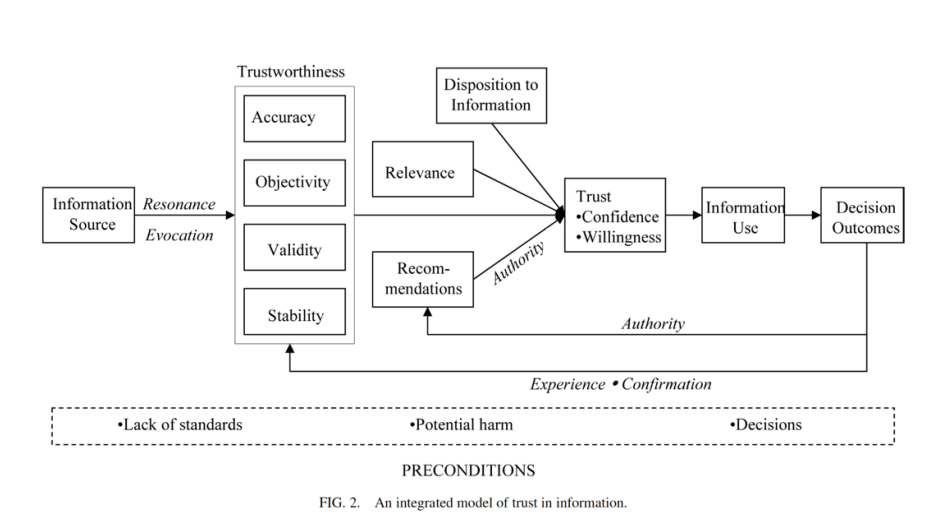

当前,决策过程普遍被概念化为证据积累的建构性过程。然而,该建构过程可能因交互设计的不同而呈现差异化的演化路径。本研究通过分析对AI建议的中间判断,探究信任随时间演变的特征。在线实验(N=192)发现:信任度随时间呈波动状态,且对AI建议进行判断会触发信任强化效应;参与者行为存在现行建模技术无法捕捉的全概率定律违背现象。尽管多种定量与定性方法已部分揭示AI信任及其与系统效能的关系,但结合信任时间演化特征的生成性理论可深化对此的全面理解。因此,采用开放系统建模方法(将信任表征为单一概率分布的时间函数),较传统马尔可夫方法与量子技术更能优化AI系统的信任建模。

马尔可夫动态与量子动态的相互作用为决策动态建模(尤其是人机协同决策)提供了新视角。若人类决策确遵循量子开放系统路径,开发更优的人机交互策略可能产生突破性成果(Snow等,2022年)。研究成果可优化AI系统行为,引导人类决策偏好趋向贝叶斯最优理性(在复杂任务环境的时效性决策中尤为重要)。尽管研究前景广阔,仍需深入探索技术细节并验证其普适性边界。

开发人在回路人工智能(HITL-AI)系统仍面临重大挑战。如何将人类融入AI增强的态势感知与决策(或反向整合),将呈现多样化形态。研究表明人机共享决策将持续存在(Blaha,2018年;van den Bosch & Bronkhorst,2018年),核心问题在于决策权的让渡边界及组织多重理性的协调机制。量子开放系统理论在HITL-AI设计中的应用,亦为重新评估既有研究开启新路径。

AI系统开发与应用始终涉及人类决策流程。任何形式的AI采用都将保留人类决策元素,但研究者与实践者需明确界定适宜委托机器智能的范畴(Floridi & Cowls,2019年)。需清醒认知:AI无法超越训练数据提供新功能(Kauffman & Roli,2022年),亦无法预判反事实结果(Pearl & Mackenzie,2018年)。此类局限不应阻碍AI提升决策的实践,但需将HITL-AI视为需联合优化的复杂社会技术系统(如构建结构理性决策框架)。因此,人类在HITL-AI系统中的角色响应机制将呈现多元化演进。应对这些挑战,需确保概念演进与技术进步同步,持续监控以保证决策的结构理性与多方利益攸关者的共赢。