随着社会技术化程度的不断提升,我们使用机器执行越来越复杂的任务,这些任务范围从驾驶辅助、视频会议到探索行星。场景表示,即如何将感官数据转换为环境的紧凑描述,是使这些系统成功并确保安全的基本属性。一个有前景的方法是开发基于学习的系统,这些系统能够根据观察自我调整。

事实上,近年来深度学习已经彻底改变了计算机视觉领域。特别是更好的模型架构、大量的训练数据以及更强大的计算设备使得深度学习系统具有前所未有的性能,并且它们现在在许多基准测试中设定了最新技术水平,这些测试范围从图像分类、物体检测到语义分割。尽管这些成功,这些系统的运作方式仍然与人类认知有本质上的不同。特别是,大多数方法在2D领域操作,而人类理解图像是三维世界的投影。此外,它们通常不遵循场景的组合理解,这对人类推理来说是基本的。在这篇论文中,我们的目标是开发场景表示,使自主代理能够在复杂环境中稳定、安全地导航和行动,同时在3D中进行组合推理。为此,我们首先提出了一种用于基于深度学习的三维重建和生成建模的新型输出表示。

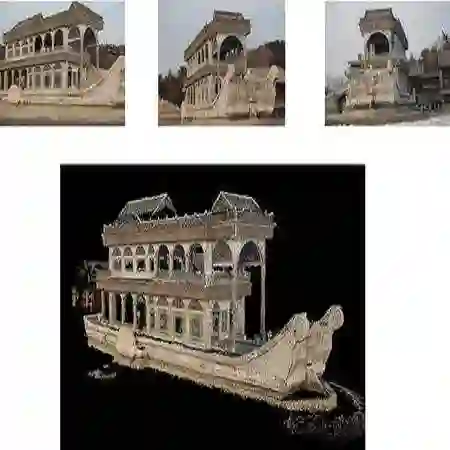

我们发现,与以前的表示方法相比,我们基于神经场的方法不需要对3D空间进行离散化,就可以以恒定的内存占用实现任意分辨率的重建。接下来,我们开发了一种可微渲染技术,用于从2D观察中推断出这些基于神经场的3D形状和纹理表示,并发现这使我们能够扩展到更复杂、现实世界的场景。随后,我们将我们的新型3D形状表示与空间和时间上连续的矢量场相结合,以模拟运动中的非刚性形状。我们观察到,我们的新型4D表示可用于各种判别和生成任务,范围从4D重建到4D插值,再到运动转移。最后,我们开发了一种以对象为中心的生成模型,该模型可以以组合方式生成3D场景,并且允许对生成的场景进行逼真的渲染。我们发现,我们的模型不仅提高了图像保真度,而且相比之前的工作,在仅从原始、未摆放的图像集合中训练的情况下,实现了更可控的场景生成和图像合成。