这篇评论针对人工智能系统提出了 "什么是好的解释 "的问题。报告概括了计算机科学努力创建解释和指导系统的历史,现代人工智能中的可解释问题和挑战,以及主要的解释心理学理论。对XAI系统进行评估的方法指导强调了全局和局部解释之间的差异,需要评估人机工作系统的性能,以及需要认识到实验程序默示地将自我解释的负担强加给用户。涉及人与人工智能互动和共同适应的任务,如错误或oddball检测,为XAI评估带来希望,因为它们也符合 "解释即探索"和解释即共同适应的对话过程的概念。涉及预测人工智能的决定的任务,结合实验后的访谈,为研究XAI背景下的心理模型带来了希望。

总结

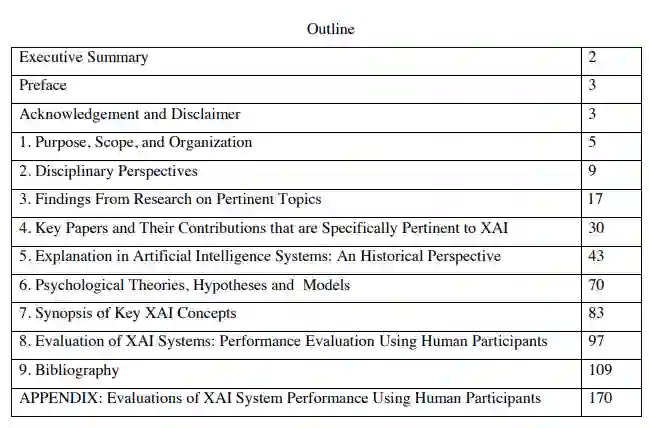

这是一篇综合评论,讨论了 "什么才是好的解释?"这个问题,并提到了人工智能系统。相关的文献资料非常多。因此,这篇评论必然是有选择性的。尽管如此,大部分的关键概念和问题都在本报告中有所阐述。该报告概括了计算机科学努力创建解释和指导系统(智能辅导系统和专家系统)的历史。报告表达了现代人工智能中的可解释性问题和挑战,并提出了解释的主要心理学理论的囊括观点。某些文章由于与XAI特别相关而脱颖而出,它们的方法、结果和关键点被强调。

建议鼓励AI/XAI研究人员在他们的研究报告中,以实验心理学研究报告的方式,更全面地介绍他们的经验或实验方法:关于参与者、指示、程序、任务、自变量(措施和度量的操作定义)、独立变量(条件)和控制条件的细节。

在本报告审查的论文中,人们可以找到评估XAI系统的方法论指导。但报告强调了一些值得注意的考虑。全局解释和局部解释之间的差异,需要评估人机工作系统的表现(而不仅仅是人工智能的表现或用户的表现),需要认识到实验程序默许了用户自我解释的负担。

纠正性/对比性用户任务支持自我解释或解释即探索。涉及人类与人工智能互动和共同适应的任务,如错误或oddball检测,为XAI评估带来了希望,因为它们也符合 "解释-探索 "和解释是共同适应的对话过程的概念。涉及预测人工智能的决定的任务,结合实验后的访谈,为研究XAI背景下的心理模型带来了希望。

序言

本报告是对之前关于DARPA XAI项目的报告的扩展,该报告的标题是 "可解释人工智能关键思想的文献回顾和整合",日期是2018年2月。这个新版本整合了已经发现的近200个额外的参考文献。本报告包括一个新的部分,题为 "对XAI系统的人类评价的审查"。这一节重点介绍了人机人工智能或XAI系统经历了某种实证评估的项目报告--其中许多是最近的。这个新部分与DARPA XAI项目的经验和实验活动特别相关。

本材料基于空军研究实验室(AFRL)根据协议号FA8650- 17-2-7711赞助的研究。美国政府被授权为政府目的复制和分发重印本,尽管上面有任何版权说明。