论文题目: Improving Generative Adversarial Networks via Adversarial Learning in Latent Space 作者信息: 郦洋(上海交通大学),莫易川(上海交通大学/北京大学),史良良(上海交通大学),严骏驰(上海交通大学) 论文链接: https://openreview.net/pdf?id=Magl9CSHB87 代码链接: https://github.com/yangco-le/AdvLatGAN

生成对抗网络(GAN)作为经典生成模型,一方面已在高维数据(尤其是图像)生成领域取得了巨大成功,另一方面,在扩散模型的冲击下,探索和挖掘GAN的优势以及如何更好控制生成过程、解决训练不稳定的挑战成为GAN研究中亟待解决的问题。当前在GAN领域的主流工作主要聚焦于目标函数设计、训练技巧、网络设计等方面[1-3],而作为影响生成的重要部分,人们对隐空间采样分布的研究更多地聚焦于特征解耦,因此如何通过隐空间编辑调整以更好把控和强化生成结果成为GAN研究中一个新的切入视角。 本文我们将介绍一项被NeurIPS'22会议接收的新工作,我们于该工作中提出了AdvLatGAN以通过基于对抗样本方法的隐空间编辑以更好控制生成过程和训练过程中的模型表现,该工作有幸入选今年NeurIPS的Spotlight展示(比例约5%)。 TAG: 生成对抗网络,隐空间,对抗学习

研究动机与背景

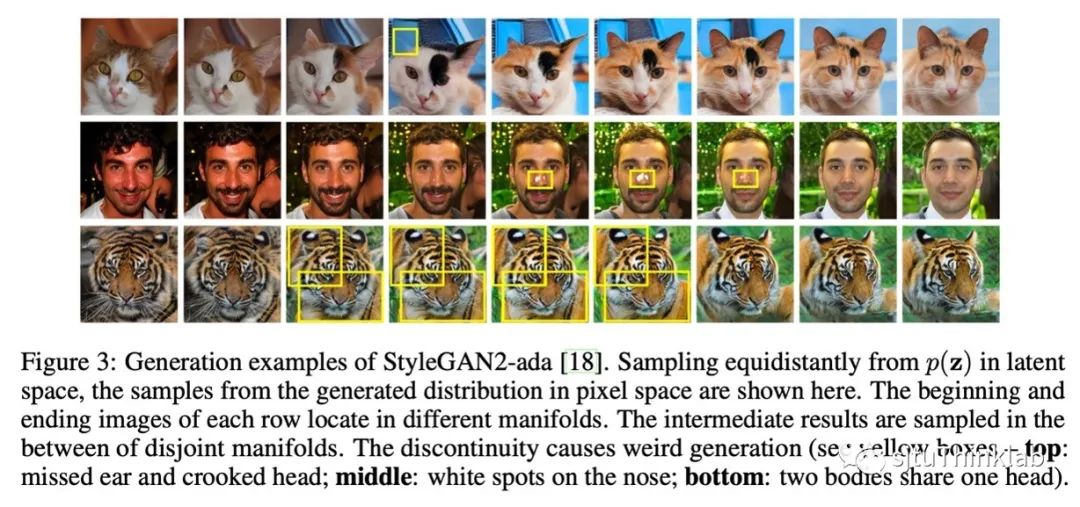

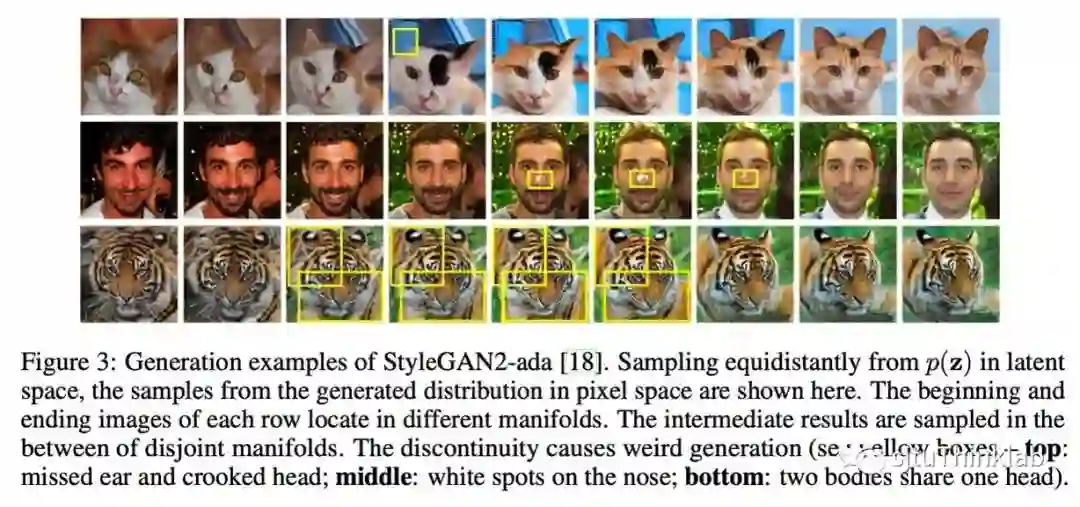

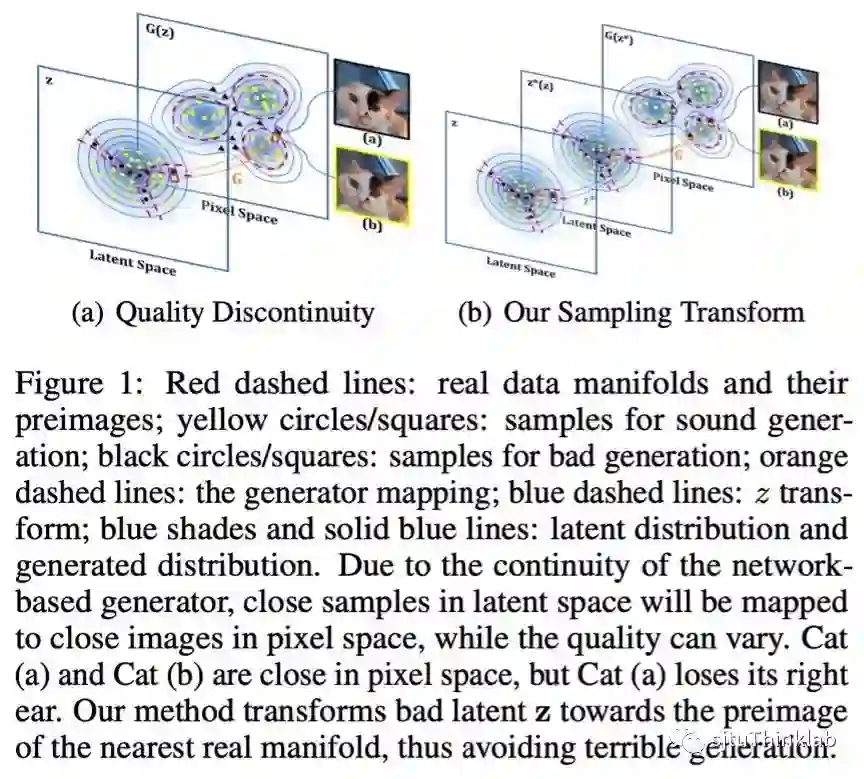

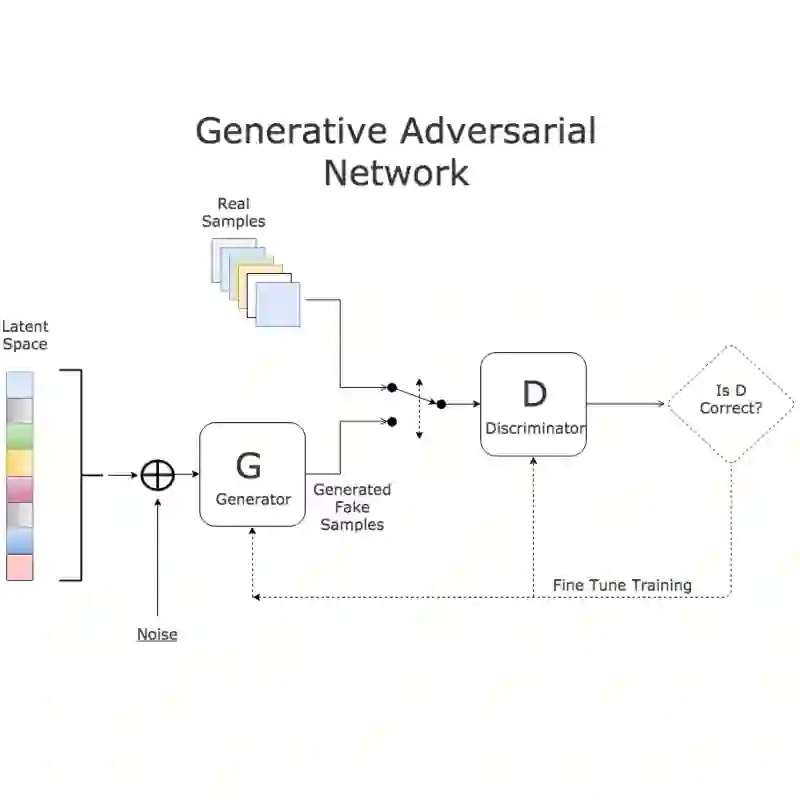

作为经典的生成范式之一,GAN使用经过生成器网络映射后的高斯分布来拟合真实数据分布。然而,由于生成器作为神经网络本质上是一个连续映射,连续隐空间分布经过生成器映射得到的生成数据分布也将是连续的,而自然图像分布支撑在多个不连接的流形上[4],这使得生成数据分布难以与真实数据分布保持一致,这也对应着生成场景下采样空间往往包含一些invalid generation的现象。如下图所示,在隐空间中等距采样,采样跨越不同不连接流形时,生成结果将不可避免地包含invalid generation。

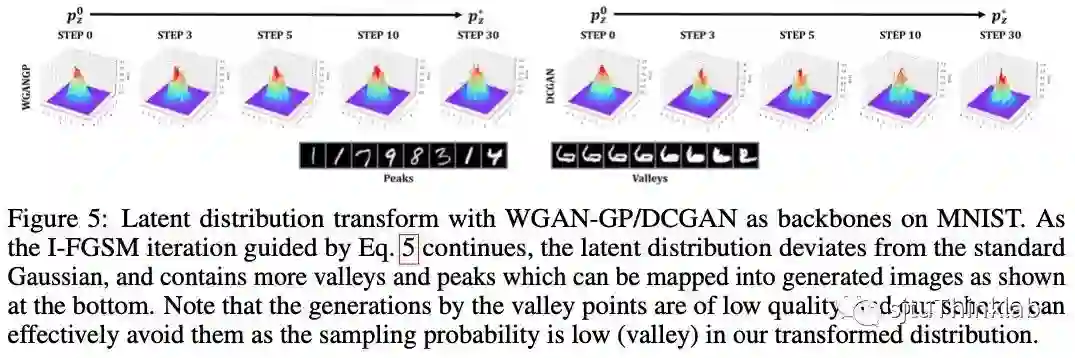

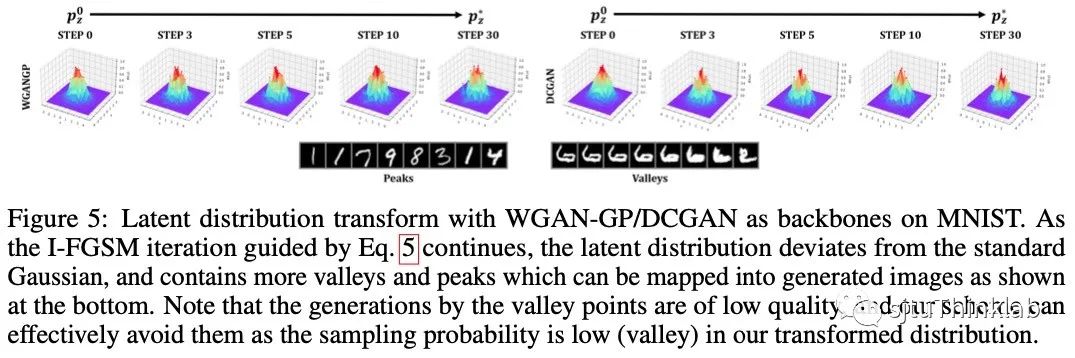

本文指出,现有GAN模型在生成过程(测试过程)和模型训练过程中使用的隐空间分布存在可优化的空间,继而提出对原始隐空间分布施加采样变换以优化该分布。在图像生成场景下,在隐变量上的扰动将造成生成图像上的细节差异,然而图像上的细节差异即可造成生成上的失真,因此我们希望通过对隐变量施加扰动来获取生成质量(实现上量化为判别器网络输出)的显著提升。鉴于任务的相似性,这一采样变换在实现上通过对抗样本方法完成,具体而言,我们通过对隐变量采用I-FGSM方法[5]进行迭代以最小化生成器损失即。将特定的隐空间变换引入GAN训练过程中将缓解训练困难以提升生成器映射的质量,而在生成过程中引入隐空间采样变换能够直接提升采样质量以获得更真实的生成。

方法介绍

AdvLatGAN-z:隐空间采样变换

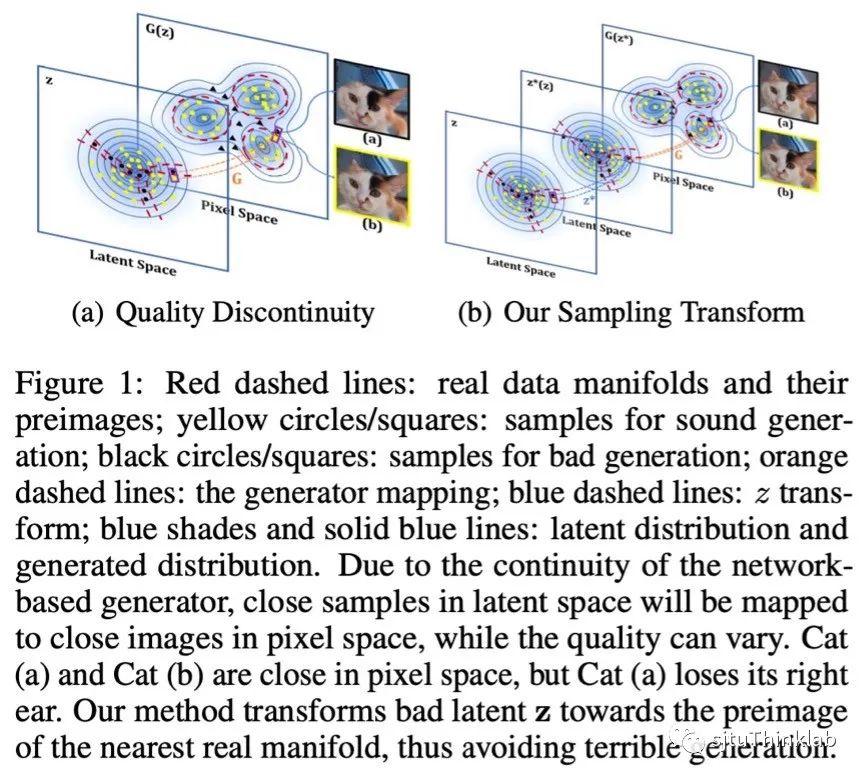

本文提出对隐空间上施加隐式采样变换,示意图如下。我们希望通过采样变换使得对应于真实图像流形外的采样(即invalid generation)可被迭代优化到有效的采样空间中。

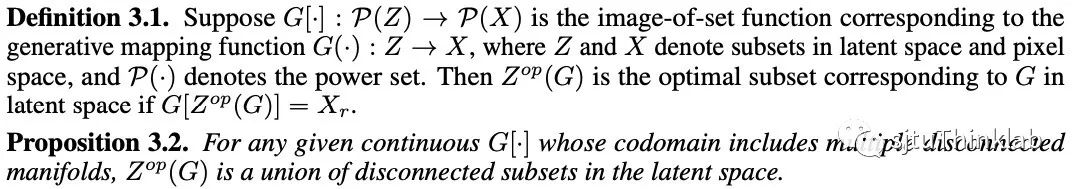

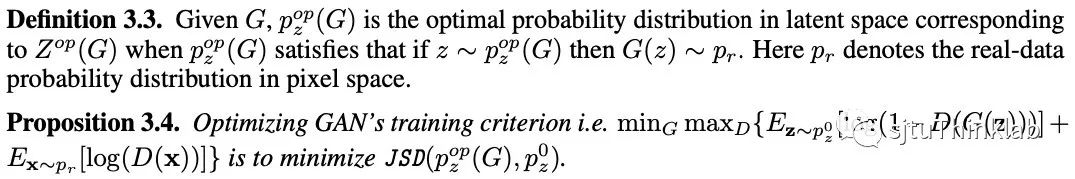

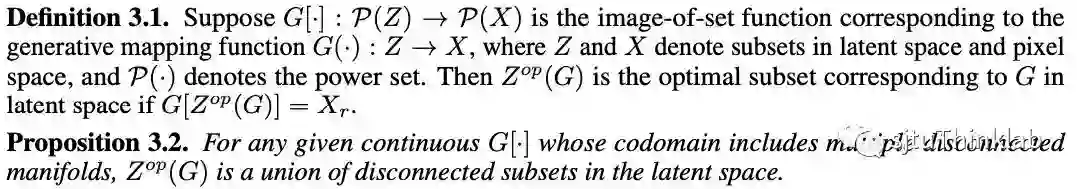

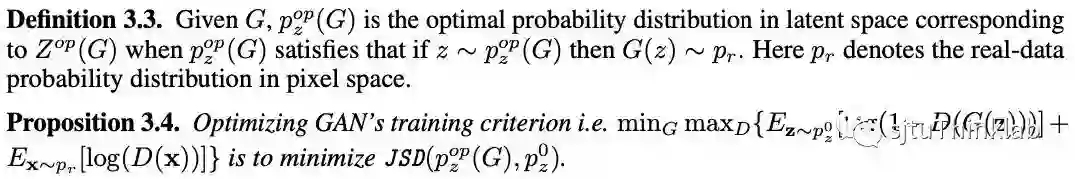

本文首先给出特定生成映射G下对应于真实数据分布的最优隐空间的定义,并说明拟合真实数据流形需要一个不连通的隐空间支撑。

其次给出隐空间采样变换的具体方法。在GAN算法中判别器被训练以区分生成分布和真实分布,因此其输出可被自然地选以量化生成质量。考虑隐空间采样变换的目标,即通过隐变量上的扰动以造成判别器网络输出的显著变化,我们自然地求诸对抗样本方法来实现采样变换。具体而言,我们在固定生成器和判别器参数条件下采用I-FGSM方法更新隐变量来最小化生成器损失,优化目标如下: 其中为原始隐变量,为变换后的隐变量,表示距离度量,在本文中具体为。 最后我们定义对应于的最优隐空间分布并说明GAN的优化目标可以等价为最小化和初始隐空间分布间的JS散度。从而说明,在扰动范畴内,固定网络参数时对隐空间分布进行GAN损失指导下的采样优化将使隐空间分布趋近最优分布。

AdvLatGAN-qua:生成质量为目标的GAN训练算法

GAN存在训练不稳定的问题,其中一个原因是生成器和判别器的学习难度不平衡。我们认为,生成的连续性问题使得生成分布存在天然缺陷,是使生成器训练更困难、判别器更易作出判别的原因之一。为了稳定GAN训练过程,我们将隐空间分布变换引入GAN训练中,在更新判别器时对参与优化的隐空间分布进行变换,变换具体方法与上一节一致(考虑到训练过程的计算代价,我们仅在训练中进行一次I-FGSM迭代),从而弥补生成器的生成缺陷,缓解训练困难以优化生成器映射。

AdvLatGAN-div:生成多样性为目标的GAN训练算法

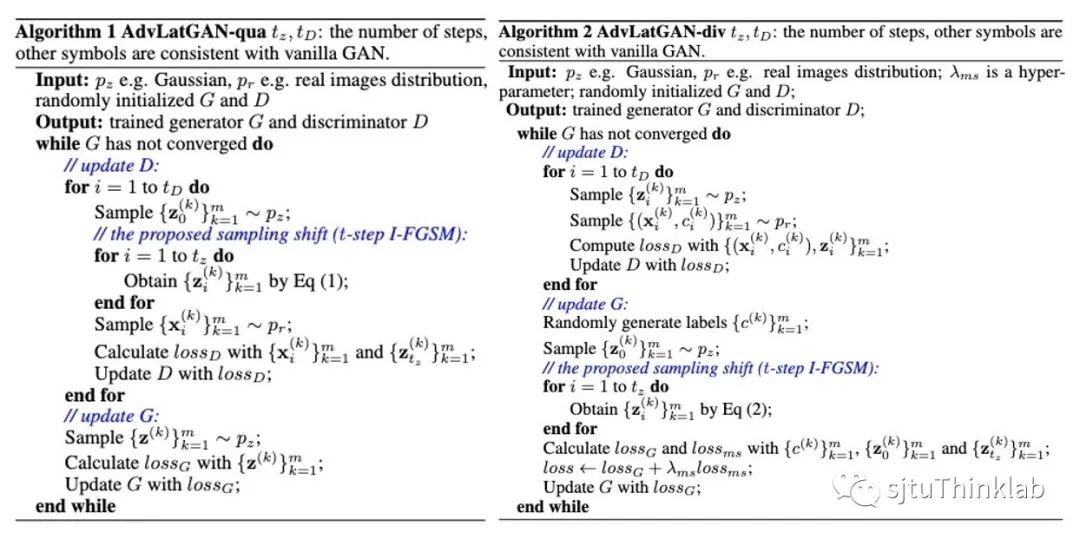

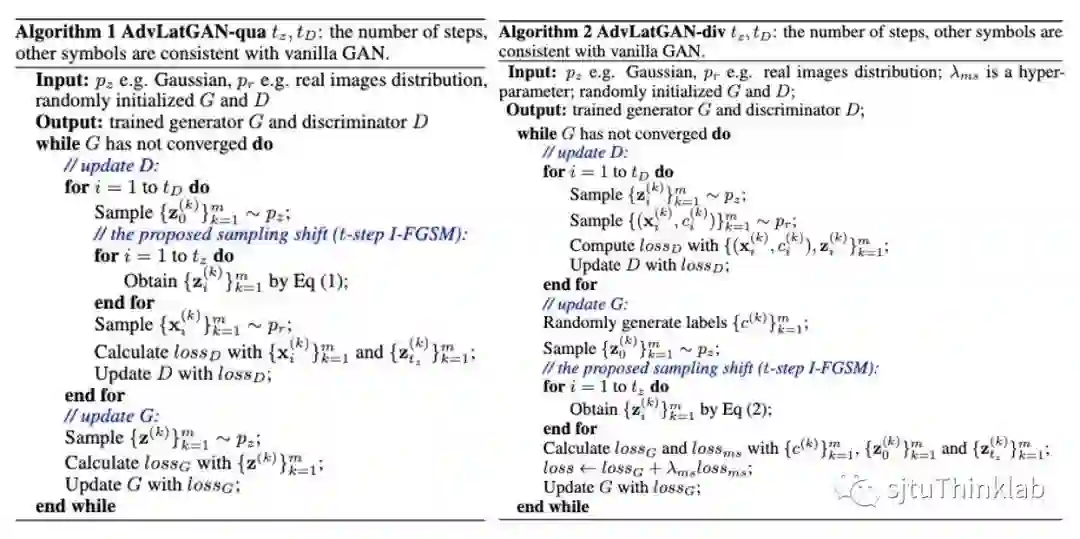

生成质量之外,我们也考虑通过隐空间采样变换来提升GAN的生成多样性。MSGAN[6]在条件生成场景下通过对随机隐空间采样和添加正则以缓解模式崩溃问题。 MS正则项通过约束样本在目标空间中的距离以防止生成样本陷入模式坍缩。 在本文中,我们考虑使用特化的隐空间采样替代MS正则项中的随机隐变量以强化MS正则项的效果。从困难样本挖掘视角,我们使用I-FGSM方法通过下式来搜索倾向于模式崩溃的隐变量对,该变量对具体表现为在隐空间中差异较大但在目标空间中相近。我们固定初始隐变量并通过下式寻找以组成一个采样对。 AdvLatGAN-qua和AdvLatGAN-div的具体算法如下:

实验结果

我们在仿真数据和真实数据上验证了算法的有效性,验证的方法包括post-training隐空间采样变换AdvLatGAN-z,GAN训练算法AdvLatGAN-qua/div,以及二者结合方法AdvLatGAN-qua+/div+。

AdvLatGAN-z:隐空间采样变换

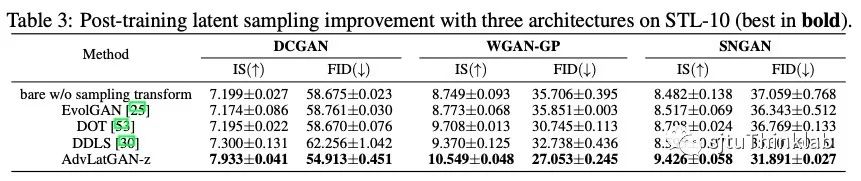

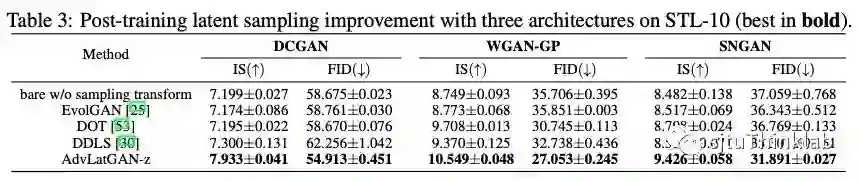

上表对比了其他GAN采样优化方法在不同GAN算法上的表现,AdvLatGAN-z显示出明显的优势。

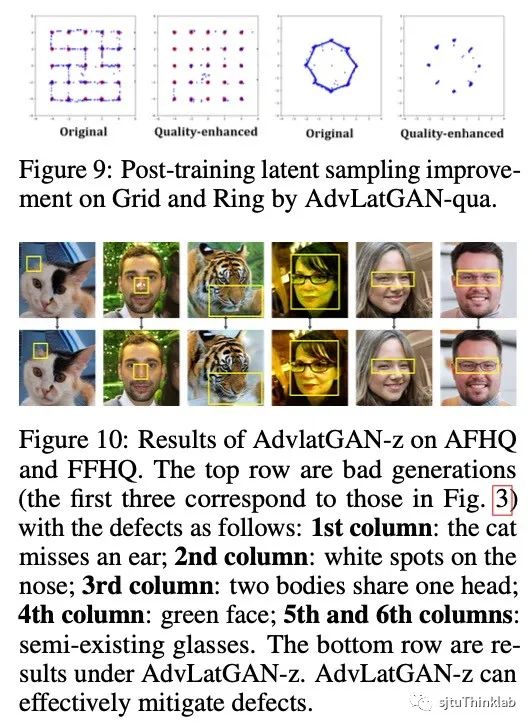

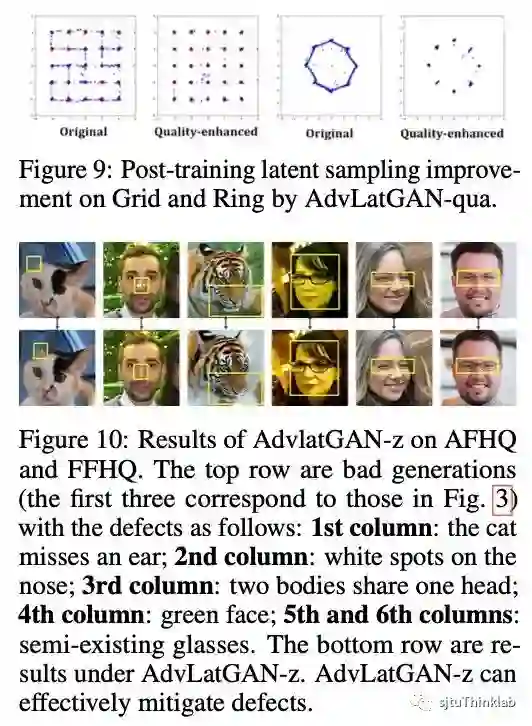

上图分别在仿真Grid/Ring数据和AFHQ数据集上可视化了生成样本在采样变换前后的差异,AdvLatGAN-z能够有效地提升生成质量,能够避免生成图像上的明显缺陷。

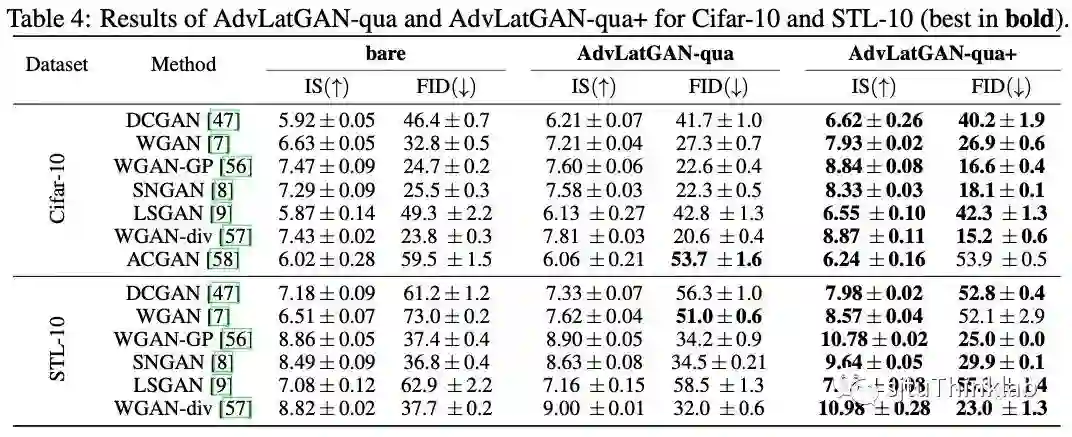

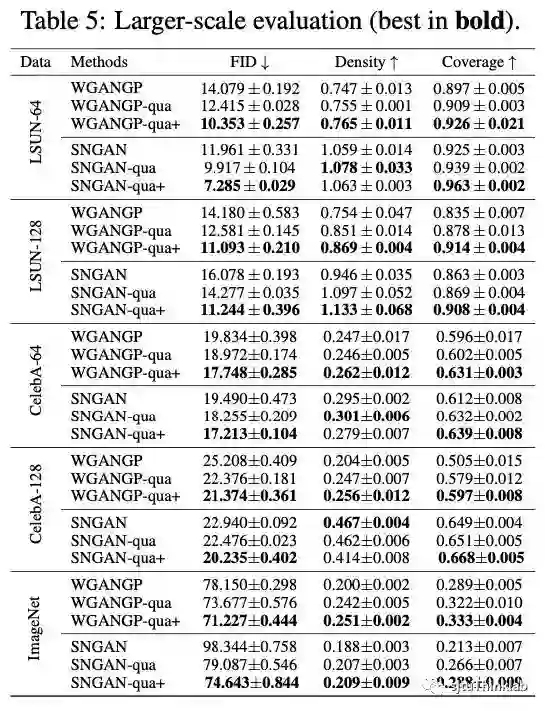

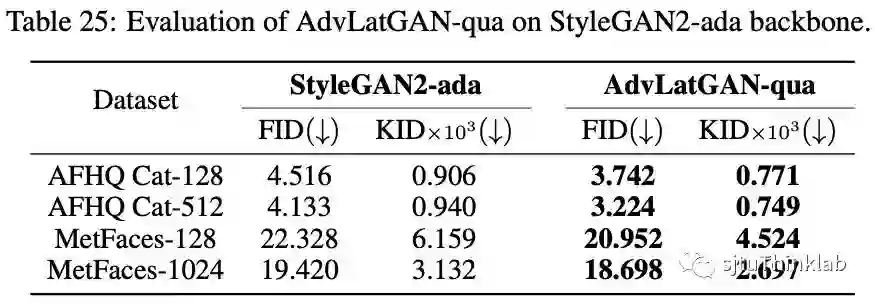

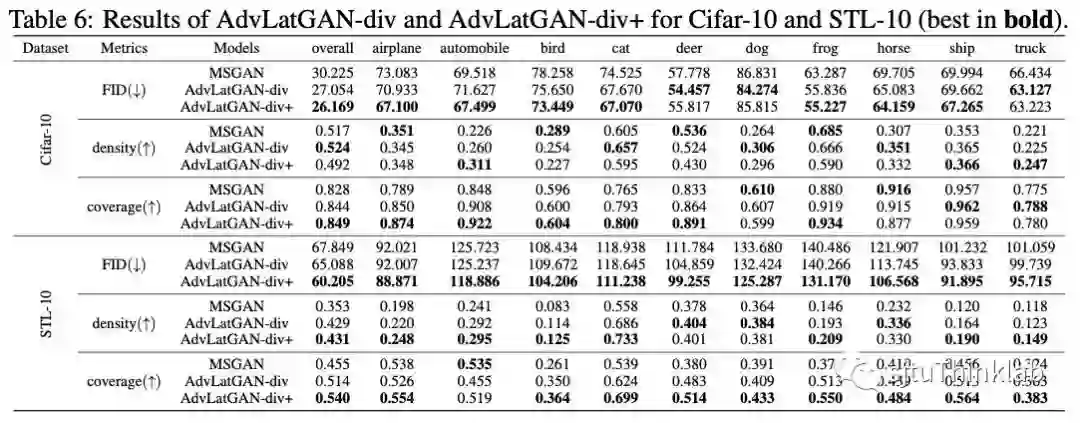

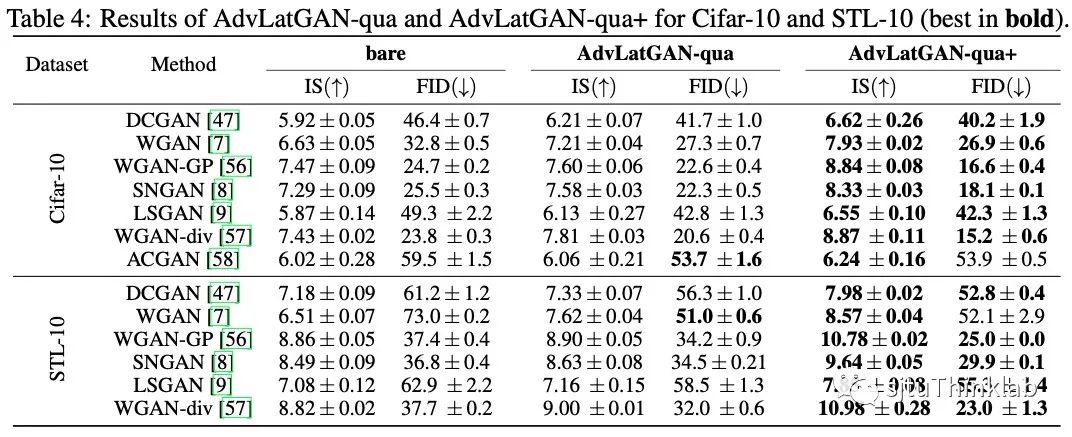

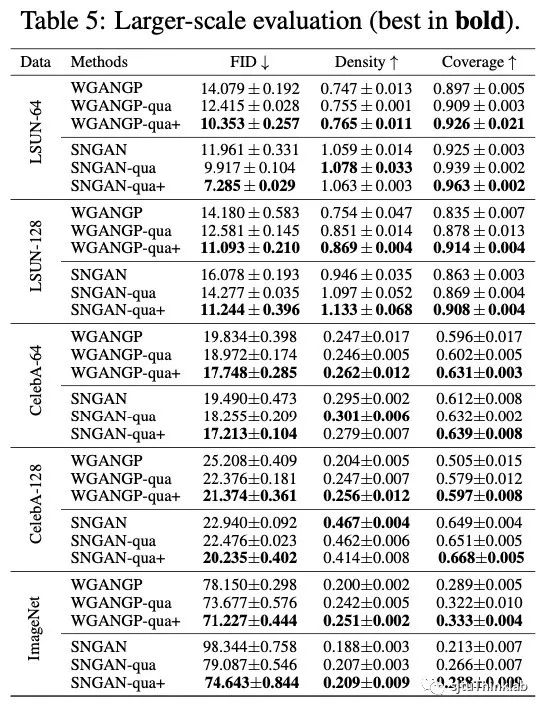

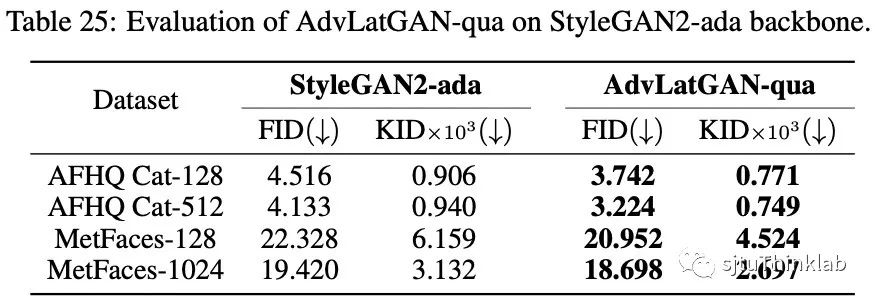

AdvLatGAN-qua/div:训练算法优化生成映射

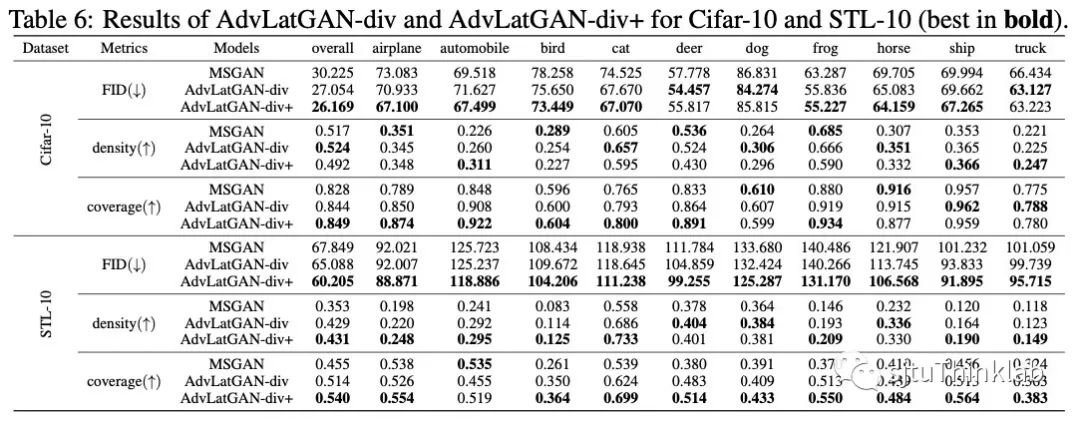

上表展示了AdvLatGAN-qua(+)/div(+)在八种主流GAN模型上的有效性,验证的数据集包括Cifar-10、STL-10、LSUN、CelebA、ImageNet、AFHQ以及MetFaces,在数值结果上,我们的方法在各种场景下均存在显著提升,提升幅度最高达到50%。

总结

参考文献

[1] Arjovsky M, Chintala S, Bottou L. Wasserstein generative adversarial networks[C]//International conference on machine learning. PMLR, 2017: 214-223. [2] Miyato T, Kataoka T, Koyama M, et al. Spectral Normalization for Generative Adversarial Networks[C]//International Conference on Learning Representations. 2018. [3] Karras T, Laine S, Aila T. A style-based generator architecture for generative adversarial networks[C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2019: 4401-4410. [4] Khayatkhoei M, Singh M K, Elgammal A. Disconnected manifold learning for generative adversarial networks[J]. Advances in Neural Information Processing Systems, 2018, 31. [5] Kurakin A, Goodfellow I J, Bengio S. Adversarial examples in the physical world[M]//Artificial intelligence safety and security. Chapman and Hall/CRC, 2018: 99-112. [6] Mao Q, Lee H Y, Tseng H Y, et al. Mode seeking generative adversarial networks for diverse image synthesis[C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2019: 1429-1437.