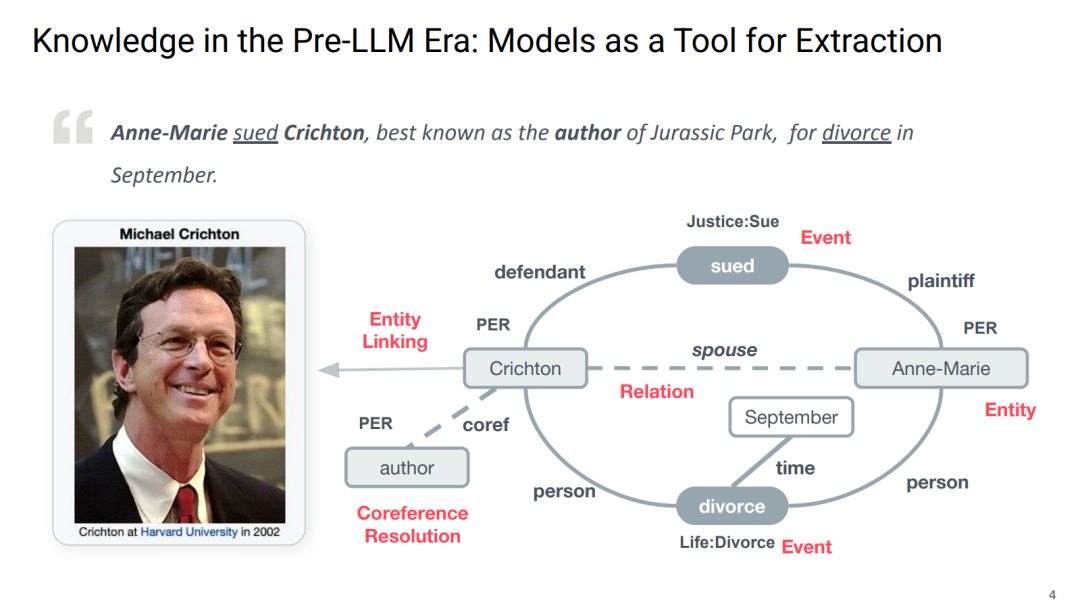

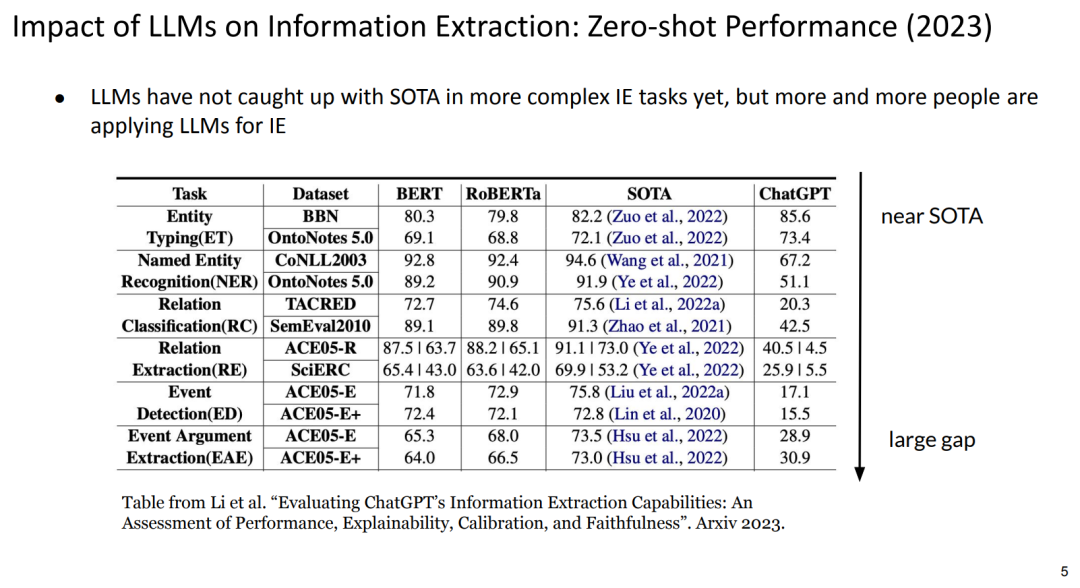

知识是各种人工智能应用的重要前提。通常,知识来源于结构化知识库(如知识图谱和词典)或非结构化知识源(如维基百科文档)。近年来,研究人员发现,大型语言模型(LLM)在预训练过程中已经内化了大量知识。 受此启发,大型语言模型被用于生成常识性知识和事实性知识,以增强问答任务的背景信息。尽管研究结果令人鼓舞,但仍然存在许多悬而未决的问题:这些知识从何而来?大型语言模型掌握了多少知识?这些知识的可靠性如何?如果某些知识是错误的,我们如何修正?本教程探讨大型语言模型中的知识生命周期,包括:(1) 通过基础模型预训练知识的涌现;(2) 外部知识的注入;(3) 知识的更新与修改;(4) 知识的探测与生成;(5) 多模态知识的整合,包括对物理世界的理解和程序性规划。我们的目标受众主要来自自然语言处理(NLP)、人工智能(AI)和机器学习(ML)社区。参与者将获得对近期研究进展的全面回顾,并深入分析知识与大型语言模型交互的未来方向。

目前,关注该生命周期不同阶段的研究人员分散在机器学习的不同子社区:知识的探测与编辑通常属于可解释性研究范畴;知识注入通常是特定于应用的,主要在对话系统、问答、信息抽取和摘要任务中探讨;多模态知识(如物理世界知识和程序规划知识)则更多由计算机视觉和机器人学社区研究。本教程旨在将这些研究人员汇聚在一起,促进跨领域合作,从而形成对该问题更全面的理解。

成为VIP会员查看完整内容

相关内容

Arxiv

195+阅读 · 2023年4月7日

Arxiv

77+阅读 · 2023年3月21日