随着越来越多的应用将数据表示为图,图神经网络(GNNs)成为在图数据上应用深度学习的有用工具。带符号和有向网络是与许多现实世界问题相关的重要网络形式,如从成对比较中的排序和角同步。

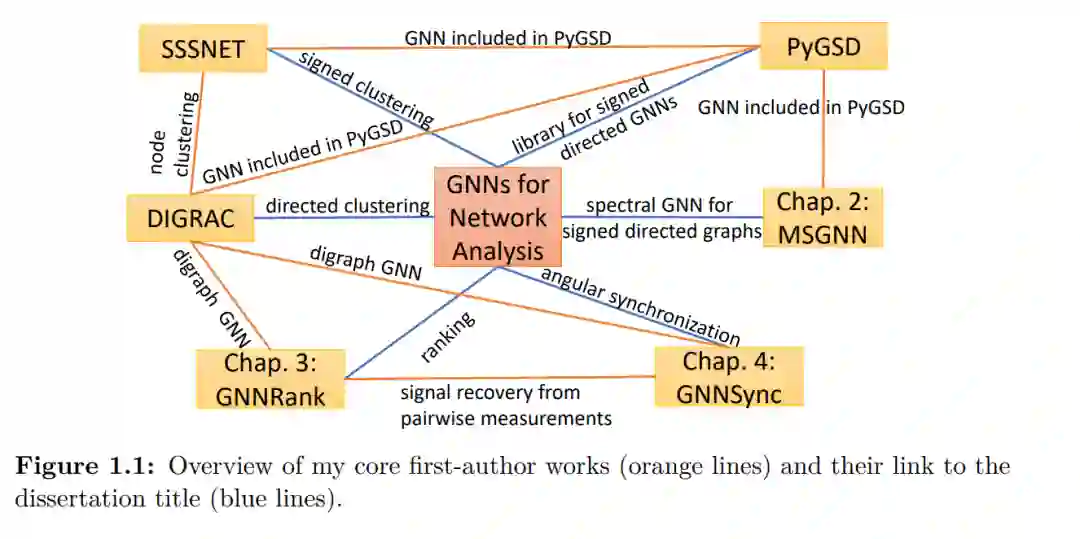

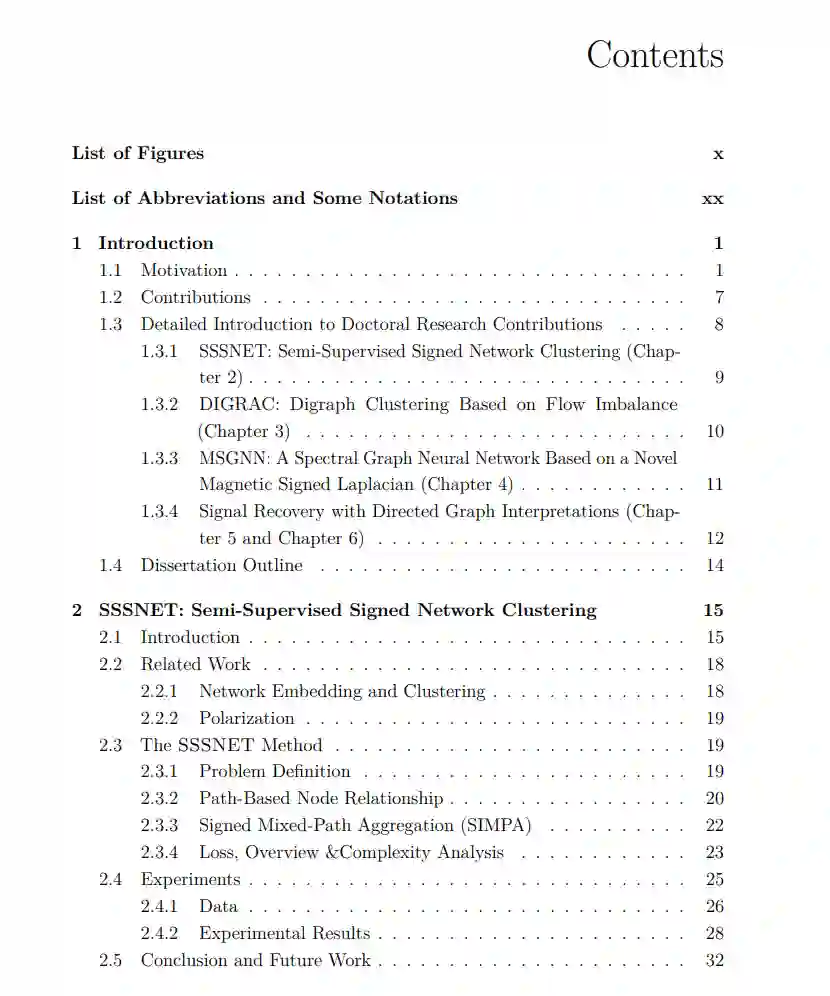

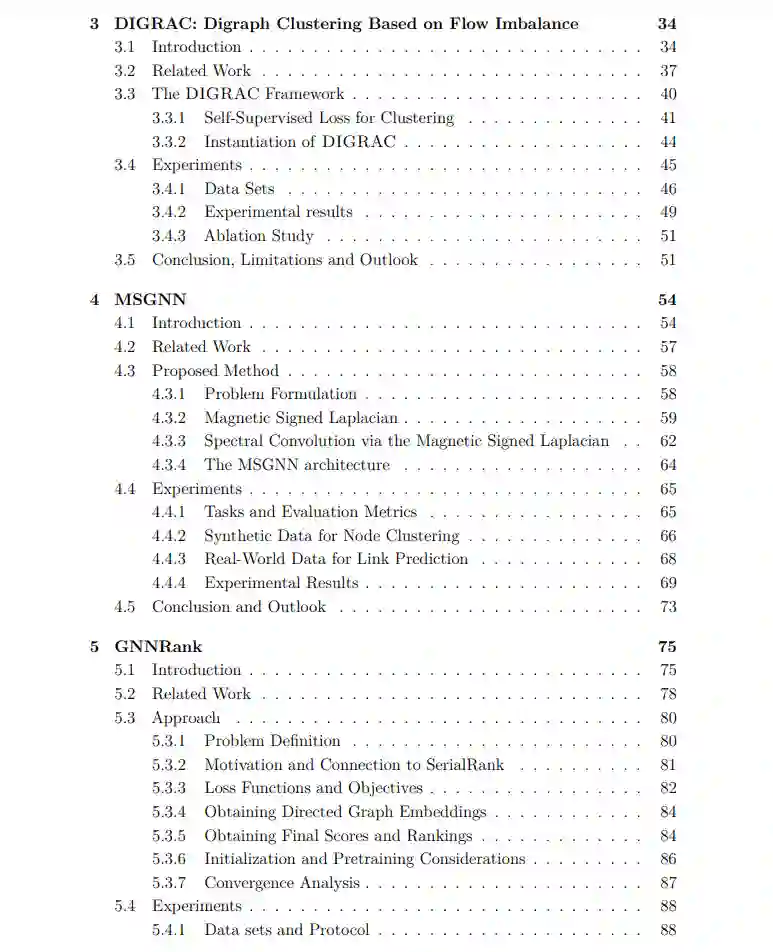

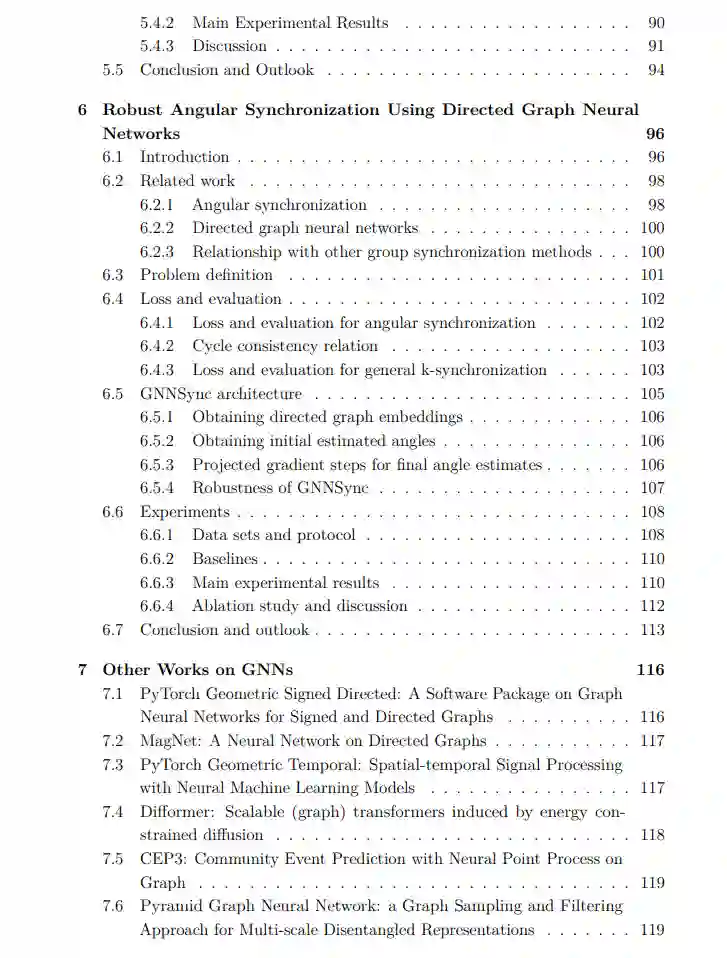

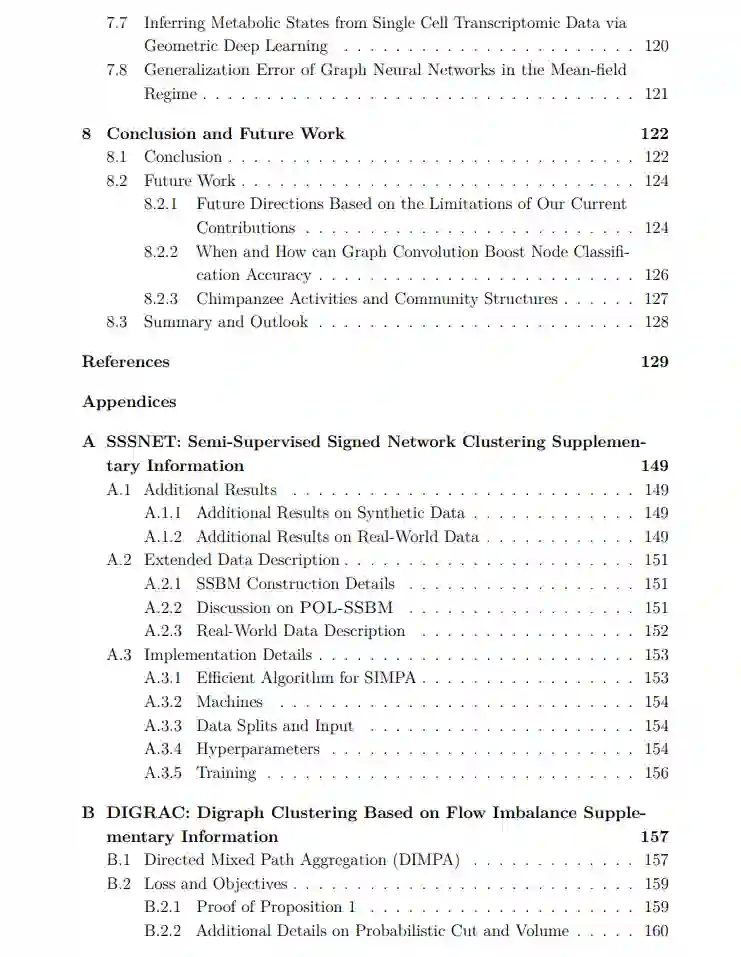

在本报告中,我们提出了两种用于带符号和有向网络中节点聚类的空间GNN方法,一种用于带符号有向网络节点聚类和链接预测的谱GNN方法,以及两种针对排序和角同步具体应用的GNN方法。这些方法在嵌入生成和预测中结合为端到端的方法,没有中间步骤。

在各种数据集上的实验结果,包括几个合成随机块模型、随机图异常模型以及不同规模的现实世界数据集,表明我们提出的方法在广泛的噪声和稀疏水平上能够达到令人满意的性能。这些模型还通过可能包括节点级特征或标签的外生信息,补充了现有方法。 这些贡献不仅有助于分析以网络表示的数据,还形成了一系列工作,提出了用于网络分析的GNNs的新颖架构和任务驱动的损失函数。

随着越来越多的数据来自非欧几里得领域,并以图的形式表示(如社交网络、引用网络和生物化学图),图数据因其丰富的关系信息,与许多学习任务相关联[1, 2]。需要从图数据中学习的任务包括预测蛋白质界面、分类疾病、学习分子指纹和建模物理系统[2]。虽然传统的网络分析通常集中于单一的固定简单网络,这些网络通常可以用具有非负条目的对称邻接矩阵表示,但更复杂的网络类型往往更具现实性。 为了解决网络推理任务,图神经网络(GNNs)是一种有用的工具。GNNs本质上是将深度学习应用于图数据。深度学习非常强大,因为神经网络是可训练的函数,用于进行预测。通常根据下游任务构建专用的损失函数,从而通过优化损失函数来更新神经网络参数。神经网络因此通常灵活易训练,并且往往能够达到令人满意的性能。利用标准的深度学习技术,如归一化、梯度下降和并行计算,GNNs可以像标准神经网络一样进行训练。通过利用网络结构,GNNs能够从具有长距离依赖的节点邻域中保留信息[2]。 GNNs有广泛的应用,如节点聚类、节点嵌入、链接预测、节点分类和时空图预测[1]。在本论文中,我们在复杂图中解决网络分析问题,通过结合任务的定制化应对特定领域的挑战。利用GNNs,我们能够通过将现有方法的输出作为输入或添加可学习参数来改进现有方法。以这种方式,我们的GNNs可以被视为对非GNN方法(通常是谱方法)的改进,这些方法无法自然地使用外部信息。