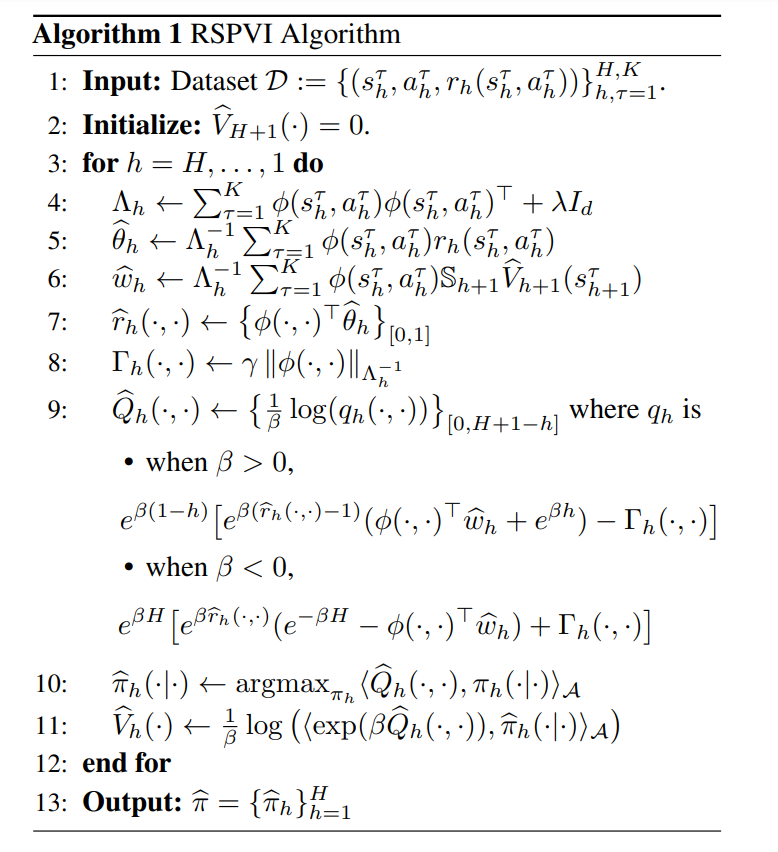

![]() 我们研究了风险敏感强化学习(RL),这是一个关键领域,因为它能够在需要管理不确定性和最小化潜在不良结果的情况下增强决策能力。特别是,我们的工作重点是将熵风险度量应用于强化学习问题。尽管现有文献主要研究在线环境,但在如何仅使用预先收集的数据集高效地导出基于这种风险度量的近最优策略方面仍存在很大空白。我们聚焦于线性马尔可夫决策过程(MDP)设置,这是一种备受推崇的理论框架,但尚未从风险敏感的角度进行过研究。对此,我们引入了两种可证明样本效率的算法。我们首先提出了一种风险敏感的悲观值迭代算法,通过利用风险敏感性能度量的结构提供了紧密的分析。为了进一步改善所获得的界限,我们提出了另一种利用方差信息和参考优势分解的悲观算法,有效地改进了对空间维度ddd 和风险敏感因子的依赖性。据我们所知,这是首次获得可证明有效的风险敏感离线强化学习算法。

我们研究了风险敏感强化学习(RL),这是一个关键领域,因为它能够在需要管理不确定性和最小化潜在不良结果的情况下增强决策能力。特别是,我们的工作重点是将熵风险度量应用于强化学习问题。尽管现有文献主要研究在线环境,但在如何仅使用预先收集的数据集高效地导出基于这种风险度量的近最优策略方面仍存在很大空白。我们聚焦于线性马尔可夫决策过程(MDP)设置,这是一种备受推崇的理论框架,但尚未从风险敏感的角度进行过研究。对此,我们引入了两种可证明样本效率的算法。我们首先提出了一种风险敏感的悲观值迭代算法,通过利用风险敏感性能度量的结构提供了紧密的分析。为了进一步改善所获得的界限,我们提出了另一种利用方差信息和参考优势分解的悲观算法,有效地改进了对空间维度ddd 和风险敏感因子的依赖性。据我们所知,这是首次获得可证明有效的风险敏感离线强化学习算法。

![]()