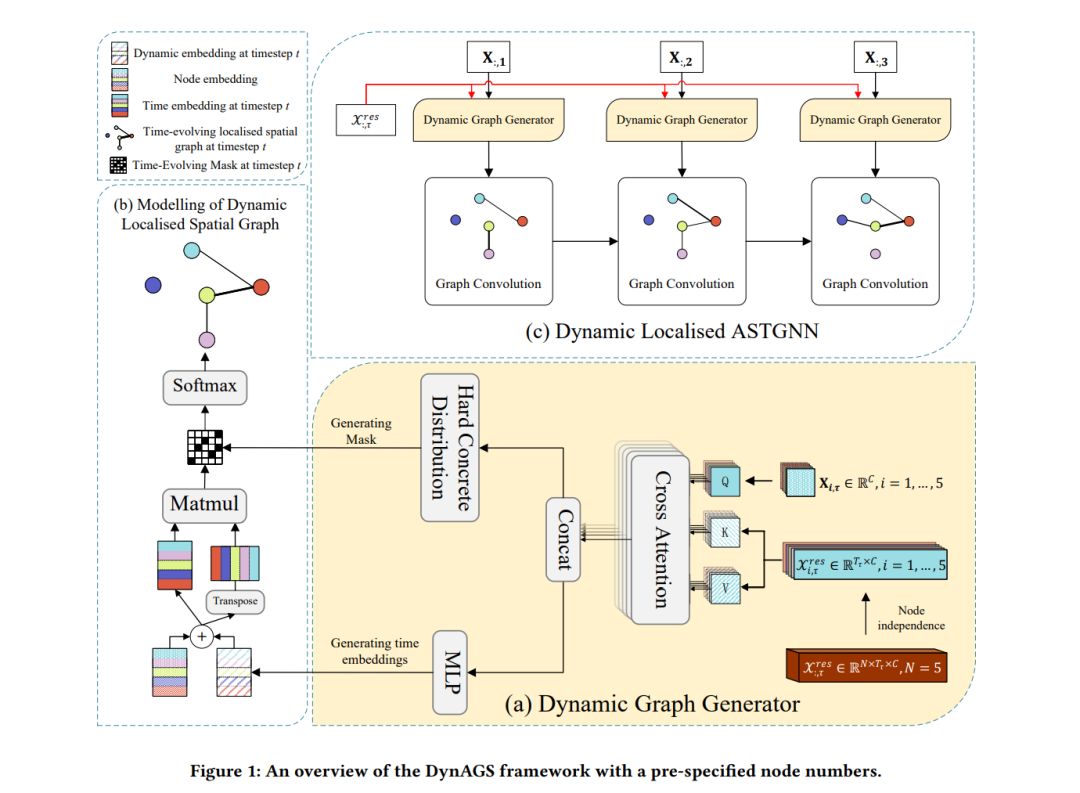

时空数据是许多智能应用的基础,它揭示了当前特定位置的测量值与相同或其他位置的历史数据之间的因果关联。在此背景下,适应性时空图神经网络(ASTGNNs)作为建模这些依赖关系的有力工具,尤其通过数据驱动的方法,而非预定义的空间图,已得到了广泛应用。尽管这一方法提供了更高的准确性,但也带来了更高的计算需求。为了解决这一挑战,本文深入探讨了ASTGNNs中的定位概念,并提出了一种创新的视角,即空间依赖关系应当随着时间动态演化。我们提出了DynAGS,一种本地化的ASTGNN框架,旨在最大化分布式部署中的效率和准确性。该框架集成了动态定位、时变空间图和个性化定位,所有功能围绕动态图生成器这一轻量级中央模块进行协调,该模块利用交叉注意力机制。中央模块能够以节点无关的方式集成历史信息,增强当前时刻节点的特征表示。随后,改进后的特征表示用于生成动态稀疏图,无需进行昂贵的数据交换,同时支持个性化定位。通过在两种核心ASTGNN架构和九个来自不同应用领域的真实数据集上的性能评估,结果表明DynAGS超越了现有的基准方法,突出表明时空依赖关系的动态建模可以显著提升模型的表现力、灵活性和系统效率,特别是在分布式环境中。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日