摘要——人工智能(AI)在许多领域取得了惊人的成功,尤其是随着基础大模型开发的最新突破。这些大模型利用其广泛的训练数据,为各种下游任务提供了多功能的解决方案。然而,随着现代数据集变得越来越多样化和复杂化,大型AI模型的开发面临两大挑战:(1)巨大的计算资源消耗和部署困难;(2)难以拟合异构和复杂数据,这限制了模型的可用性。**混合专家系统(Mixture of Experts, MoE)**模型最近在解决这些挑战方面引起了广泛关注,它通过动态选择和激活最相关的子模型来处理输入数据。研究表明,MoE能够以更少的资源显著提高模型性能和效率,尤其擅长处理大规模、多模态数据。鉴于MoE在各个领域展现出的巨大潜力,迫切需要对MoE在许多重要领域的最新进展进行全面总结。现有的MoE综述存在一些局限性,例如内容过时或缺乏对某些关键领域的讨论,我们旨在填补这些空白。本文首先介绍了MoE的基本设计,包括门控函数、专家网络、路由机制、训练策略和系统设计。接着,我们探讨了MoE在持续学习、元学习、多任务学习和强化学习等重要机器学习范式中的算法设计。此外,我们总结了旨在理解MoE的理论研究,并回顾了其在计算机视觉和自然语言处理中的应用。最后,我们讨论了未来有前景的研究方向。

关键词——混合专家系统(Mixture-of-Experts)、持续学习、元学习、多任务学习、强化学习、计算机视觉、自然语言处理

I. 引言

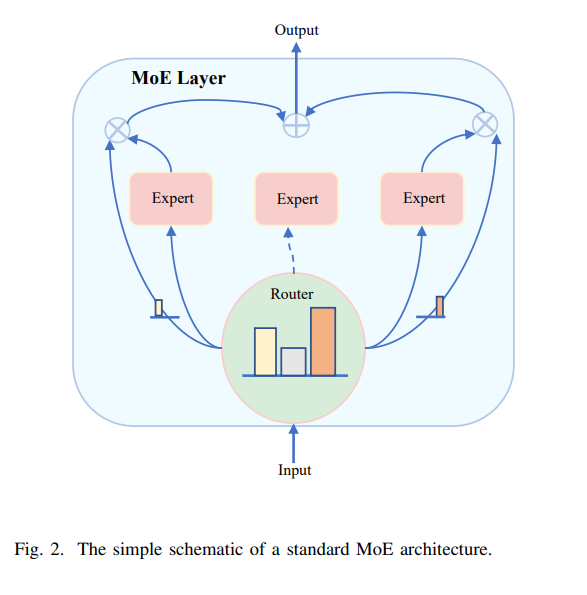

人工智能(AI)已成为现代技术中的一股变革力量,在从计算机视觉[1]、[2]、[3]、语音识别[4]、[5]到医疗保健[6]和自主系统[7]的多个领域取得了显著成功。其背后的关键驱动力是基础模型的发展,例如BERT[8]、CLIP[9]、GPT-4[10]等,这些大规模神经网络在大量数据集上进行了预训练,并为各种下游任务提供了多功能解决方案。基于这些预训练知识,这些模型可以通过最少的额外训练进一步微调,以适应特定应用。 然而,随着AI应用的扩展,现代数据集变得越来越多样化和复杂化。它们通常包含多模态数据(例如文本、图像和音频)并表现出复杂的结构(例如图或层次关系)。这种多样性和复杂性带来了两大挑战:(1)训练和部署大型模型的计算成本呈指数级增长,使得许多应用难以承受[11];(2)在单一模型中整合冲突或异构知识变得越来越困难,通常会导致训练动态不稳定和性能欠佳[12]。这些挑战凸显了对更高效、可扩展架构的需求,以满足现代AI任务日益增长的需求。 解决这些挑战的一种有前景的方法是**混合专家系统(Mixture of Experts, MoE)**架构,该架构最近引起了广泛关注。最初在[13]、[14]中提出,MoE采用“分而治之”的策略,从根本上区别于传统的密集模型。传统模型为每个输入激活所有参数,而MoE模型则根据输入数据的特征动态选择和激活最相关的参数子集。这种方法不仅增强了个别专家的专业化能力,还缓解了在多样化和冲突任务上训练的困难。此外,选择性激活机制使MoE模型能够显著扩展其容量并处理多样化的知识领域,而无需按比例增加计算成本,从而在性能和效率之间实现最佳平衡[15]、[16]。通过利用不同任务或数据类型的“专家”优势,MoE为解决复杂、多面数据集带来的挑战提供了一个可扩展且灵活的框架。 值得注意的是,MoE模型架构在大语言模型(LLMs)中展现了其独特的优势和巨大潜力[171]、[172]、[173]、[21]、[15]、[20]、[52]、[174]、[175]、[176]、[177]、[178]、[179]、[180]、[181]、[182]。例如,Switch Transformer[15]在预训练速度上比T5-Base[183]模型快7倍,并在多语言环境中在所有101种语言上表现出改进的性能。它还成功地将参数规模扩展到万亿级别,在此规模下实现了比T5-XXL[183]模型快4倍的预训练速度。GLaM[20]也将参数扩展到万亿级别,增强了模型利用上下文信息的能力。Deepspeed-moe[52]利用MoE和模型压缩技术将MoE模型的规模缩小了3.7倍。ST-MoE[174]进一步研究了MoE模型的稳定性和可迁移性,提出了诸如Router z-loss等多种方法以确保训练稳定性。最终,在SuperGLUE[184]基准测试中,ST-MoE-32B模型超越了之前的最先进模型。OpenMoE[178]尝试了仅解码器的MoE,并对MoE的路由机制进行了深入讨论,为开源社区对MoE架构的理解做出了重要贡献。Mixtral 8×7B[22]尽管每个令牌仅处理130亿个活动参数,但由于其独特的架构,能够访问总共470亿个参数。这使得Mixtral 8x7B能够实现更高的参数效率并有效控制计算成本。DeepSeek系列[185]、[186]、[53]、[187]的出色表现也引起了广泛关注。这些模型利用MoE架构在各种基准测试中取得了最先进的结果,同时保持了可控的计算需求。 除了效率之外,MoE模型还为提高模型可解释性提供了机会[101]、[188]、[35]、[189]。通过学习内在分配机制,研究人员可以深入了解不同专家如何处理特定类型的数据或任务。这种可解释性不仅增强了我们对模型行为的理解,还为设计更健壮和透明的AI系统开辟了新途径。 鉴于MoE研究兴趣的快速增长及其在各个应用领域的巨大潜力,迫切需要对MoE的最新进展进行全面综述,以引发更多关注并激发该领域的进一步研究思路。然而,早期的MoE综述[190]、[191]发表于十年前,并未涵盖该领域的新发展。去年仅有一篇新综述[192]出现,但其1)更侧重于MoE的基本设计;2)未对MoE在重要机器学习范式和计算机视觉等应用领域的广泛使用进行讨论。MoE的理论发展也未涵盖。 尽管在我们准备本文期间,一些新的并发综述最近已上传至网络,但这些综述要么专注于MoE的某个特殊方面,例如大数据[193]、推理优化[194]和LLMs[195]中的应用,要么对多个主题进行了非常简短的覆盖[196]。据我们所知,本文是第一篇全面总结MoE最新进展的综述,涵盖了四个关键组成部分:MoE的基本设计策略、主流机器学习方向中基于MoE的算法设计、理解MoE的理论研究,以及对MoE在计算机视觉和自然语言处理中应用的深入回顾。 本文的组织结构如下(如图1所示)。在第二部分,我们将全面介绍MoE的基本设计,涵盖从基本架构设计到训练策略再到系统优化策略的各个方面。在第三部分,我们将介绍四种重要机器学习范式中基于MoE的算法设计,包括持续学习、元学习、多任务学习和强化学习,旨在为读者提供关于如何利用MoE改进这些领域算法设计的一般思路。在第四部分,我们将总结旨在建立对MoE理论理解的研究,涵盖MoE的多个方面,例如不同的门控函数、不同的专家模型和不同的学习场景。在第五部分,我们将介绍MoE在计算机视觉和自然语言处理两大领域的最新应用,深入探讨每个领域中的多个重要子问题。第六部分将讨论未来的研究方向,最后在第七部分进行总结。