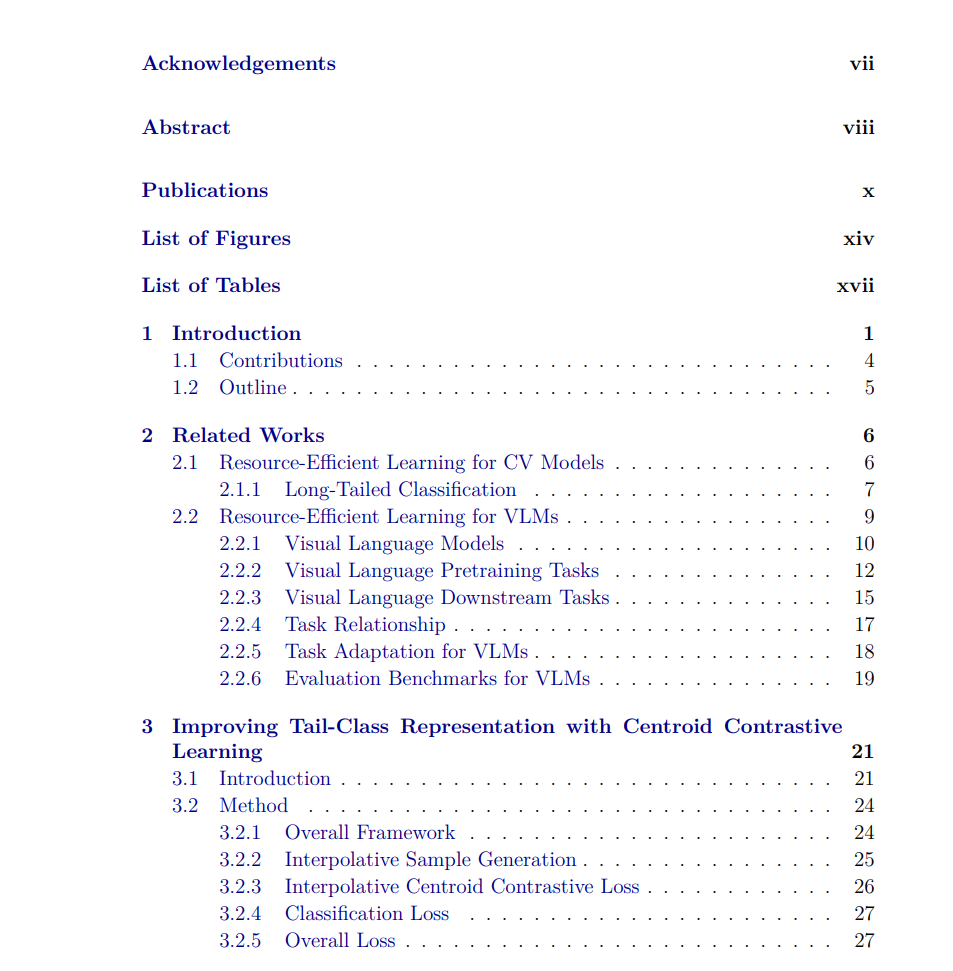

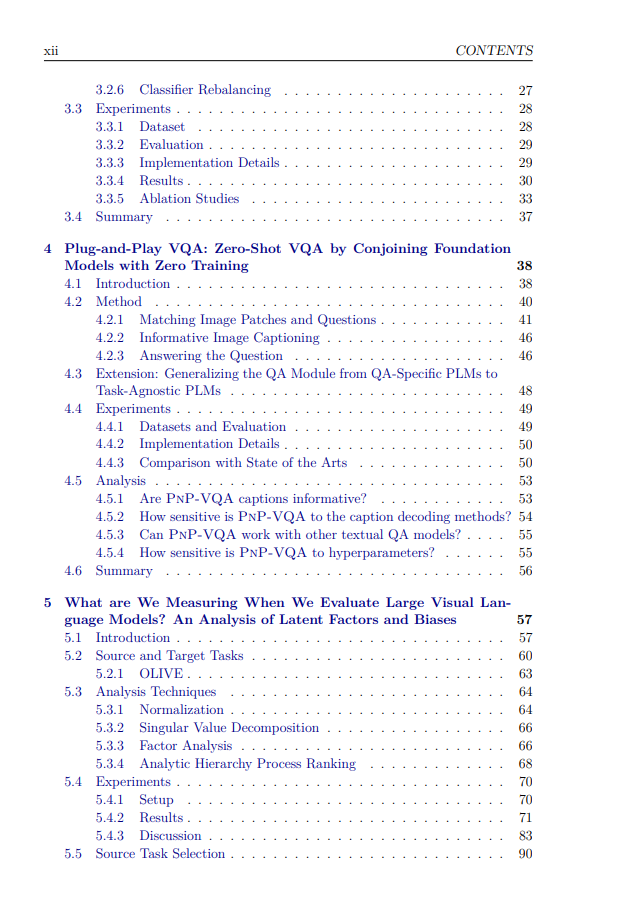

人类智能的标志是能够通过应用从先前任务中学习到的相关知识来处理新任务。因此,人类在适应过程中只需要少量的新任务示例。相比之下,深度学习模型在实现这种卓越的泛化能力方面仍然落后于人类,特别是在数据有限的新任务中。这种学习方式被称为资源高效学习。在本论文中,我们探讨了面向具有视觉能力的深度学习模型的资源高效问题的公式化。我们首先研究了应用于长尾图像分类的纯视觉神经模型。在长尾图像分类中,尾类的训练样本数量稀少,而头类样本则丰富。训练分布的不平衡使得学习良好的尾类表示变得困难。我们提出了插值中心对比学习(ICCL)方法,通过利用丰富的头类样本来促进尾类表示的学习。我们在头类和尾类之间创建插值样本,并使用新的插值中心对比损失来优化表示。我们在多个长尾评估数据集上展示了ICCL的有效性。

接下来,我们将研究扩展到涉及图像和文本模态的视觉语言模型(VLMs)。我们调查了零样本视觉问答(VQA),该方法限制VLMs访问任何VQA训练样本。我们设计了一个模块化框架PnP-VQA,该框架执行零样本VQA并且不需要训练。我们利用自然语言和网络可解释性技术作为接口,结合多个预训练模型。具体来说,我们首先通过关注相关的图像区域生成多个问题引导的描述,然后将这些描述作为上下文输入到预训练语言模型中以回答问题。我们的问题引导描述能够捕捉详细的视觉属性并包含答案词,从而帮助问答模型获得正确答案。我们的PnP-VQA在多个VQA基准测试中实现了最先进的结果。

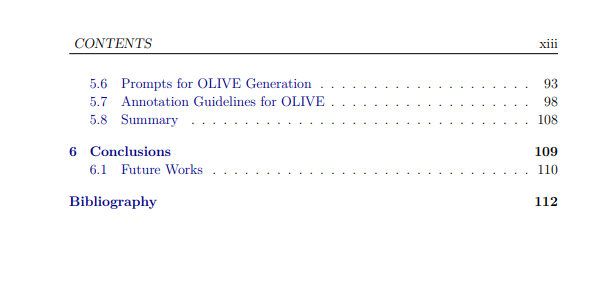

我们最后研究了视觉语言模型(VLMs)的零样本评估。至关重要的是,VLMs在零样本设置下的测试任务性能应反映其真实的泛化能力,这样我们才能对VLMs进行公平比较并跟踪其进展。当测试任务与VLM的训练任务高度相似时,该VLM的性能可能会高于那些没有这种相似性的其他VLMs。因此,我们进行了迁移学习实验,以研究训练任务和测试任务之间的相似性,这是在评估VLMs时通常未考虑的。此外,我们通过利用迁移性能上的因子分析,直接从数据中发现潜在的视觉语言技能。我们证明了因子分析是一种有效的数据驱动方法,可以识别出合理但令人惊讶的视觉语言技能。 此外,我们通过提出一个新的基准测试OLIVE,解决了缺乏关注野外VLM评估的视觉语言基准的问题。OLIVE模拟了用户在实际、现实场景中对VLMs的多样化查询。

https://dr.ntu.edu.sg/handle/10356/174637