人工智能(AI)技术,特别是那些基于深度学习(DL)的技术,已经在各种各样的任务上变得非常有效,有时甚至表现得比人类专家更好。然而,它们也有一些问题:它们通常以不透明和/或棘手的方式运行,它们的非常好的性能仅是统计上的,即使在明显的情况下也可能失败,它们可能做出有偏见的决定,它们很容易通过对抗性攻击进行操作,举几个例子。这些限制阻碍了它们在具有重大经济或社会利益的应用中被采用,特别是在关键或明智的应用中,如自动驾驶、医疗诊断或贷款批准。

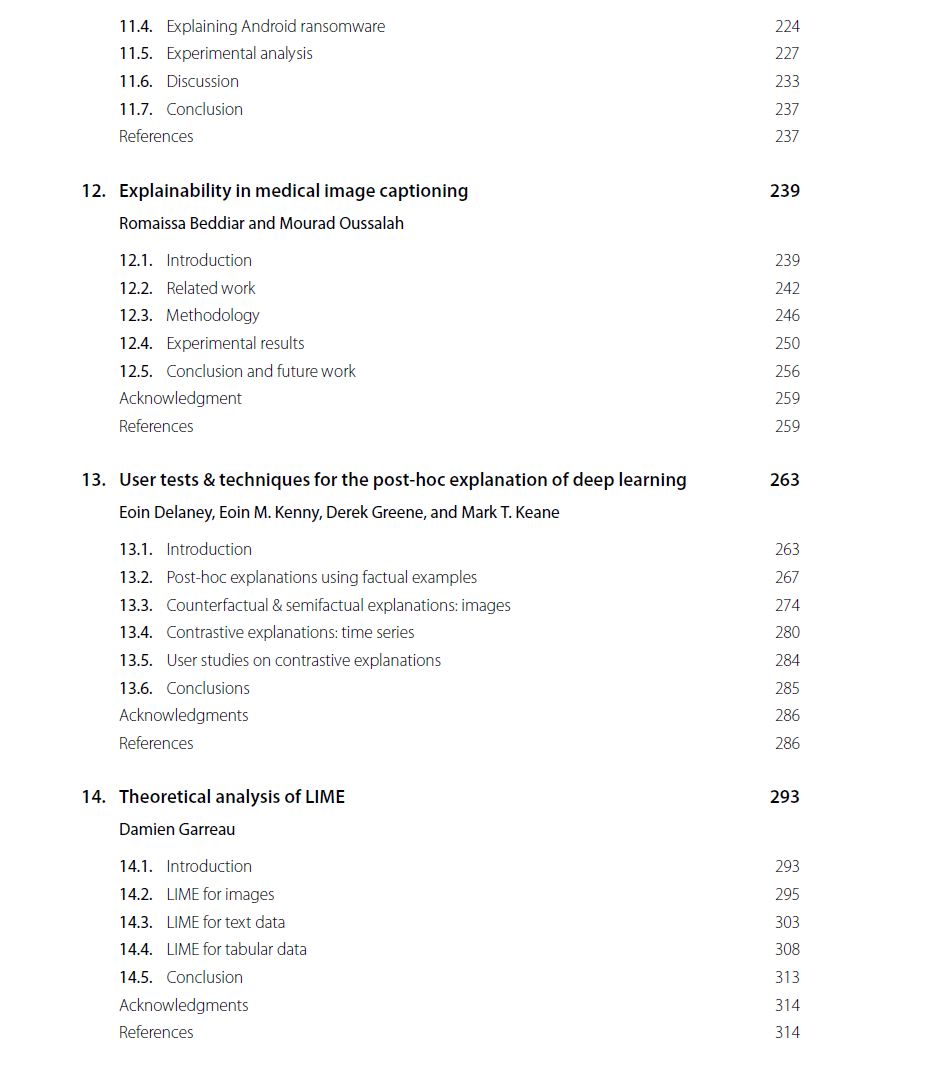

考虑到这一点,为了增加基于深度学习的人工智能系统的可信性,通过为这些系统所做的决策提供人类用户可以理解的解释,进行了大量的研究。本书的目的是为专家或外行人用户介绍可解释深度学习领域的主要方法的最新和原始贡献。提出了两种主要类型的方法:“事后”或“模型不可知”的方法,其中对一个已经可用的“黑盒”系统的操作进行建模和解释,以及内在的方法,其中系统被专门设计为具有可解释的操作模式的“白盒”。本书是我们在ICPR’2020 IAPR和IEEE会议上组织的一个非常成功的研讨会“Explainable Deep Learning-AI”的后续工作,该研讨会对该领域正在进行的研究进行了大规模的参观。可解释性的问题在许多媒体领域都得到了解决,包括图像、文本、时间序列和表格数据。两章具体论述了解释方法评价的难点和重要问题。最后,在结语部分提出了仍然存在的挑战。

https://www.elsevier.com/books/explainable-deep-learning-ai/benois-pineau/978-0-323-96098-4

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2023年5月11日

Arxiv

20+阅读 · 2023年3月21日