来自南洋理工《视频自然语言定位》综述论文,不可错过!

视频中的时序句子groundin(TSGV),又称自然语言视频定位(NLVL)或视频时刻检索(VMR),旨在从一个未裁剪的视频中检索出语义上与语言查询相对应的时态时刻。TSGV连接了计算机视觉和自然语言,引起了两个社区研究人员的极大关注。本文试图对TSGV的基本概念、研究现状以及未来的研究方向进行总结。在此背景下,我们以教程的形式介绍了TSGV中常用的函数组件结构: 从原始视频的特征提取到语言查询,再到目标时刻的回答预测。然后,我们回顾了多模态理解和交互的技术,这是TSGV的关键焦点,以实现两种模态之间的有效对齐。我们构建了TSGV技术的分类,并详细阐述了不同类别的TSGV技术及其优缺点。最后,我们讨论了当前TSGV研究的问题,并分享了我们对未来研究方向的见解。

https://www.zhuanzhi.ai/paper/b998e7d11bfb88537fb11bf5e47c07e6

引言

随着传播技术和媒体创作技术的快速发展和创新,视频逐渐成为信息传播的一种主要媒介。视频由可能伴有音频和字幕的连续图像帧序列组成。与图像和文本相比,视频所承载的语义知识更加丰富,活动更加多样和复杂。尽管视频有很多优势,但从视频中搜索内容还是很有挑战性的。因此,对于能够快速检索用户感兴趣的视频片段(使用自然语言指定)的技术有很高的要求。

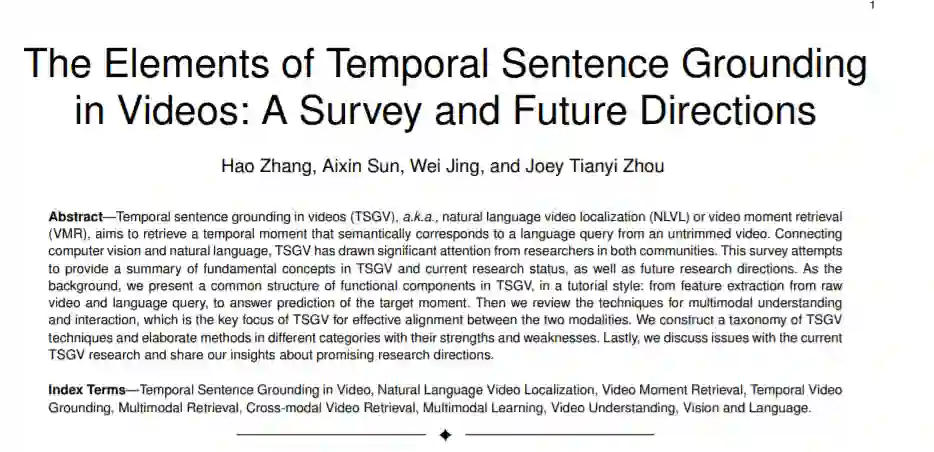

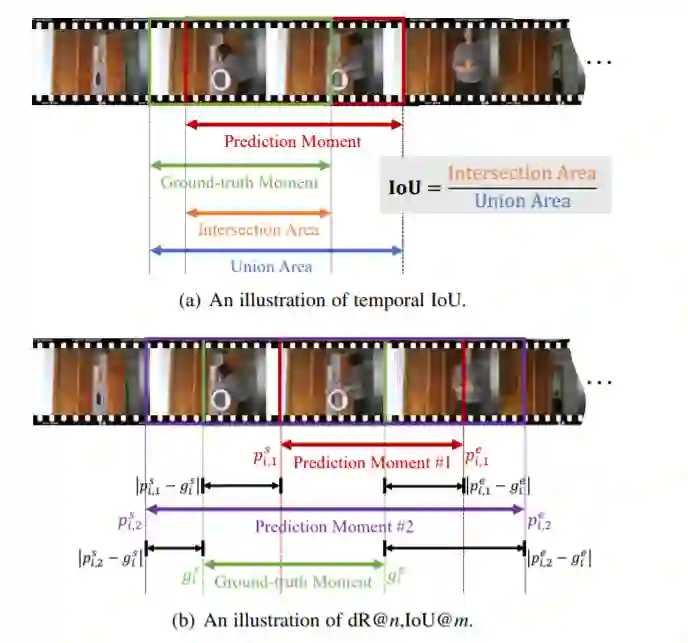

给定一个未剪切的视频,时序句groundin videos (TSGV)是检索一个视频片段,也称为时序时刻,该视频片段在语义上对应于一个自然语言的查询,即句子。如图1所示,用于查询“一个人正在把衣服放进洗衣机”。TSGV需要从输入的视频中返回一个视频时刻的开始和结束时间戳(即9.6s和24.5s)作为答案。回答时刻应该包含查询所描述的动作或事件。

TSGV作为一个基本的视觉语言问题,也作为各种下游视觉语言任务的中间步骤,如视频问答和基于视频的对话。这些任务需要定位问题的相关时刻,然后通过分析检索到的时刻来发现或生成输入问题的答案。自然,TSGV连接了计算机视觉(CV)和自然语言处理(NLP)社区,并从这两个领域取得的进步中获益。

TSGV也与CV和NLP中的一些经典任务有相似之处。例如CV中的视频动作识别(video action recognition, VAR)[1] -[4],就是从视频中检测出执行特定动作的视频片段。虽然VAR用行为信息定位时间片段,但它受到预定义的行动类别的限制。TSGV更灵活,旨在通过任意语言查询从视频中检索复杂和多样化的活动。在这个意义上,TSGV需要视频和语言的语义理解,以及它们之间的多模态交互作用。TSGV类似于NLP[5] -[8]中的阅读理解(RC)任务,即从文本中检索一系列单词来回答问题。文本检索的核心是文本段落与查询的交互。TSGV模拟了两种不同模式之间的相互作用,这使得它更加艰巨和具有挑战性。

TSGV提出于2017年[9],[10]; 这项任务立即引起了研究人员的极大关注。早期的解决方案主要采用无效的两阶段方法,首先采样时刻作为候选答案,然后将这些候选评分为[9]-[13]。后续的解决方案更关注视频和查询之间的有效和高效的多模态交互。很多方法被开发出来,包括基于提案的[14]-[18]、基于提案的[19]-[23]、基于强化学习的[24]-[26]、弱监督的[27]-[31]等。

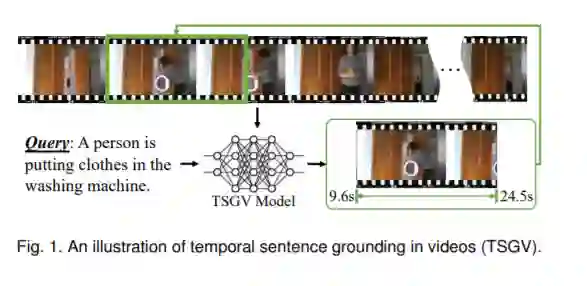

在本综述中,我们的目的是提供一个全面和系统的综述TSGV的研究。我们收集了CV、NLP、MM、IR和机器学习领域的知名会议和期刊的论文,如CVPR、ECCV、ICCV、WACV、BMVC、ACL、EMNLP、NAACL、SIGIR、ACM MM、NeurIPS、AAAI、IJCAI和TPAMI、TMM、TIP等。这些论文主要发表于2017年至2021年。在论文收集方面,我们主要依靠学术搜索引擎和数字图书馆,如IEEE Xplore、ACM数字图书馆、ScienceDirect、施普林格、ACL Anthology、CVF Open Access等。我们还采用谷歌Scholar收集其他会议/期刊的论文和开源文章收集到的论文统计结果如图2所示。

视频自然语言定位背景

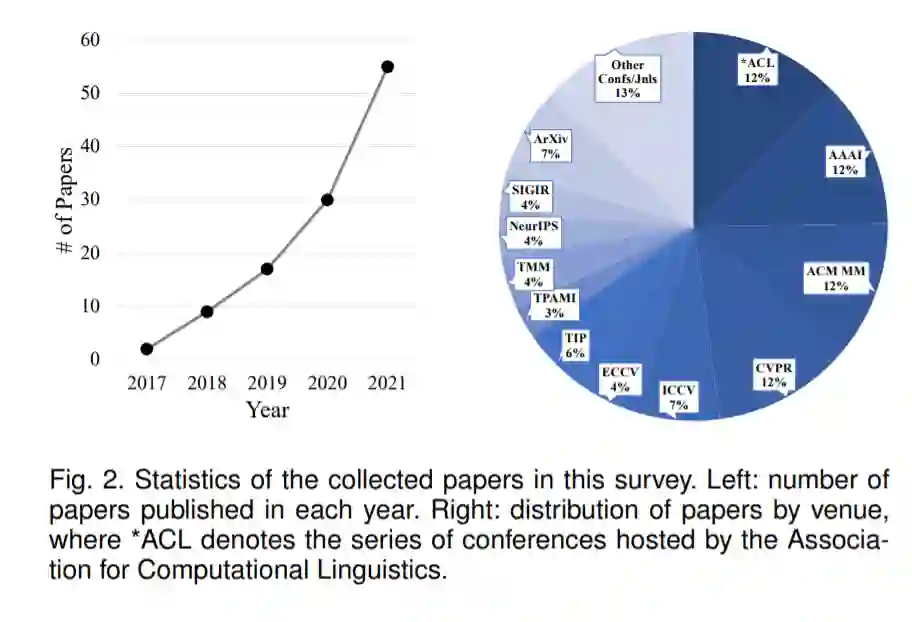

目前还没有理论指导来揭示TSGV方法的共同结构或流程。尽管在不同的方法中有各种复杂的体系结构,但在概念上,TSGV方法通常包含如图3所示的六个组件。图中的虚线表明proposal 生成器是一个可选组件,它可以被放置在不同的阶段。在深入第4节的技术细节之前,我们先简要介绍这些主要组件,以便为读者提供必要的背景知识。

TSGV方法以视频查询对作为输入,其中视频是连续图像帧的集合,查询是单词序列。预处理程序为特征提取准备输入,例如,视频中的图像帧降采样和调整大小,以及对查询句中的单词进行标记。特征提取器将视频帧和查询词转换成相应的向量特征表示。然后,编码器模块将视频和查询特征映射到同一维度,并聚合上下文信息来增强特征表示。交互器模块是TSGV的重要组成部分,它通过对视频与查询之间的跨模态交互建模来学习多模态表示。最后,答案预测器基于学习的多模态表示生成时刻预测。对于基于提案的方法,答案预测器根据提案生成器生成的提案进行预测。一个提案可以被认为是一个候选答案时刻,它可以在不同的阶段生成。一个示例方案是从输入视频中采样的视频片段。无提案方法直接预测答案,而不需要生成候选答案.

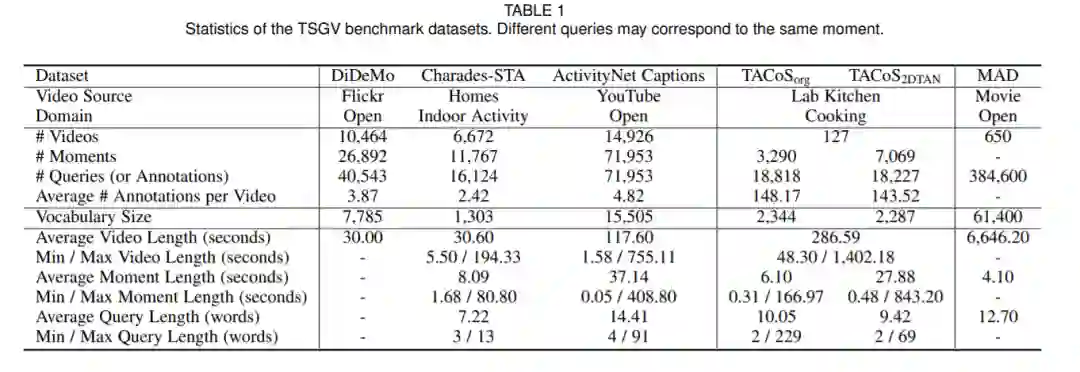

视频自然语言定位数据集与评价指标

数据集是构建和评估TSGV方法的基本资源。我们回顾基准数据集和评估指标。

视频自然语言定位方法 TSGV

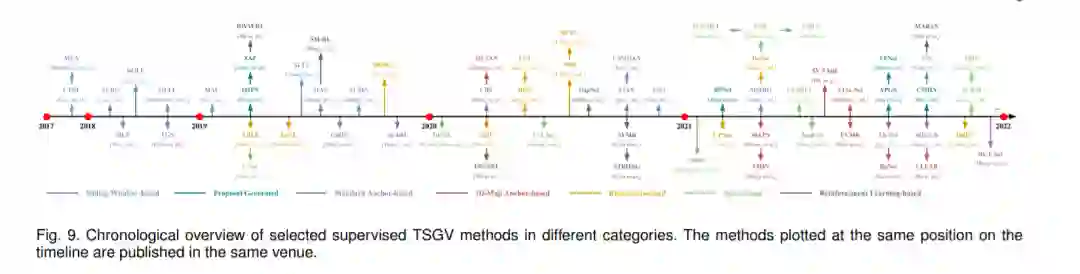

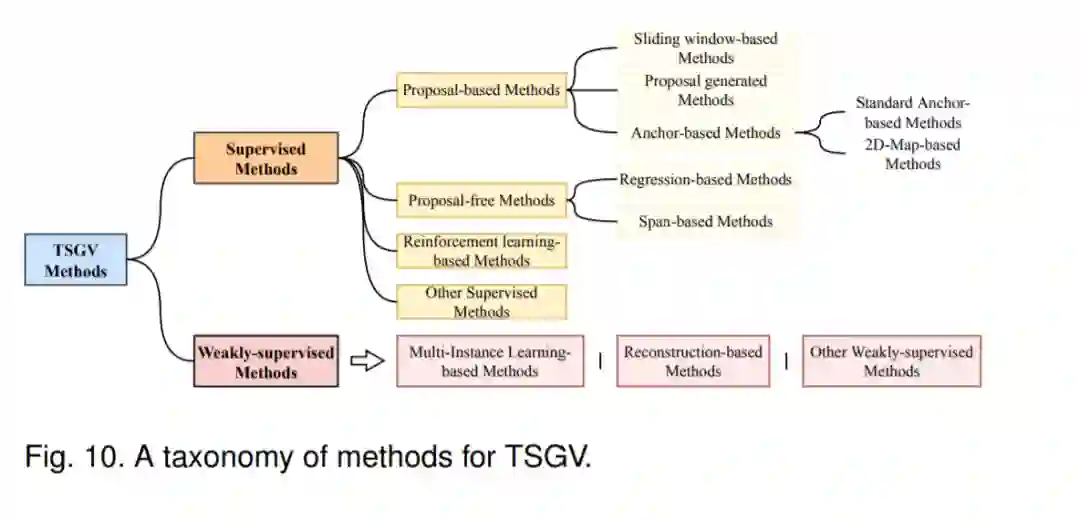

针对TSGV提出的大多数解决方案都属于监督学习范式。早期的解决方案主要依靠滑动窗口或分段提案网络对输入视频中的提案候选人进行预采样。然后,将proposal与查询配对,通过交叉模态匹配生成最佳答案。然而,这种两阶段的“proposal-排序”流程效率较低,因为密集的候选对象的采样与重叠是实现高精度的关键,导致了计算的冗余和效率的低下。同时,proposal-查询的两两匹配也可能忽略上下文信息。为了克服这些缺点,诸如基于锚和无提议的方法等替代解决方案被开发出来,以“端到端”的方式处理TSGV。这些方法对整个视频序列进行编码,并将所有视频信息保存在模型中,逐渐成为TSGV的主流解决方案。图9描述了TSGV在监督学习中发展的时序概述。有监督学习需要大量带注释的样本来训练TSGV方法。考虑到数据标注的难度和成本,近年来的研究尝试用弱监督学习来解决TSGV问题。这些方法通过学习视频查询对来减轻标注负担,而不需要详细标注视频中事件的时间位置。

因此,第2节对基于提案和无提案的方法进行了简单的分类,并不能很好地涵盖所有TSGV方法。基于方法的体系结构和学习算法,我们在图10中提出了一个新的分类方法来对TSGV方法进行分类。接下来,我们回顾了遵循这种分类法的TSGV解决方案,并讨论了每个方法类别的特征。由于大多数都是监督学习解决方案,本节主要根据监督学习下的类别来组织。

视频自然语言定位挑战与未来

尽管TSGV方法在基准数据集上取得了良好的性能,但由于TSGV方法和基准的局限性,影响了TSGV方法的实用性和泛化能力。在我们列出未来的研究方向之前,我们回顾了当前方法和基准的批判性分析。

- 高效特征提取

- TSGV多答案

- 时空自然语言定位

- 多模态自然语言定位

- 视频数据集片段检索

许多技术可以用来学习各种类型数据的密集表示,例如文本、视频和音频。通过多模态交互,像TSGV这样的跨模态应用变得可行。在这个综述中,我们从如何从文本和视频中提取特征开始,然后关注TSGV中这两类特征之间的交互作用。虽然TSGV的历史很短,但我们已经看到了从滑动窗口方法到基于proposal和无proposal的方法的发展趋势,然后从强化学习和弱监督学习对任务和解决方案的不同观点。与此同时,我们也看到了这一领域的挑战; 因此,在基准数据集上获得的结果不一定反映模型在现实中的性能。应对这些挑战肯定会改善当前的解决方案。此外,TSGV的解决方案作为一项基本任务,直接受益于视频中的时空句子定位、视频语料库时刻检索等相关应用。我们希望本综述查可以为研究这些有趣问题的研究者提供一个很好的参考。